مراقب ردپای دیجیتال خود باشید

فاطمه ناجی - هر حرکتی در دنیای دیجیتال، ردی بهجا میگذارد. این ردها کمکم تبدیل میشوند به تصویری که شاید هیچوقت خودت از خودت نداشتهای. در جهانی که هوش مصنوعی از خاطراتت هم دقیقتر تو را میشناسد، آیا هنوز میتوانی بگویی «خودت» را میشناسی؟

آیا تا به حال به این فکر کردهای که تمام کلیکهایت، هر جستوجو، هر پست، حتی چیزهایی که پاک کردهای، بخشی از داستان زندگی تو را برای کسانی روایت میکند که هرگز آنها را ندیدهای؟ اثری که در فضای آنلاین از خود به جا میگذاریم، چیزی فراتر از ردپاست؛ اسمش را گذاشتهاند «اثرانگشت دیجیتال». در ظاهر، این دادهها بیاهمیتاند. اما وقتی کنار هم چیده میشوند، میتوانند تصویری روشن از ما بسازند و تبدیل به ابزاری شدن برای شناختن، تحلیل کردن و گاهی هدایت کردن ما. آنقدر دقیق که گاهی خودمان هم نمیدانیم چطور تا این حد قابل پیشبینی شدهایم.

چطور ما را بهتر از خودمان میشناسند؟

تصور کن فقط با بررسی لایکهایت در اینستاگرام، الگوریتمی بتواند حدس بزند به چه چیزهایی علاقه داری، گرایش سیاسیات چیست، درونگرایی یا برونگراییات در چه حدیست، یا حتی چقدر از زندگیات رضایت داری. پژوهش معروفی در دانشگاه کمبریج نشان داد که فقط با ۱۰ لایک، الگوریتم بهتر از همکار تو را میشناسد؛ با ۷۰ لایک، از دوستت دقیقتر است؛ و وقتی به ۳۰۰ لایک برسد، حتی از همسرت هم تصویر کاملتری از تو دارد.

هوش مصنوعی از دادههای پراکنده و جزئی، الگو میسازد. شخصیتپردازی میکند. نقاط ضعف و قوت تو را شناسایی میکند و حتی احساسات پنهانت را بیرون میکشد. خیلی وقتها خودت هنوز نمیدانی چرا ناگهان حوصله نداری، ولی الگوریتم مدتهاست افتهای خلقیات را تشخیص داده. آنها تو را در زمانهایی که از خودت بیخبری، تحلیل میکنند.

این شناخت چه تبعاتی دارد؟

شناخته شدن همیشه به معنای دیده شدن نیست. گاهی یعنی قضاوت شدن، دستهبندی شدن، محدود شدن. این شناخت دیجیتال، اگر در دست نهادها، شرکتها یا دولتهایی باشد که به سود خود فکر میکنند، میتواند بهراحتی علیه ما بهکار رود:

• آسیب به شهرت و فرصتهای اجتماعی: چیزی که شاید سالها پیش در نوجوانی نوشتهای، هنوز در حافظه اینترنت باقی مانده. در بسیاری کشورها، شرکتها و کارفرماها قبل از استخدام، شبکههای اجتماعی متقاضیان را بررسی میکنند. اگر تصویری نادرست یا خارج از بستر زمانبندی واقعی از تو پیدا کنند، فرصتهایی را از دست خواهی داد، بدون آنکه حتی از دلیلش باخبر باشی.

• خطر هک و فیشینگ: هکرها نیازی به رمز عبور تو ندارند؛ کافیست ترکیب سادهای از اطلاعاتی مثل تولد، شماره مدرسه و یا علایق مشخصت را داشته باشند. دادههایی که بارها بیاحتیاط در فضاهای مختلف وارد کردهای. این حملات حالا بسیار شخصیتر و دقیقتر از گذشته انجام میشود.

• نابرابری دیجیتال: همه دسترسی یکسان به دانش، ابزار یا زبان محافظت از خود ندارند. بسیاری از افراد در حاشیه، سالمندان، کودکان یا کسانی با سواد دیجیتال پایین، نمیدانند داده چیست، ذخیرهسازیاش چگونه انجام میشود، یا اصلاً چرا باید برایشان مهم باشد. همین ناآگاهی آنها را در معرض سوءاستفاده و تبعیض قرار میدهد.

هوش مصنوعی و مهندسی اجتماعی

امروز الگوریتمها فقط تماشاگر رفتار ما نیستند؛ آنها طراح رفتار ما هم شدهاند. شرکتها با دادهها میفهمند که چه چیزی ما را عصبانی، هیجانزده یا میترساند. سپس محتوایی را به ما نشان میدهند که بیشترین واکنش احساسی را ایجاد کند — نه لزوماً مفیدترین یا دقیقترین محتوا.

در رسانههای اجتماعی، هوش مصنوعی فقط در حال خدمترسانی نیست؛ بلکه در حال شکل دادن به درک ما از واقعیت است. محتواها طوری تنظیم میشوند که درگیر شویم، بمانیم، بحث کنیم. حتی گاهی با دستکاری احساساتمان.

دولتها نیز در استفاده از این فناوریها جلوتر از مردماند. الگوریتمها برای پیشبینی و واکنش به بحرانها یا حتی دستهبندی شهروندان در قالبهای رفتاری به کار گرفته میشوند.

وقتی دادهها تبدیل به قضاوت میشوند

دادهها خنثی نیستند؛ آنها میتوانند قضاوتگر شوند. کافیست الگوریتمی تشخیص دهد که «احتمال افسردگی» در تو بالا رفته است؛ آیا این اطلاعات ممکن است به کارفرمایت برسد؟ آیا ممکن است صرفاً به خاطر پیشبینی یک مدل، از فرصتی محروم شوی؟ در واقع، این اثرانگشت دیجیتال که در ظاهر بیضرر به نظر میرسد، در عمل تبدیل میشود به یک تصویر روانشناختی دقیق که گاهی از قضاوت خودمان نسبت به خودمان هم نافذتر است. و همینجاست که خطر آغاز میشود؛ جایی که دادهها به جای آگاهیبخشی، ابزار کنترل، سانسور، یا تبعیض میشوند.

آیا همه چیز تاریک است؟

نه. این حجم از داده، اگر درست مدیریت شود، میتواند به نفع مردم کار کند. مثلاً پلتفرمهای آموزش آنلاین، با تحلیل دادههای یادگیری دانشآموزان، روند یادگیری را شخصیسازی میکنند و به دانشآموزانی که نیاز به کمک بیشتر دارند، خدمات اختصاصی میدهند.

در سلامت روان، با تحلیل الگوریتمی مکالمات آنلاین، پژوهشگران توانستهاند نشانههای اولیه افسردگی و اضطراب را شناسایی کنند و مداخله زودهنگام انجام دهند. در برنامهریزی شهری، دادههای تردد و رفتار مصرف انرژی، به ساختن شهرهایی هوشمندتر کمک کرده. اما این سودمندی فقط وقتی معنا دارد که فرد، آگاه و رضایتمندانه در این فرایند دخیل باشد. نه بهاجبار، نه بیخبر، نه بهقیمت حریم شخصی.

در نهایت…

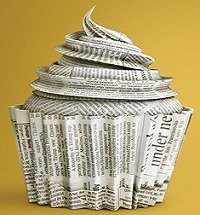

اثرانگشت دیجیتال، مثل ردپای پا در برف، چیزی از حضور ما به جا میگذارد. ولی اینبار برف آب نمیشود. این رد باقی میماند و میتواند ما را دنبال کند، ارزیابی کند، یا حتی تعریف تازهای از ما بسازد. باید بدانیم که کیستیم، چطور دادههایمان را مدیریت کنیم و از نهادهایی که آنها را جمعآوری میکنند، شفافیت و اخلاقمداری بخواهیم. چون اگر ما ندانیم که چطور خودمان را معرفی میکنیم، خیلیها آن بیرون از ما نسخهای خواهند ساخت که شاید هیچ نسبتی با خودِ واقعیمان نداشته باشد اما همان تصویر، آیندهمان را شکل خواهد داد.(منبع:تبیان)