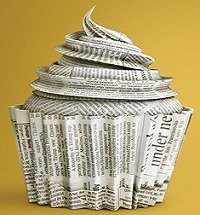

هوش مصنوعی و تولید زبالههای دیجیتال

پدیده «اسلاپ» یا زباله هوش مصنوعی، به محتوای گمراهکننده و بیکیفیتی اشاره دارد که توسط فناوریهای هوش مصنوعی تولید و فضای دیجیتال را آلوده میکند. این چالش، علاوه بر کاهش کیفیت اطلاعات، اعتماد کاربران را نیز خدشهدار کرده و نیاز به نظارت و پالایش بیشتر را بیش از پیش آشکار میکند.

نورنیوز- هوش مصنوعی در کنار مزایای بیشمارش، چالشهایی را نیز به همراه داشته است. یکی از این چالشها، پدیدهای به نام «اسلاپ» یا زباله هوش مصنوعی است که به محتوای بیکیفیت، گمراهکننده یا اضافی تولیدشده توسط این فناوری اشاره دارد. این زبالهها که اغلب در فضای آنلاین پراکنده میشوند، تهدیدی برای اطلاعات باکیفیت و تعاملات معنادار در فضای دیجیتال محسوب میشوند.

اسلاپ چگونه شکل میگیرد؟

تولید محتوای حجیم توسط ابزارهای هوش مصنوعی، بدون نظارت دقیق انسانی، یکی از عوامل اصلی ظهور اسلاپ است. این محتواها که ممکن است شامل اطلاعات نادرست، تکراری یا فاقد ارزش باشند از طریق الگوریتمهای طراحیشده برای حداکثر بازدهی تولید میشوند. به همین دلیل، دادههای زاید در فضای آنلاین به سرعت تکثیر میشوند و منابع اطلاعاتی معتبر را در انبوه این زبالهها محاصره میکنند.

چرا اسلاپ مهم است؟

اسلاپ نهتنها کیفیت اطلاعات آنلاین را کاهش میدهد، بلکه منجر به فرسایش اعتماد عمومی به محتواهای دیجیتال میشود. همچنین، این پدیده میتواند پیامدهای زیستمحیطی در دنیای دیجیتال داشته باشد؛ چراکه حجم عظیم دادهها به افزایش مصرف انرژی و کربن دیجیتال منجر میشود.

نقش فلسفه در مقابله با اسلاپ

فلسفه، بهویژه از منظر انتقادی و تحلیلی، میتواند به تفکیک زبالههای ذهنی و دیجیتال کمک کند. همانطور که مری داگلاس، انسانشناس بریتانیایی، زباله را «مادهای در مکان نادرست» تعریف میکند، میتوان اسلاپ را محتوای تولیدشده در بستری نادرست دانست. فلسفه با ارائه چارچوبهای فکری برای ارزیابی ارزش و صحت اطلاعات، میتواند ابزاری مؤثر برای پالایش فضای دیجیتال باشد.

چالش پیشرو

برای مقابله با اسلاپ، نیازمند بازنگری در نحوه تولید و مدیریت محتوای دیجیتال هستیم. افزایش آگاهی درباره پیامدهای این پدیده، ارتقای سواد دیجیتال و اخلاق هوش مصنوعی و تقویت نظارت انسانی میتوانند گامهایی مؤثر در این راستا باشند. همانطور که زبالههای فیزیکی تهدیدی برای محیط زیست هستند، زبالههای دیجیتال نیز سلامت اکوسیستم اطلاعاتی را تهدید میکنند.