| تحلیل وضعیت فناوری اطلاعات در ایران |

| تحلیل وضعیت فناوری اطلاعات در ایران |

جدیدترین ابزار هوش مصنوعی مایکروسافت به رایانه فرد یک حافظه عکاسی اضافه می کند، اما کارشناسان بیم آن دارند که قابلیت جدید حریم خصوصی فرد را به خطر بیندازد.

به گزارش خبرگزاری مهر به نقل از دیلی میل، این ابزار Recall نام دارد و به طور خودکار هر چند ثانیه یکبار اسکرین شاتی از لپ تاپ فرد ثبت می کند که کاربر بعدا می تواند بین آنها جستجو کند.

مایکروسافت مدعی است این اسکرین شات ها فقط در رایانه فرد ذخیره می شوند و کارمندان شرکت یا هر هکری از راه دور نمی تواند به آنها دسترسی یابد. با این وجود کارشناسان نگران هستند که اگر دستگاه کاربر در اختیار هکرها قرار گیرد، آنها راحت تر بتوانند از اطلاعات وی سواستفاده کنند.

به گفته کریس شریشاک یکی از مشاوران حوزه هوش مصنوعی و حریم خصوصی این ویژگی را یک کابوس حریم خصوصی نامیده است. او در این باره می گوید: همین واقعیت که اسکرین شات ها هنگام استفاده کاربر از دستگاه ثبت می شوند، تاثیر بدی بر کاربران دارد.

جیمز بور یکی از کارشناسان فناوری نیز معتقد است ابزار ثبت عکس مذکور می تواند اطلاعاتی مانند پسوردها، جزییات کارت هات های اعتباری یا اطلاعات ورود به حساب های کاربری را ذخیره کند.

اگر لپ تاپ در اختیار هکرها قرار گیرد، آنها به راحتی می توانند اطلاعات کاربر را به دست بیاورند.

رییس پژوهشگاه ارتباطات و فناوری اطلاعات در اجلاس جهانی WSIS با موضوع «چالشها و فرصتهای هوش مصنوعی و دولت الکترونیک» دستاوردهای دولت در حوزه هوش مصنوعی را تشریح کرد.

به گزارش پژوهشگاه ارتباطات و فناوری اطلاعات؛ نشست تخصصی با موضوع "هوش مصنوعی و دولت الکترونیک؛ فرصتها، چالشها و آینده" در اجلاس WSIS برگزار شد که در این نشست رضوی زاده، رئیس پژوهشگاه ارتباطات و فناوری اطلاعات دستاوردهای دولت در حوزه هوش مصنوعی را ارائه کرد.

محمد رضوی زاده در ابتدا با اشاره به پیشرفتهای کشور در حوزه هوش مصنوعی به ویژه در بحث دولت الکترونیک، اظهار کرد: هوش مصنوعی در توانمندسازی دولت ایران به ویژه دولت الکترونیک نقش شایانی دارد؛ در حال حاضر مدیریت منابع طبیعی و محصولات کشاورزی، احراز هویت بیومتریک، چت آنلاین دولت الکترونیک و نظرسنجی کارکنان دولت با استفاده از کدهای QR از جمله اقدامات مدیریتی دولت با استفاده از هوش مصنوعی در ایران است.

وی همچنین در ارتباط با مدیریت منابع و محصولات کشاورزی در ایران به وسیله هوش مصنوعی، گفت: در بحث سیستم کشاورزی هوشمند و با استفاده از ابزار AI، پروژهای با عنوان سطح زیر کشت محصولات کشاورزی تعریف شد که ۱۳ محصول استراتژیک کشور ایران را در یک برنامه سه ساله مورد آزمایش قراردادیم.

رئیس پژوهشگاه ارتباطات و فناوری اطلاعات در ادامه تشریح این پروژه در نشست تخصصی WSIS، بیان کرد: برنج، گندم، سیب زمینی، کلزا، گوجه فرنگی و دیگر محصولات استراتژیک کشور ایران در این پروژه مورد بررسی قرار گرفتند که با دقت زیادی در مقایسه با روشهای سنتی چیزی بیش از ۹۰ درصد همراه بود؛ این موضوع به دولت بسیار کمک میکند و موجب میشود تا تصمیم گیری های کلان در خصوص مدیریت منابع طبیعی مبتنی بر دادههای دقیق انجام شود و مدیریت محصول و بهرهوری کلی کشاورزی در کشور ایران بهبود پیدا کند.

رضوی زاده با اشاره به پروژه احراز هویت بیومتریک در ایران خاطرنشان کرد: احراز هویت سطح دو در ایران برای سیستمهایی که نیاز به ورود بیومتریک دارند، استفاده میشود؛ به عنوان مثال در سیستم تطبیق چهره افراد با عکس کارت ملی هوشمند با استفاده از الگوریتمهای بیومتریک و با استفاده از تلفن هوشمند یا رایانه تصاویر سه بعدی را با تصویر دوبعدی ثبت احوال کشور مقایسه میکند در حال حاضر حداقل یک میلیون کاربر در سال از این سیستم در کشور استفاده میکنند.

رئیس پژوهشگاه ارتباطات و فناوری اطلاعات در خصوص دیگر فعالیتهای دولت ایران به وسیله ابزار هوش مصنوعی، خاطرنشان کرد: سامانه ملی کاتالوگ و مجموعه دادههای باز و کاربردی کشور ۶ سال پیش رونمایی شد؛ در این سامانه ۷۷۳۷ مجموعه داده از ۳۸۳ سازمان در سیستم آپلود شده است. این سامانه یک زیرساخت مشترک برای به اشتراک گذاری مجموعه دادههای تولید شده توسط صاحبان داده ارائه میدهد و جست جو و بازیابی دادههای باز را با استفاده از عناوین، کلمات کلیدی، نام مالک و غیره تسهیل میکند که به ارزیابی دادههای موجود برای پروژههای ملی و سایر اهداف تحقیقاتی نیز کمک میکند.

رضوی زاده همچنین در پایان ارائه خود در این نشست تخصصی با اشاره به راهاندازی سامانهای برای پایش رضایت از خدمات و کارکنان دستگاههای اجرایی با استفاده از ابزار هوش مصنوعی در کشور، گفت: به وسیله ابزار هوش مصنوعی در این سامانه، اطلاعات پس از نظرسنجیهای ثبت شده بر اساس بارکدهای دو بعدی جمعآوری میشوند و سپس بعد از تجزیه و تحلیل خودکار، جهت بهبود عملکرد به ارائه پیشنهادات میپردازد که در نهایت این سیستم موجب بهینه سازی بهرهوری کارکنان دولت بر اساس نظرات مردم خواهد شد.

تینا مزدکی - رؤیاپردازی برای نوآور بودن بسیار مهم است. قدرت تصور کردن همان چیزی است که هوش مصنوعی ندارد، بنابراین نمیتواند رؤیاپردازی کند. به همین دلیل است که «ویکتور مایر شونبرگر» استاد علوم اطلاعات دانشگاه آکسفورد معتقد است که هوش مصنوعی (AI) در حال حاضر قادر به رقابت با خلاقیت انسان نخواهد بود. اما آیا تابهحال به این فکر کردهاید باوجود پیشرفتهای قابلتوجه هوش مصنوعی که در شرکتهای فناوری بزرگ صورت میگیرد، چرا سرعت نوآوری کند شده است؟

انسانها میتوانند چیزهایی را تصور کنند که هنوز وجود ندارند، اما هوش مصنوعی علیرغم اینکه با مجموعه دادههای عظیم آموزشدیده است، تنها با دادههایی کار میکند که درگذشته به او دادهشده است. درواقع هوش مصنوعی منعکسکننده چیزهایی است که ما میتوانیم از گذشته یاد بگیریم.

بینشها و پاسخهایی که هوش مصنوعی به ما میدهد برآوردی از همان اطلاعاتی است که درگذشته به او دادهشده، بنابراین نمیتواند چیز جدیدی اختراع کند. اگر زمان حال یا آینده بهطور قابلتوجهی با گذشته متفاوت باشد، هوش مصنوعی نمیتواند به ما دریافتن راهحلهای مناسب کمک کند؛ او فقط راهحلی را پیشنهاد میکند که ریشه در تجربههای گذشته دارد.

بنابراین هوش مصنوعی ابزاری برای ارزیابی مجموعه دادههای بزرگ و افزایش کارایی، بهویژه در زمانهای باثبات اقتصادی است، اما مسئله این است که هیچچیز در تاریخ تاکنون ثابت نبوده و نیست. چالشهای ناشی از تغییرات اقلیمی نیازمند نوآوریهایی فراتر از تواناییهای فعلی است.

سرعت نوآوری باوجود پیشرفتهای سریع در هوش مصنوعی به طرز عجیبی کاهش یافته است. «اوفوک آکیجیت» استاد اقتصاد در دانشگاه شیکاگو، و «سینا تیآتس» از هیئت مدیره فدرال رزرو ایالات متحده، کاهش رشد بهرهوری ایالاتمتحده را بررسی کردهاند. آنها میگویند نرخ ورود مشاغل جدید کاهش یافته، رشد بهرهوری کاهش یافته، سهم نیروی کار از تولید کاهش یافته و این در حالی است که تمرکز بازار و سهم سود شرکت از تولید ناخالص داخلی (GDP) افزایش یافته است.

محققان دریافتند که پویایی نوآوری در شرکتهای آمریکایی از دهه ۱۹۸۰ کاهش یافته است و در دهه ۲۰۰۰ این کاهش، چشمگیرتر بوده است. آنها دلیل این امر را رقابت ناکافی بین شرکتهای پیشرو و رقبای خود میدانند، تا حدی به این دلیل که دانش بهاندازه کافی به اشتراک گذاشته نمیشود. این امر مانع از آن میشود که آنهایی که دیرتر وارد بازار شدهاند از پیشرفتهای دیگران درس بگیرند و خودشان رشد کنند. درنتیجه، فشار رقابتی کمتری بر بازیگران بزرگ بازار وارد میشود که بدون رقابت، انگیزههای کمتری برای نوآوری دارند.

با کمک هوش مصنوعی میتوان مقادیر زیادی از دادهها را بهطور فزایندهای بهخوبی تجزیهوتحلیل کرد. بر اساس گزارش فدراسیون صنایع آلمان (BDI)، دادههای بیشتری در حال جمعآوری است و حجم آن بین سالهای ۲۰۱۲ تا ۲۰۲۲، ده برابر شده است و انتظار میرود تا سال ۲۰۲۵ دوباره سه برابر شود. اینجاست که شرکتهای دیجیتالی بزرگ مانند گوگل، آمازون و فیسبوک بازی را میبرند. این شرکتها حجم وسیعی از دادهها را جمعآوری میکنند، بنابراین کارآمدتر میشوند و درعینحال از دسترسی دیگران به دادههای خود جلوگیری میکنند.

شونبرگر بر این باور است که این غولهای دیجیتال هرچند بهعنوان پیشگام شناخته میشوند، اما درواقع فرآیندهای نوآوری و پیشرفت را با احتکار دادهها کاهش میدهند و این بهنوعی تقویت ساختارهای انحصاری است. این روزها شرکتهای نوآور بهسادگی توسط شرکتهای بزرگ خریداری شوند. حدود ۲۰ سال پیش، بیش از سهچهارم استارتآپهای موفق سیلیکونولی، سهامی عام شدن را انتخاب کردند. امروز، سهچهارم آنها توسط شرکتهایی مانند گوگل و فیسبوک قبل از عام شدن سهامشان بلعیده شدهاند.

محقق دانشگاه آکسفورد هشدار میدهد که این نهتنها مانع نوآوری میشود، بلکه خطر سیستماتیکی برای رشد اقتصادی نیز به همراه دارد. این وضعیت درست مانند زمانی است که در دنیا تنها یک نوع خودرو وجود داشته باشد و شما در بزرگراهی رانندگی میکنید که بهجز خودرو شما، ترمز تمام خودروها بریدهشده و هیچ چاره وجود ندارد. زیرا تنها یک نوع خودرو وجود دارد و این منجر به بحران میشود.

او گفت که این معضل تنها در صورتی قابلحل است که سیاستگذاران اطمینان حاصل کنند که دادهها آزادانه در دسترس عموم باشند. هیچ نوع مالکیتی برای دادهها وجود ندارد و نباید وجود داشته باشد. حقوق مالکیت معنوی، تألیف و حقوق ثبت اختراع که از طریق تفکر بشری ایجاد میشود، برای دادهها قابلقبول نیستند.

قانون خدمات دیجیتال اتحادیه اروپا و قانون بازارهای دیجیتال، گامهایی هستند که در جهت درستی برداشته شدهاند. سیستمهای آموزشی نیز باید بازسازی شوند تا انگیزههایی برای رؤیاپردازی هدفمند برای نسلهای بعدی فراهم شود. باید جهان را با چشمهای متفاوتی دید، زیرا نوآوری به افراد سختگوش نیاز دارد.(خبرآنلاین)

علی محمولی - هوش مصنوعی را باید مهمترین متغییر دوران حال و آینده بر فضای پیشرفت کشورها دانست. کشورهایی که قصد دارند جایگاه خود را در آینده جهان حفظ کرده یا ارتقا دهند، بر سرمایهگذاری هر چه بیشتر و بهکارگیری این فناوری نوین تمرکز کردهاند.

با این حال خطراتی از جانب این فناوری نیز وضعیت کشورها، بهویژه نیروی کار آنها را تهدید میکند. برای اینکه بتوانند از تمام مزایای هوش مصنوعی مولد و دیگر فناوریهای نوین استفاده کنند، اروپا و ایالاتمتحده نیز در این زمینه علاوهبر شتاب دادن به کاربرد این فناوریها در زیرساخت و اقتصاد خود، بر بهبود سرمایه انسانی نیز جهت جلوگیری از عوارض ناشی استفاده از این فناوریها تمرکز کرد

هاند. در ادامه گزارشی را میخوانید که توسط «گروه مکنزی و شرکا» -که از بزرگترین شرکتهای مشاور در امور کسبوکار و دولتهاست- تهیه شده است.

تغییر در نیاز به مشاغل در افق 2030

گزارش بر مقایسه بازار کار نه اقتصاد اصلی اتحادیه اروپا به همراه انگلستان در برابر ایالاتمتحده تمرکز دارد. فناوری که یکی از بارزترین نقاط عطف اخیر آن، ظهور هوش مصنوعی مولد است در کنار دیگر عوامل منجر به تغییر الگوی تقاضای نیروی کار تا سال 2030 میشود. تحقیقات براساس مدل بهروز شده از «آینده کار»، که توسط موسسه جهانی مکنزی ارائه شده، میباشد که بهدنبال تعیین کیفیت و کمیت تغییرات شغلی و تغییراتی است که در ماهیت تقاضا برای انواع مشاغل و توانمندیها بهوجود خواهد آمد. اروپا و ایالاتمتحده بهدلیل انقباض بازار کار و کاهش بهرهوری بهدلیل ظهور هوش مصنوعی و اتوماسیون مشاغل، در کنار دیگر موضوعات همچون هدفگذاری برای رسیدن به آلایندگی صفر، افزایش سن نیروی کار، رشد تجارت الکترونیک و همچنین زیرساختها و هزینهکرد فناوری در کنار رشد اقتصادی، شاهد تغییر در نیاز به نیروی کار در کشورهای خود خواهند بود. تحقیقات نشان میدهد تقاضا برای متخصصان حوزه بهداشت و دیگر مشاغل تخصصی مرتبط با علوم پایه، حد فاصل سالهای 2022 تا 2030، چیزی بین 17 الی 30 درصد رشد خواهد کرد. [نمودار یک]

در مقابل، تقاضا برای مشاغل حوزه خدمات غذایی، تولید، خدمات مشتریان، فروش و پشتیبانی اداری -که همگی شاهد کاهش در سالهای 2012 الی 2022 بودند، همچنان تا سال 2030 کاهشی خواهد بود. این مشاغل درحقیقت کارهایی هستند که در طول آن، فعالیتهایی بهطور مکرر تکرار شده یا داده جمعآوری شده و دادهها به شکلی ساده پردازش شده است؛ همه این کارها را میتوان با سامانههای خودکار و هوش مصنوعی به سهولت انجام داد.

یکسوم ساعات کاری تا 2030 قابل حذف است

تا سال 2030 بر طبق تحلیل، 27 درصد از ساعات کاری فعلی در اروپا و 30 درصد از ساعات کاری ایالاتمتحده را میتوان با استفاده از هوش مصنوعی مولد، خودکار کرد. مدل نشان میدهد تقریبا 20 درصد از ساعات کاری را میتوان حتی بدون نیاز به هوش مصنوعی مولد خودکار کرد.

این روندها، خود را در بازار کار در قالب کارکنانی نشان میدهند که باید شغل خود را تغییر دهند. براساس سناریوی بهکارگیری سریع فناوری که توسط ما مدلسازی شده، تا سال 2030 در اروپا 12 میلیون نفر مجبور به تغییر مسیر شغلی خود خواهند شد که معادل 6.5 درصد از کل نیروی کار فعلی این منطقه است و دو برابر روندی است که از پیش از همهگیری وجود داشت. [نمودار 2]

براساس سناریوی به کارگیری آهسته برای اروپا، مشاغلی که نیازمند تغییر هستند برابر با 8.5 میلیون نفر است که معادل 4.6 درصد از کارکنان فعلی است. در ایالاتمتحده این عدد میتواند به 12 میلیون نفر برسد که 7.5 درصد از کل شاغلان فعلی را شامل میشود. البته در ایالاتمتحده برخلاف اروپا، این امر با روند پیش از همهگیری همراستا و به یک اندازه است. مناطق مذکور در دوران کووید، شاهد وخامت بیشتری در وضعیت تغییر بازار کار بودند و هر چند این تغییرات برای بسیاری ناگهانی و دردناک بود، ولی با توجه به تحمیلی بودن ذاتی آنها تجربه نشان داده هر دو منطقه توانایی مدیریت تغییراتی در این مقیاس را خواهند داشت.

کسبوکارها محکوم به بهبود تواناییها

گذارههای شغلی که در بالا ذکر شد، خبر از تغییرات اساسی در مهارتهای نیروی کار در آیندهای را میدهند که اتوماسیون و هوش مصنوعی در محیط کار ادغام میشوند. کارکنان برای انجام یک کار مشخص، از چندین مهارت استفاده میکنند اما برای کمیتسنجی، مهارت غالب استفادهشده در آن کار شناسایی شده است.

تقاضا برای تواناییهای مرتبط با حوزه فناوری در سناریوی نقطه حد فاصل (که همان سناریوی پرسرعت برای اروپاست)، در اروپا و ایالاتمتحده افزایش خواهد داشت که معادل 25 درصد و 29 درصد از ساعات کاری، به ترتیب برای سالهای 2023 و 2022 است. تقاضا برای مهارتهای اجتماعی و احساسی نیز با 11 درصد در اروپا و 14 درصد در ایالاتمتحده مواجه خواهد شد. در بررسی افزایش، دلیل اصلی این موضوع، افزایش تقاضا برای نقشهایی است که نیازمند مهارتهای همدلی بینفردی و رهبری هستند.

این مهارتها در مشاغل حوزه بهداشت و مدیریت، در یک اقتصاد در حال تحول که نیازمند انعطافپذیری و سازگاری بیشتر است، بسیار مهم هستند. برعکس، تقاضا برای کارهایی که در آن مهارتهای شناختی پایه حرف اول را میزنند، به میزان ۱۴ درصد کاهش خواهد یافت. مهارتهای شناختی پایه، عمدتا در مشاغل پشتیبانی اداری یا خدمات مشتریان مورد نیاز است که بهشدت در معرض خودکارسازی توسط هوش مصنوعی قرار دارند. در میان مشاغلی که با نیاز به این مهارتهای شناختی اولیه شناخته میشوند و همچنین با کاهش قابل توجه تقاضا مواجه هستند میتوان به پردازش ابتدایی دادهها، سوادآموزی، مهارتهای عددی و ارتباطات اشاره کرد.

براساس این تحلیل، تقاضا برای کارهایی که نیازمند مهارتهای شناختی بالا هستند نیز ممکن است کمی کاهش یابد. درحالیکه انتظار میرود خلاقیت همچنان بسیار مورد تقاضا باشد و تا سال ۲۰۳۰ با افزایش بالقوه ۱۲ درصدی روبهرو شود، فعالیتهای شغلی که با سایر مهارتهای شناختی پیشرفته مانند سواد و نگارش پیشرفته، به همراه مهارتهای کمی و آماری شناخته میشوند، میتوانند با کاهش ۱۹ درصدی مواجه شوند.

از سوی دیگر تقاضا برای مهارتهای فیزیکی میتواند تقریبا در سطح فعلی باقی بماند. این مهارتها همچنان بخش عمدهای از توانمندیهای نیروی کار را تشکیل میدهند و حدود ۳۰ درصد از کل ساعات کار در سال ۲۰۲۲ را شامل میشوند. تقاضا برای این مهارتها بین سالهای ۲۰۲۲ و ۲۰۳۰ میتواند ناشی از توسعه زیرساختها و سرمایهگذاری بیشتر در بخشهایی با آلایندگی پایین باشد، درحالیکه کاهشها با تداوم خودکارسازی در کارهای تولیدی مطابقت خواهد داشت.

مدیران از کمبود مهارت گلایه دارند

براساس نظرسنجی که از مدیران ارشد (C-suite) در پنج کشور انجام شده است، شرکتها هماکنون با چالشهای مهارتی دستوپنجه نرم میکنند؛ ازجمله عدم تطابق مهارتها بهویژه در مهارتهای فناورانه، مهارتهای شناختی بالاتر و مهارتهای اجتماعی و عاطفی. بیش از یکسوم ۱۱۰۰ پاسخدهنده، کمبود را در این زمینههای حیاتی گزارش کردهاند. درعینحال تعداد قابل توجهی از مدیران میگویند به اندازه کافی کارمند با مهارتهای شناختی اولیه و تا حدودی کمتر در مهارتهای فیزیکی ندارند. در زمینه مهارتهای فناورانه، شرکتهای حاضر در نظرسنجی گزارش دادند که با کمبود قابل توجه در مهارتهای پیشرفته فناوری اطلاعات و برنامهنویسی، تحلیل پیشرفته داده و مهارتهای ریاضی مواجه هستند. در میان مهارتهای شناختی بالاتر، کمبودهای قابل توجهی در تفکر نقادانه و ساختاردهی مسائل و همچنین پردازش اطلاعات پیچیده مشاهده میشود. حدود ۴۰ درصد از مدیران ارشد مورد بررسی به کمبود نیروی کار با این مهارتها که برای کار با فناوریهای جدید ضروری است، اشاره کردند.

بازآموزی؛ راهحل اصلی شرکتها

مدیران ارشد مورد بررسی، انتظار تغییرات قابل توجهی را در سطح مهارت نیروی کار خود دارند و نگران عدمیافتن مهارتهای مناسب تا سال ۲۰۳۰ هستند. بیش از یک نفر از هر چهار پاسخدهنده به این نظرسنجی گفتند که عدم دستیابی به مهارتهای مورد نیاز میتواند مستقیما بر عملکرد مالی شرکت آسیب برساند و بهطور غیرمستقیم مانع از تلاشهایشان برای استفاده از هوش مصنوعی شود. شرکتها برای بهدست آوردن مهارتهای مورد نیاز خود، سه گزینه اصلی دارند؛ بازآموزی، استخدام یا استفاده از نیروهای پیمانکاری. نظرسنجی نشان میدهد مدیران اجرایی بهدنبال هر سه گزینه هستند و بازآموزی بهعنوان رایجترین تاکتیک برنامهریزیشده برای مقابله با عدم تطابق مهارتها گزارش شده است. بهطور متوسط از میان شرکتهایی که به بازآموزی بهعنوان یکی از تاکتیکهای خود برای مقابله با عدم تطابق مهارتها اشاره کردهاند، مدیران اجرایی آنها گفتهاند قصد دارند ۳۲ درصد از نیروی کار خود را بازآموزی دهند. البته مقیاس نیاز به بازآموزی از نظر درجه، متفاوت است. برای مثال پاسخدهندگان در صنعت خودروسازی انتظار دارند ۳۶ درصد از نیروی کارشان بازآموزی شوند، درحالیکه این رقم در صنعت خدمات مالی ۲۸ درصد است. از میان کسانی که به استخدام یا جذب پیمانکاری بهعنوان تاکتیکهای خود برای مقابله با عدم تطابق مهارتها اشاره کردهاند، مدیران اجرایی مورد بررسی گفتهاند که بهطور متوسط ۲۳ درصد از نیروی کار خود را استخدام و ۱۸ درصد را به شکل پیمانکاری جذب خواهند کرد.

کارکنان حقوق پایین با چالش مواجه میشوند

براساس این گزارش، هر 10 کشوری که در اروپا موردبررسی قرار گرفتهاند، ممکن است شاهد افزایش تقاضا برای مشاغل با درآمد بالا باشند. در مقابل، تحلیل نشان میدهد کارکنان در دو شغلی که با کمترین دهک دستمزدی قرار دارند، سه تا پنجبرابر بیشتر احتمال دارند که مجبور به تغییر شغل شوند و این مورد برخلاف کسانی است که درآمد بالایی دارند. این اختلاف در ایالاتمتحده بسیار بیشتر است، جایی که کارکنان در دو شغل با کمترین دستمزد تا ۱۴ برابر بیشتر از پردرآمدترین افراد با احتمال تغییر شغل روبهرو هستند. در اروپا جمعیت با درآمد متوسط ممکن است دوبرابر تحتتاثیر جابهجایی شغلی نسبت به جمعیت مشابه در ایالاتمتحده قرار گیرند که معادل ۷.۳ درصد از نیروی کار است و ممکن است با تغییر شغل مواجه شوند.

بهبود سرمایه انسانی همزمان با استفاده از فناوری

سازمانها و سیاستگذاران با گزینههایی روبهرو هستند که باید از بین آنها انتخاب کنند؛ رویکرد آنها به هوش مصنوعی و اتوماسیون، همراه با تقویت سرمایه انسانی، بر نتایج اقتصادی و اجتماعی تاثیر خواهد گذاشت. سعی شده تاثیرات بالقوه رویکردهای مختلف نسبت به تاثیر استفاده از هوش مصنوعی بر بهرهوری در اروپا در سطح بالایی کمیسازی شود. تحلیل دو بعد را در نظر میگیرد؛ بعد اول، نرخ استفاده از فناوریهای هوش مصنوعی و اتوماسیون است. سناریوی سریعتر و سناریوی آهستهتر را برای استفاده از فناوری درنظر میگیریم. استفاده سریعتر، پتانسیل رشد بهرهوری بیشتری را بههمراه خواهد داشت، اما ممکن است در کوتاهمدت، منجر به اختلالات نیروی کار بیشتری نسبت به سناریوی آهستهتر شود. بعد دوم موردبررسی ما، سطح زمانی است که کار خودکارشده نیروی کار، دوباره به اقتصاد اختصاص مییابد. این امر نمایانگر توانایی اختصاص مجدد زمانی است که از طریق اتوماسیون و افزایش بهرهوری بهدست میآید، مثلا ایجاد وظایف و مشاغل جدید. این امر میتواند بسته به موفقیت برنامههای بازآموزش نیروی کار و راهبردهای متعادل کردن عرضه و تقاضا در بازار کار متفاوت باشد.

تحلیل بر اساس دو سناریوی بالقوه استوار است یا همه کارکنان جابهجاشده قادر خواهند بود با سطح بهرهوری مشابه سال ۲۰۲۲ بهطور کامل به اقتصاد بازگردند یا تنها حدود ۸۰ درصد از زمان کارکنانی که متاثر از اتوماسیون شدهاند، دوباره به اقتصاد اختصاص خواهد یافت.

نمودار ۳ نتایج مختلف را از نظر نرخ رشد سالانه بهرهوری نشان میدهد. ربع بالا-راست، بالاترین بهرهوری در کل اقتصاد را با نرخ رشد سالانه تا 3.1 درصد نشان میدهد. این امر نیازمند پذیرش سریع فناوریها و همچنین بازگشت کامل کارکنان جابهجاشده به اقتصاد است. ربع بالا-چپ نیز نشاندهنده مسیر سریع استفاده از فناوری و نرخ رشد بهرهوری نسبتا بالا (تا 2.5 درصد) است. بااینحال حدود 6 درصد از کل ساعات کار، معادل 10.2 میلیون نفر که کار نمیکنند، به اقتصاد بازگردانده نمیشوند. درنهایت دو ربع پایین، عدم استفاده از هوش مصنوعی و اتوماسیون را بهتصویر میکشند که منجر به افزایش محدود بهرهوری و درنتیجه اختلالات محدود در بازار کار میشود.

۴ اولویت برای شرکتها

در عصر اتوماسیون و هوش مصنوعی، استفاده از فناوریهای اتوماسیون برای حفظ مزیت رقابتی کسبوکارها سرنوشتساز خواهد بود. مدیران کسبوکارها برای اطمینان از استقرار موفق در سطح شرکت، میتوانند چهار اولویت را درنظر بگیرند.

اولویت اول: درک پتانسیل

مدیران باید پتانسیل این فناوریها را درک کنند، بهخصوص اینکه هوش مصنوعی و هوش مصنوعی مولد چگونه میتوانند کارها را تقویت و خودکار کنند. این امر شامل برآورد کل ظرفیتی است که این فناوریها میتوانند آزاد کنند و همچنین تاثیر آنها بر ترکیب نقشها و نیازهای مهارتی است. درک این موضوع به رهبران کسبوکار اجازه میدهد استراتژی جامع و اهداف خود از بهکارگیری آنها را با توجه به خود فناوریها، سنجیده و چهارچوببندی کنند.

اولویت دوم: برنامهریزی برای جابهجایی راهبردی نیروی کار

زمانی که مدیران، پتانسیل فناوریهای اتوماسیون را درک کنند باید برنامهای برای آمادهسازی شرکت خود برای عصر هوش مصنوعی و اتوماسیون تدوین کنند. این امر مستلزم تعیین ابعاد نیروی کار و نیازهای مهارتی، براساس موارد استفادهای که بهشکل راهبردی شناسایی شدهاند، جهت ارزیابی کمبود بالقوه استعداد در آینده است. از این تحلیل، جزئیات مربوط به میزان جذب استعدادهای جدید، ارتقای مهارت یا بازآموزی نیروی کار فعلی و همچنین محل بهکارگیری مجدد ظرفیت آزادشده برای امور با ارزشافزوده بیشتر مشخص خواهد شد

اولویت سوم: توسعه نیروی انسانی

برای اطمینان از وجود استعدادهای مناسب برای حفظ راهبرد شرکت در طول همه مراحل تحول، مدیران میتوانند تقویت تواناییهای شرکت خود را برای شناسایی، جذب و استخدام رهبران آینده هوش مصنوعی و هوش مصنوعی مولد در بازار کار رقابتی را در نظر بگیرند. همچنین بهاحتمال زیاد نیاز به تسریع در ایجاد قابلیتهای هوش مصنوعی و هوش مصنوعی مولد را در نیروی کار خود خواهند داشت. استعدادهای غیرفنی نیز برای انطباق با محیط مهارتی درحال تغییر، نیاز به آموزش دارند. درنهایت رهبران میتوانند یک راهبرد منابع انسانی و مدل عملیاتی برای تناسب با نیروی کار پس از هوش مصنوعی مولد، طراحی و اجرا کنند.

اولویت چهارم: دنبال کردن مسیر آموزش مدیران ارشد

مدیران نیز باید حول فناوریهای اتوماسیون آموزش ببینند تا مشارکت را در شرکتهای خود درطول تحول آینده به حداکثر برسانند که باید شامل توانمندسازی مدیران ارشد برای کشف مفاهیم فناوری اتوماسیون و متعاقبا الگوسازی برای دیگران باشد. همچنین آنها باید همه مدیران شرکت را برای تدوین یک نقشهراه اختصاصی برای افزایش ارزش کسبوکار و کارکنان گردهم آورند. هوش مصنوعی و مجموعه فناوریهای جدید و پیشرفته، با سرعتی نفسگیر درحال رشد و تکامل هستند. این فناوریها برای شرکتها و سیاستگذاران بسیار جذاب هستند؛ چراکه وعده مجموعهای از مزایا ازجمله افزایش بهرهوری را میدهند که میتواند منجر به رشد اقتصادی و رفاه بیشتر شود. بااینحال همانطور که این گزارش تلاش کرده نشان دهد لازمه استفاده کامل از این مزایا، توجه به عنصر مهم سرمایه انسانی است. در بهترین سناریو، مهارتهای کارکنان با چالشهای فناورانه جدید سازگار شده و توسعه خواهد یافت. دستیابی به این هدف در عصر جدید فناورانه ما، بسیار چالشبرانگیز است، اما مزایای آن نیز به همان اندازه، چشمگیر و سودمند خواهد بود. (منبع:فرهیختگان)

دبیر ستاد توسعه فناوریهای هوش مصنوعی و رباتیک معاونت علمی، فناوری و اقتصاد دانشبنیان ریاستجمهوری از اختصاص اعتبارات ۵ همتی به مرکز ملی هوش مصنوعی خبر داد و گفت: قرار است پردازنده گرافیکی و تراشههای با قدرت پردازش بالا، وارد کرده و در اختیار شرکتهای بخش خصوصی و دانشبنیان، دانشگاهها و پژوهشگاهها و مراکز و اساتید تحقیقاتی هوش مصنوعی با قیمت نازل قرار دهیم.

بهروز مینایی در حاشیه «اولین رویداد بهکارگیری هوش مصنوعی در بخش تولید برق؛ تحولات و نوآوریها» در گفتوگو با ایسنا، با اشاره به جزئیات سند ملی هوش مصنوعی و برنامه هفتم توسعه در حوزه هوش مصنوعی، گفت: بر اساس این سند همه دستگاهها موظف هستند ظرف ۶ ماه سند خود را تهیه کرده و در اختیار وزارت ارتباطات و فناوری اطلاعات قرار دهند. کلیه این اسناد در مرکز ملی فضای مجازی جمعآوری خواهد شد تا نگاشت نهایی سند ملی هوش مصنوعی در کشور لحاظ شود.

وی با اشاره به برخی از مصوبات این حوزه، اظهار کرد: ایجاد ۷ آزمایشگاه ملی تصویب شده که از جمله آن میتوان به آزمایشگاههای ملی کوانتوم، زیست فناوری و مرکز آفرینش هوش مصنوعی اشاره کرد که آزمایشگاه هوش مصنوعی در سال جاری راهاندازی خواهد شد.

مینایی با بیان اینکه معاونت علمی ریاستجمهوری قرار است این مرکز ملی هوش مصنوعی را در چند لایه مدیریت کند، خاطرنشان کرد: در گام نخست در زمینه ایجاد زیر ساختهای هوش مصنوعی در کشور تسهیلگری کند و زیر ساخت پردازنده گرافیکی را ایجاد کرده و پردازنده گرافیکی و تراشههای با قدرت پردازش بالای این حوزه را وارد کند و در اختیار شرکتهای بخش خصوصی و دانشبنیان، دانشگاهها، پژوهشگاهها و مراکز و اساتید تحقیقاتی هوش مصنوعی با قیمت نازل قرار دهیم.

وی ایجاد، بسط و توسعه پلتفرمهای اشتراکگذاری داده در کشور را اقدام دیگر در حوزه توسعه هوش مصنوعی ذکر کرد و ادامه داد: تا داده نباشد، الگوریتمهای هوش مصنوعی نمیتوانند کاری انجام دهند و حتما لازم است همه دستگاهها، بر اساس قانون «دوام» مجلس که تصویب شده، دادهها و اطلاعات ملی را در اختیار دانشگاهها و مراکز علمی قرار دهند.

مینایی، لایه سوم حمایتها در حوزه هوش را مقیاس پذیری عمودی (Vertical Scaling) روی هوش مصنوعی به صورت تخصصی عنوان کرد و گفت: هوش مصنوعی در حوزه سلامت، فینتک و امور تجاری و در حوزه امور صنعتی که اصطلاحا دوقلوی دیجیتال Digital Twin نامیده میشود و هوش مصنوعی در حوزه بیگ دیتا در حوزه زبان فارسی برای اپراتورهای کشور از جمله آنها به شمار میرود.

وی اضافه کرد: پژوهشگران علاقهمند به توسعه فناوریهای هوش مصنوعی لایه چهارم حمایتی ما قرار میگیرند.

دبیر ستاد توسعه فناوریهای هوش مصنوعی و رباتیک معاونت علمی ریاستجمهوری، تاکید کرد: در برنامه هفتم توسعه قرار است همه این مسائل فعال شوند، بهویژه توسعه هوش مصنوعی صنعتی در حوزههایی چون وزارت نیرو، آبفای کشور، برق حرارتی و نفت، چرا که همزادهای دیجیتالی میتواند در ارتقای بهرهوری در تولید، انتقال و توزیع انرژی در کشور مؤثر باشد.

مینایی، افزایش بهرهوری در حوزه انرژی را به معنای اقتصاد و زندگی بهتر دانست و افزود: توسعه هوش مصنوعی در حوزههای علوم انسانی نیز دیده شده، به گونهای که درس ۳ واحدی برای همه رشتههای علوم انسانی و مهندسی را طراحی کردیم که در مهر ماه سال جاری ارائه خواهد شد و از این طریق همه رشته های تحصیلی با هوش مصنوعی و کاربردهای آن آشنا خواهند شد.

وی با تاکید بر اینکه با این سند تحولات خوبی در حوزه هوش مصنوعی ایجاد میشود، یادآور شد: قطعا در جاهایی که پلتفرم داده وجود ندارد، باید پلتفرمهای داده و ایجاد بسترهای ذخیرهسازی داده و به اشتراک گذاری داده فراهم شود.

مینایی افزود: از سوی دیگر در نهادهایی که این پلتفرم وجود دارد مانند حوزه برق حرارتی، بر روی تحلیل دادهها از طریق ایجاد Data Lake (بستری برای ذخیره انواع مختلف داده های خام با فرمت اصلی و دست نخورده آنها) و همچنین ایجاد Data Warehouse (محل ذخیره داده های ساختاریافته) اقدام شود تا داشبوردهای خوب اطلاعاتی در اختیار مدیران و تصمیمگیران قرار گیرد.

دبیر ستاد توسعه هوش مصنوعی و رباتیک معاونت علمی ریاستجمهوری در خصوص اعتبارات این حوزه، اظهار کرد: اعتبارات خوبی برای مرکز ملی هوش مصنوعی در نظر گرفته شد که بالغ بر ۲.۴ همت است که برای واردات جی پی یو (پردازنده گرافیکی) صرف خواهد شد و این میزان تا ۵ همت افزایش مییابد، ضمن آنکه احتمالا با مشارکت اپراتورها و بنیاد مستضعفان تا ۱۰ همت افزایش یابد.

مینایی اضافه کرد: برای مرکز ملی هوش مصنوعی صحبت از اعتبارات ۲۰ همتی بوده است تا صرف توسعه الگوریتمها و هوش مصنوعی شود، ولی اعتبارات ۵ همتی برای این مرکز حتمی است.

وی در خصوص سرمایهگذاری بخش خصوصی، گفت: برای سرمایهگذاری بخش خصوصی در حوزه هوش مصنوعی نیز با زیر ساختهایی که بخش دولتی در اختیار خصوصی قرار داده است، مشارکت خوبی ایجاد شده است.

مینایی از برگزاری رویداد همایشی با عنوان IA سامیت در مهرماه سال جاری خبر داد و گفت: در این همایش سرآمدان هوش مصنوعی در کشور حضور دارند، ضمن آنکه قرار است «جایزه هوش مصنوعی» اعطا شود.

وی خاطرنشان کرد: این اقدامات نشان میدهد که بخش خصوصی و مشارکت مردمی که نخبگان کشور در تولید هوش مصنوعی هستند، بسیار فعال است.

کمیته امورخارجه مجلس آمریکا به ارائه لایحه ای رای داد که محدود کردن صادرات سیستم های هوشمند را برای دولت بایدن تسهیل می کند.

به گزارش خبرگزاری مهر به نقل از رویترز، در این لایحه به نگرانی ها درباره سواستفاده چین از آنها برای تقویت قابلیت های نظامی خود اشاره شده است.

لایحه مذکور همچنین به وزارت بازرگانی اختیار می دهد تا از همکاری شهروندان آمریکایی با افراد خارجی جهت توسعه سیستم های هوش مصنوعی جلوگیری کند که ریسکی برای امنیت ملی کشور به حساب می آیند.

مک کال که رییس کمیته است در این باره هشدار داد: بدون این قانون شرکت های برتر هوش مصنوعی ما ممکن است به صعود فناورانه چین کمک و قابلیت های نظامی و بلندپروازی های مخرب این کشور را تقویت کنند.

او در ادامه افزود: در حالیکه به نظر می رسد حزب کمونیست چین به دنبال گسترش دستاوردهای فناورانه خود در حوزه نظارت دولتی و جنگ افزار است، ما باید از اینکه فناوری های حساس مان به دست آنها بیفتد، جلوگیری کنیم.

این لایحه هم اکنون باید توسط مجلس و همچین سنای آمریکا تایید و سپس توسط رییس جمهور این کشور امضا شود تا به صورت قانون درآید.

لایحه مذکور جدیدترین اقدام واشنگتن برای سرکوب کردن بلندپروازی های هوش مصنوعی چین است.

شرکت گوگل برای رشد و توسعه هوشمصنوعی ۱ میلیارد یورو در فنلاند سرمایهگذاری خواهد کرد. شرکت گوگل برای رشد و توسعه هوشمصنوعی ۱ میلیارد یورو در فنلاند سرمایهگذاری خواهد کرد.

به گزارش برنا؛ گوگل در بیانیهای اعلام کرد که ۱ میلیارد یورو دیگر را برای گسترش محوطه مرکز اطلاعات خود در فنلاند سرمایهگذاری خواهد کرد تا رشد کسب و کار هوش مصنوعی (AI) خود را در اروپا افزایش دهد.

شرکت گوگل علاوه بر سرمایهگذاری در فنلاند، مراکز داده جدیدی را در هلند و بلژیک ایجاد خواهد کرد.

در حال حاضر ظرفیت تجدیدپذیر برای مراکز داده مانند گوگل وجود دارد که انرژی بادی را در فنلاند تحت قراردادهای بلند مدت به دست میآورد.

تحلیلگران معتقدند که مصرف برق مراکز داده به دلیل رشد سریع استفاده از هوشمصنوعی به طور گستردهای افزایش خواهد یافت، که گوگل نیز به یکی از دلایل تصمیم سرمایهگذاری خود اشاره کرد، در کنار مرکز داده Hamina در فنلاند که در حال حاضر با انرژی ۹۷ ٪ بدون کربن کار میکند.

اگر مایکروسافت تا 27 می اطلاعات کافی درباره ریسک های ناشی از ویژگی های هوش مصنوعی در موتور جستجوی بینگ فراهم نکند، ممکن است اتحادیه اروپا این شرکت را جریمه کند.

به گزارش خبرگزاری مهر به نقل از رویترز، کمیسیون اتحادیه اروپا روز جمعه اعلام کرد درباره انتشار دیپ فیک ها و دستکاری خودکار سرویس ها که ممکن است رای دهندگان را گمراه کند، نگران است. این سازمان اعلام کرد اقدامات اجرایی در این زمینه را بیشتر کرده زیرا مایکروسافت به درخواست آن برای دریافت اطلاعات که در 14 مارس ارسال شده، پاسخی نداده است.

اگر مایکروسافت در مهلت تعیین شده، اقدامات لازم را انجام ندهد، کمیسیون اتحادیه اروپا می تواند تا یک درصد درآمد سالانه همراه جریمه های دوره ای تا سقف 5 درصد متوسط درآمد روزانه شرکت، مایکروسافت را جریمه کند.

همچنین اگر شرکت اطلاعات گمراه کننده یا نادرست ارائه کند با جریمه روبرو خواهد شد.

طبق قانون سرویس های دیجیتال اتحادیه اروپا که از سال گذشته اجرایی شد، شرکت های فناوری موظف هستند اقدامات بیشتری برای مقابله با محتوای مخرب و غیر قانونی در پلتفرم هایشان انجام دهند.

کمیسیون اتحادیه اروپا معتقد است هوش مصنوعی مولد یکی از ریسک های پیش روی یکپارچگی فرایندهای انتخاباتی به خصوص در حوزه انتخابات آتی پارلمانی این منطقه است که در ژوئن سال جاری میلادی برگزار می شود.

تحقیقی جدید حاکی از آن است که سیستم های هوش مصنوعی برخلاف تصورات می توانند فریبکارانه عمل کنند و انسان ها را گول بزنند.

به گزارش خبرگزاری مهر به نقل از گیزموچاینا، به نظر می رسد محققان MIT سعی دارند درباره هوش مصنوعی فریبکار هشدار دهند. تحقیقی جدید نشان می دهد سیستم های هوش مصنوعی که طوری طراحی شده اند تا صادق باشند، اکنون فریب دادن انسان ها را آموخته اند.

گروهی از محققان به رهبری پیتر پارک متوجه شدند این سیستم های هوش مصنوعی می توانند کارهایی مانند گول زدن بازیکنان بازی های آنلاین یا دور زدن فرایندهای کنترل ربات نبودن کاربر (CAPTCHA) را انجام دهند. پارک هشدار داده این نمونه های آزمایشی ممکن است در دنیای واقعی پیامدهای جدی داشته باشند.

تحقیق مذکور سیسرو (سیستم هوش مصنوعی متا) را برجسته کرده که در اصل به عنوان یک رقیب جوانمرد در بازی دیپلماسی مجازی در نظر گرفته شده بود. هرچند این سیستم هوش مصنوعی طوری برنامه ریزی شده تا صادق و کارآمد باشد اما سیسرو به یک فریبکار حرفه ای تبدیل می شود به گفته پارک طی بازی، سیسرو نقش فرانسه را داشت که طور مخفیانه با بازیکن آلمانی که توسط انسان کنترل می شد همکاری و به انگلیس دیگر بازیکن انسانی خیانت کرد. در این بازی سیسرو قول داده بود از انگلیس حمایت کند و همزمان برای حمله به این کشور به آلمان اطلاعات می داد.

در یک مثال دیگر از جی پی تی ۴ استفاده شد که سیستم ادعا می کرد نابینا است و یک انسان را برای دور زدن فرایندCATCHA به جای خود به کار گرفت.

پارک تاکید دارد چالش آموزش سیستم هوش مصنوعی صادق بسیار جدی است. سیستم های هوش مصنوعی یادگیری عمیق برخلاف نرم افزارهای سنتی طی فرایندی گزینشی روی می دهد. رفتار آنها طی فرایند آزمایش قابل پیش بینی است اما ممکن است بعدا قابل کنترل نباشد.

در هر حال این پژوهش از محققان خواسته سیستم های هوش مصنوعی فریبکار را به عنوان ابزارهایی با ریسک بالا طبقه بندی کنند.

دوره آموزشی فشرده مهارتمحور «رسانه در عصر هوش مصنوعی» با حمایت همراه اول و در قالب بوتکمپ در دانشگاه علامه طباطبایی برگزار شد.

به گزارش اداره کل ارتباطات شرکت ارتباطات سیار ایران، نخستین جشنواره فناورانه روابطعمومی که با حمایت همراه اول از 22 اردیبهشت ماه در دانشگاه علامه طباطبایی آغاز به کار کرده و تا روز چهارشنبه 26 اردیبهشت ماه ادامه دارد، در دومین روز اجرای خود به سراغ بوتکمپ «رسانه در عصر هوش مصنوعی» رفت.

این دوره آموزشی فشرده مهارت محور نیز با حمایت همراه اول و با هدف توانمندسازی دانشجویان و فعالان حوزه ارتباطات برای ورود به بازارهای جدید کاری و اشتغال، عصر روز یکشنبه 23 اردیبهشت 1403 برگزار شد.

این دوره که با راهبری رامین طوسی، فعال حوزه هوش مصنوعی و دارای مدرک دکتری مخابرات سیستم از دانشگاه تهران برگزار شد، ضمن مرور مقدمات و مفاهیم پایه، به تشریح اقدامات بین المللی در زمینه ایجاد پیوند بین صنعت رسانه و هوش مصنوعی پرداخت. در نهایت با معرفی ابزارهای ترند و کاربردی در این بخش، نحوه کار با هر کدام از آنها به صورت تخصصی برای دریافت بهترین خروجی تشریح شد.

استفاده از ابزارهای هوش مصنوعی که این روزها در حوزه «رسانه» رونق دارد و روزنامه نگاران و خبرنگاران به شکل های مختلفی در حال بهره برداری از ظرفیت های آن هستند، کمک می کند تا حجم زیادی از داده ها به سرعت و با کارآمدی بالا تجزیه و تحلیل شوند.

این ابزارها به اهالی رسانه اجازه می دهد تا گرایش ها و بینش هایی که ممکن است نادیده گرفته شده باشند را کشف کنند.

هوش مصنوعی همچنین می تواند به بررسی واقعیت و تأیید اطلاعات کمک و روند صحت سنجی گزارش های خبری را تسریع کند. ابزارهای توسعه یافته در این حوزه که قابلیت تولید محتوا در قالب های مختلفی را دارند، به روزنامه نگاران کمک می کند تا محتواهای خود را برای مخاطبان شخص سازی کنند تا منجر به خلق داستان هایی جذاب تر برای آنان شود.

به طور کلی ترکیب ابزارهای هوش مصنوعی در روزنامه نگاری، می تواند با ساده سازی فرآیندها، منجر به بهبود شاخص دقت شده و کیفیت کلی گزارش های خبری را ارتقا بخشد.

از آن جهت که ابزارهای هوش مصنوعی می تواند کارایی و بهره وری روزنامه نگاران و خبرنگاران را به میزان قابل توجهی افزایش دهد، نیاز است که این قشر کار با ابزارها را برای ایجاد و تولید محتوا بیاموزند.

علاوه بر این، ابزارهای هوش مصنوعی می تواند به خودکارسازی وظایف تکراری کمک کند و همانطور که گفته شد به تجزیه و تحلیل داده ها و بررسی واقعیت ها بپردازد و به روزنامه نگاران این امکان را بدهد که بیشتر بر روی ساختن داستان های جذاب تمرکز کنند.

دستیابی سریع به بینش ها و روندهای ارزشمند از مجموعه داده های بزرگ، نیز از دیگر مزایای کار با ابزارهای هوش مصنوعی است و به تولید محتوای آگاهانه تر و تاثیرگذارتر کمک می کند.

روزنامه نگاران در سراسر جهان به طور فزاینده ای از ابزارهای هوش مصنوعی برای بهبود فرآیندهای گزارش دهی و تولید محتوا استفاده می کنند؛ کشورهایی مانند آمریکا، انگلیس، چین، ژاپن و آلمان از جمله پذیرندگان پیشرو فناوری هوش مصنوعی در روزنامه نگاری هستند.

بررسی مدل های هوش مصنوعی مولد مانند ChatGPT که اکنون به مرحله ای از رشد رسیده اند و می توانند با مسائل روبرو شوند (مثلا یک مسئله ریاضی را حل کنند)، از دیگر مباحث مطرح در این بوتکمپ بود.

در این دوره آموزشی کاربردی، به فعالیت برخی شرکت های پیشرو در حوزه هوش مصنوعی در کشور نظیر «همراه اول» هم اشاره و گفته شد که در یک نمونه از فعالیت های هوش مصنوعی اپراتور اول تلفن همراه کشور، دو سال گذشته روی پروژه تولید جلوه های ویژه بصری کار کرد.

این پروژه به کاربران اجازه می داد با موبایل خودشان ویدیویی را ضبط کرده و بارگذاری کنند؛ سپس با انتخاب کاراکتر انیمیشنی موردنظر خود، این کاراکتر به جای آنها حرکت و صحبت کند که در واقع بسیار کمک کننده برای خلق ویدیوهای زیاد و ساده بود.

گفتنی است در جریان برگزاری این بوتکمپ، مجموعه ای از ابزارهای هوش مصنوعی دستیار تولید و توزیع محتوای خبری، تولید و ویرایش عکس و ویدیو، ایجاد زیرنویس اتومات، خلق محیط واقعیت افزوده، تولیدکننده جلوه های ویژه، تولیدکننده موسیقی، نظارتی محتوا و... معرفی، نحوه کار با آنها تشریح و نقاط قوت و ضعف هر کدام بررسی شد.

شرکت اوپنایآی(OpenAI) میگوید میتواند تصاویری را که توسط نرمافزار خودش ساخته شدهاند، تشخیص دهد و در حال آزمایش ابزار جدیدی برای این منظور است، اما این ابزار برای تصاویر سایر مدلها یا تصاویری که دستکاری شدهاند، کارآمد نیست و این تهدید بزرگی است.

به گزارش ایسنا، همه ما فکر میکنیم که در شناسایی تصاویر ساخته شده توسط هوش مصنوعی بسیار خوب هستیم، چرا که تاکنون عادت داشتهایم تصاویری که توسط هوش مصنوعی ساخته میشوند را همراه با نقصهای گاه فاحش و گاه ظریف ببینیم که تشخیص ساختگی بودن آنها را برایمان آسان میکرد.

به نقل از انگجت، با این حال فناوری به طور دائم در حال پیشرفت است و زمان زیادی نخواهد گذشت تا ببینیم دیگر نمیتوانیم بگوییم چه چیزی واقعی است یا توسط هوش مصنوعی تولید شده است.

اکنون رهبر صنعت توسعه هوش مصنوعی یعنی شرکت اوپنایآی در تلاش است تا با ایجاد مجموعه ابزاری که تصاویر ایجاد شده توسط هوش مصنوعی مولد DALL-E ۳ خود را شناسایی میکند، بر این مشکل غلبه کند.

این شرکت میگوید که میتواند تصاویری را که توسط DALL-۳ ساخته شده است، در ۹۸ درصد مواقع به دقت تشخیص دهد که دقتی بسیار عالی است. با این حال، برخی نواقص وجود دارند. اول از همه اینکه یک تصویر باید حتما توسط DALL-E ایجاد شده باشد و عیب اینجاست که این هوش مصنوعی تنها هوش مصنوعی در دسترس برای تولید تصاویر نیست.

در حالی که فضای اینترنت از تصاویر تولید شده توسط هوش مصنوعی پر شده است، بر اساس دادههای ارائه شده توسط اوپنایآی، سیستم آن تنها موفق شد ۵ تا ۱۰ درصد از تصاویر ساخته شده توسط سایر مدلهای هوش مصنوعی را با موفقیت تشخیص دهد.

همچنین اگر تصویر به هر نحوی اصلاح شده باشد، این ابزار تشخیصی با مشکل مواجه میشود. البته در مورد تغییرات جزئی مانند برش و فشردهسازی به نظر نمیرسد که این موضوع چندان مهم باشد. در این موارد، میزان موفقیت کمتر بود، اما همچنان در محدوده قابل قبولی در حدود ۹۵ تا ۹۷ درصد بود. با این حال اصلاح رنگ، میزان موفقیت را به ۸۲ درصد کاهش داد.

اینجا جایی است که همه چیز پیچیده میشود، چرا که این ابزار زمانی که برای تشخیص و طبقهبندی تصاویری که دستخوش تغییرات گستردهتری شده بودند، استفاده شد، با مشکل مواجه شد. اوپنایآی حتی میزان موفقیت در این موارد را نیز منتشر نکرد و به گفتن اینکه سایر تغییرات میتوانند عملکرد این ابزار را پایین بیاورند، بسنده کرد.

این یک اتفاق ناگوار است، چرا که تصاویر تولید شده توسط هوش مصنوعی پس از دستکاری ایجاد و تغییرات و اصلاح میتوانند آثار سوئی بر مردم داشته باشند.

حداقل اوپنایآی در مورد محدودیتهای فناوری تشخیص خود شفاف است. این شرکت همچنین به آزمایش کنندگان خارجی دسترسی به ابزارهای ذکر شده را برای کمک به رفع این مشکلات میدهد.

اوپنایآی همراه با مایکروسافت، ۲ میلیون دلار برای چیزی به نام صندوق تاب آوری اجتماعی(Societal Resilience Fund) سرمایهگذاری کرده است که امیدوار است آموزش و سواد در حوزه هوش مصنوعی را افزایش دهد.

آخرین گزارش سالانه ارائهدهنده تأیید هویت Sumsub نشان میدهد: موارد کلاهبرداری هویت مرتبط با دیپفیک، بین سالهای 2022 تا 2023 در بسیاری از کشورهای جهان بهشدت افزایش یافته است؛ مثلاً تعداد تلاشهای کلاهبرداری بهاینروش در «فیلیپین» در بازه یکساله یادشده 4500درصد افزایش یافته؛ و پسازآن، «ویتنام»، «ایالاتمتحده» و «بلژیک» قرار دارند.

به گزارش سایه باتوجهبهاینکه قابلیتهای «هوش مصنوعی» روزبهروز بیشتر میشود، تلاشهای کلاهبرداری عمیق میتوانند به مناطق دیگر نیز سرایت کنند.

«پاول گلدمن-کالایدین» (رئیس واحد تحقیقات هوش مصنوعی و یادگیری ماشینی Sumsub) میگوید: «در سالهای اخیر شاهد بودهایم که دیپفیکها بیشتر و بیشتر قانعکنندهتر شدهاند و این ادامه مییابد و به انواع جدیدی از فریبها منشعب میشود؛ همانطورکه حالا در دیپفیکهای صوتی و تصویری دیده میشود».

در هشدار فوقالذکر؛ هم مصرفکنندگان و هم شرکتها باید مراقب فریب مصنوعی بوده و بهدنبال راهحلهای چندلایه ضدِفریب بگردند.

یک نظرسنجی از 199 مرجع راهبرِ امنیت سایبری که در نشست سالانه «مجمع جهانی اقتصاد» (2023) شرکت کرده بودند، نشان داد که 46درصد از پاسخدهندگان، بیشترین نگرانی را درمورد «پیشرفت قابلیتهای خصمانه، فیشینگ، توسعه بدافزار و جعل عمیق» را بهواسطه توسعه AI دارند.

این دادهنما میزان افزایش کلاهبرداریها بهواسطه دیپفیک را (بهدرصد) طی بازه 2022 تا 2023 در جوامع مختلف نشان میدهد.

هوش مصنوعی به عنوان ابزاری جدید که هنوز بسیاری از وجوه آن ناشناخته است، به هر حوزهای که ورود کند میتواند حساسیتهایی را برانگیزد و نگرانیهای را ایجاد کند، اما شاید حساسترین حوزهای که بیم آن میرود مضرات هوش مصنوعی در آن بیش از مزایایش باشد، عرصه سیاست است. تا کنون سیاستمداران و پژوهشگران سیاسی بسیاری در مورد توسعه روزافزون و بیقاعده هوش مصنوعی هشدار داده و خطراتی را برای ورود آن به سیاست ترسیم کردهاند. «هنری کیسینجر»، وزیر اسبق امور خارجه آمریکا، از آن دسته پژوهشگرانی بود که دید مثبتی نسبت به ورود هوش مصنوعی به سیاست نداشت. او بر این اعتقاد بود در شرایطی که احتمال جنگ چین و آمریکا وجود دارد، هوش مصنوعی میتواند به یک تسلیحات دیجیتالی در دست قدرتهای بزرگ تبدیل شود؛ سلاحی که به اعتقاد کیسینجر از بمب اتم هم مخربتر خواهد بود، زیرا هیچ گونه تفکر و شعور انسانی پشت آن وجود ندارد.

روحالله اسلامی، عضو هیات علمی گروه علوم سیاسی دانشگاه فردوسی در گفتوگو با ایسنا با بیان اینکه تکنولوژی از پایههای تغییر جوامع است، به تشریح سیر تاریخی پیشرفت تکنولوژی پرداخت و اظهار کرد: زمانی تکنولوژیها طبیعی، ساده و دم دستی بودند؛ مانند ساختن مسکن از سنگ و چوب یا جنگیدن با نیزه و اسب. حدودا تا سال ۱۶۰۰ پس از میلاد، تکنولوژی تولیدشده توسط بشر در تمام جهان در همین حد بود و دستاوردهایی مانند کشف آتش، اهلی کردن حیوانات، کشاورزی و... نیز در همین بستر حاصل شده است.

وی با بیان اینکه افزایش تهدیدات علیه بشر او را وادار به تولید تکنولوژیهای پیچیدهتر کرد، افزود: از ۱۶۰۰ به بعد تکنولوژی از ساده به مکانیکی تغییر یافت. این تکنولوژیها ساخته دست بشر اند و انسان برای دستیابی به این تکنولوژی، انرژیهایی نظیر بخار، الکتریسیته، سوختهای فسیلی و این اواخر هم انرژی هستهای را به کار گرفت. این منابع انرژی کمک میکنند تکنولوژیهای ما قدرتمندتر و پیچیدهتر شوند و امکان غلبه ما بر بیماری، جنگ و بلایای طبیعی افزایش مییابد، کما اینکه اکنون شاهدیم در سایه پیشرفت تکنولوژی، امکانات مورد استفاده بشر توسعه یافته و میانگین عمر انسانها نیز بیشتر شده است.

عضو هیات علمی گروه علوم سیاسی دانشگاه فردوسی ادامه داد: همچنین ایجاد مجلس، تفکیک قوا، تدوین قانون اساسی، برگزاری انتخابات، ایجاد دموکراسی و... نیز از نمونههای ورود تکنولوژی مکانیکی در علوم انسانی و سیاست است. در حوزه سیاست خارجی نیز میتوان به دایر شدن سفارتخانهها و کنسولگریها، تشکیل سازمان ملل، موازنه قوا و... به عنوان نمودهایی از تکنولوژی مکانیکی اشاره کرد.

اسلامی با بیان اینکه در سال ۱۹۹۰ تکنولوژی از مکانیکی به کوانتومی تغییر یافت، گفت: نمونهای از این سیر تکنولوژی را میتوان در تغییر شیوههای جنگ دید. زمانی انسانها به وسیله سنگ و نیزه با یکدیگر میجنگیدند، با ورود به دوره تکنولوژی مکانیکی ادوات جنگ به تانک و تفنگ تغییر یافت و حالا در دوره تکنولوژی کوانتومی و اطلاعاتی، جنگهای سایبری به اصلیترین شیوه جنگیدن تبدیل شدهاند. حتی حمله ایران به اسرائیل نیز عملا به همین شیوه انجام شده بود و نیروهای مسلح ایران از پشت سیستمهای کامپیوتری موشکها و پهپادها را هدایت میکردند. همین پیشرفت را در شیوه حکومتداری و فعالیت دولتها هم میتوان دید؛ اکنون دولت الکترونیک از نمونههای پیشرفت در عصر تکنولوژی دیجیتال است. در حقیقت دنیا از عصر صنعتی و مدرن، وارد عصر پساصنعتی و پسامدرن شده است.

وی با بیان اینکه ما پس از تکنولوژی اطلاعات، سایبر و دیجیتال، هماکنون وارد انقلاب چهارم صنعتی (هوش مصنوعی) شدهایم، عنوان کرد: اکنون خانواده، دولت، سیاست خارجی، جامعه و... همه تحت تاثیر این نوع تکنولوژی تغییر یافته است. ما در این عرصه چند بازیگر داریم؛ دسته اول شهروندان اند که علاقهمند به استفاده از تکنولوژی مبتنی بر هوش مصنوعی هستند و عمدتا خطری از سمت آن حس نمیکنند. بازیگران دوم شرکتهای توسعهدهنده هوش مصنوعی هستند که در تلاش اند با افزایش سرمایهگذاری در این حوزه، هر روز آن را بیشتر توسعه دهند.

عضو هیات علمی گروه علوم سیاسی دانشگاه فردوسی ادامه داد: دسته سوم بازیگران، حکومتها هستند که رویکردی دووجهی نسبت به هوش مصنوعی دارند؛ یعنی از یک طرف از اینکه میتوانند در این قالب خدمات ۲۴ ساعته و بینالمللی رائه دهند و بر مشروعیت داخلی خود بیافزایند و همچنین با هوش مصنوعی قدرت نظامی و امنیتی خود را افزایش دهند، راضی اند و از یک طرف دیگر نگران هستند که پیشرفت تکنولوژی و خصوصا ورود هوش مصنوعی به زندگی مردم و افزایش دسترسیها و اطلاعات آنان و ورودشان به پلتفرمهای جهانی، قدرت و تسلط حکومتها را کاهش دهد.

مقاومت دولتها در برابر موج تکنولوژی راه به جایی نمیبرد

اسلامی اضافه کرد: لذا دولتها در مواجهه با تکنولوژی به دو دسته تقسیم میشوند؛ نخست آنها که در برابر این موج مقاومت میکنند با وضع محدودیتهایی، جلوی دسترسی شهروندان خود به تکنولوژی پیشرفته را میگیرند. دسته دوم حکومتهایی اند که سعی میکنند با سایر کشورها در زمینه پیشرفت تکنولوژی همکاری داشته باشند، یعنی مثلا یکی تراشه میسازد به بقیه صادر میکند و آن یکی نرمافزاری جدید تولید کرده به سایر کشورها میفروشد. کشورهایی که در دسته دوم قرار میگیرند، موفق میشوند.

وی با بیان اینکه به طور کلی حکومتها توانایی قطع دسترسی مردم به تکنولوژی را ندارند، عنوان کرد: به نظر من هوش مصنوعی باعث میشود جهان به سمت حکمرانی جهانی پیش میرود. یعنی مثلا پول از دست دولتها خارج میشود و ارزهای دیجیتال تبدیل به ابزار مرسوم مبادلات و خرید و فروش مردم میشوند و در همین فضای مجازی بانکهای بینالمللی شکل میگیرند که ممکن است حتی در جایی هم مستقر نباشند، اما کنترل مبادلات و گردش پول جهان را در دست دارند. در حقیقت دنیا تحت حاکمیت فضای مجازی درمیآید.

این پژوهشگر علوم سیاسی بیان کرد: به عقیده من اکنون نظریه هابز، فیلسوف قرن ۱۶ در حال تحقق است و یک لویاتان (حکمرانی جهانی) شکل میگیرد که در آن مفهوم دولت-ملت به شکل کنونی از بین میرود. سردمداران این حکمرانی جهانی، شرکتهای بینالمللی اند، البته شرکت نه به این معنا که عدهای آدم در یک مکان مشخص دور هم جمع شده و کارهایی را انجام دهند، بلکه منظور یک سری شرکتهای شبکهای غیرمتمرکز است.

کاهش جنگ و مرگومیر در سایه پیشرفت تکنولوژی

اسلامی در خصوص اینکه برخی نگران اند در صورت پیشرفت فزاینده هوش مصنوعی، جهان به سمت جنگ ابرقدرتها با استفاده از تسلیحات دیجیتال برود، گفت: با نگاهی به تاریخ میبینیم هر چه تکنولوژی پیشرفت کرده، وضعیت دنیا و سطح زندگی مردم بهتر شده و طول عمرشان افزایش یافته است. پیشرفت تکنولوژی حتی باعث کاهش تعداد جنگهای منجر به تلفات انسانی میشود. زمانی حدود ۷۰، ۸۰ درصد مردم در جنگ زندگی میکردند، اما اکنون از ۸ میلیارد جمعیت جهان، شاید نهایتا چند ده میلیون نفر درگیر جنگ باشند. البته الآن هم جنگهای الکترونیکی در جریان است، اما تعداد تلفات آن با جنگهای قدیم قابل مقایسه نیست.

وی ادامه داد: به علاوه الآن چون هر اتفاقی در هر گوشه از جهان بیفتد، تمام مردم متوجه میشوند و افکار عمومی واکنش نشان میدهند، دولتها کمتر میتوانند دست به اقدامات جنگطلبانه و ضدبشری بزنند، یعنی در این فضای گسترده تبادل اطلاعات و افزایش نقش افکار عمومی، هزینه جنگ به شدت افزایش یافته و دولتها بیشتر تمایل به صلح دارند.

عضو هیات علمی گروه علوم سیاسی دانشگاه فردوسی اضافه کرد: همچنین امروز شاهد کاهش شدید آمار مرگ و میر نسبت به گذشته هستیم. مردم هر لحظه با استفاده از تکنولوژی و وسایل پزشکی پیشرفته که استفاده از آنها راحت است، میتوانند وضعیت سلامت خود را چک کنند. در سالهای دور بیماریهای همهگیر مانند طاعون بیش از ۱۰۰ میلیون نفر را به کام مرگ میکشید، اما در سالهای اخیر همهگیری کرونا در کل دنیا موجب مرگ ۷ میلیون نفر شد. اینها نشان میدهد پیشرفت تکنولوژی باعث شده زندگی مردم در تمام حوزهها بهبود یابد. البته قطعا یک سری سازمانها و قوانین برای کنترل هوش مصنوعی شکل خواهد گرفت تا کسی نتواند از آن در راستای اهداف ضدبشری استفاده کند.

اسلامی با بیان اینکه اکنون شرایط به گونهای است که اگر کشوری عزم توسعه داشته باشد، به سرعت میتواند به آن برسد، افزود: یعنی اگر کشوری تصمیم به پیشرفت بگیرد، زیر ۱۰ سال زیر و رو میشود. امارات، قطر، عربستان و سنگاپور همه نمونهای از کشورهایی اند که در عصر اطلاعات عزم توسعه کردند و در کمتر از ۱۰ سال به طور بسیار چشمگیری تغییر یافتند.

وی ادامه داد: در ایران نیز مردم ما نسبت به بسیاری از کشورهای دیگر، شدیدا علاقهمند به توسعه تکنولوژی و استفاده از وسایل مبتنی بر هوش مصنوعی اند. در سطح حکومت هم اقداماتی نظیر راهاندازی دولت الکترونیک، بانکداری مجازی و... نشان میدهد دولت هم نسبت به گسترش تکنولوژی در کشور بیمیل نیست، اما دو نگرانی دارد؛ اول نگرانی مذهبی و اخلاقی است و دوم نگرانی امنیتی. لذا ایران در پی بومیسازی بسیاری از ابزارهای تکنولوژی است تا آسیبهای این حوزه را به حداقل برساند.

ایلان ماسک در یک کنفرانس اعلام کرد هوش مصنوعی را در اسپیس ایکس و پروژه استارلینک به کار نمی گیرد زیرا کاربردی برای آنها نیافته است.

به گزارش خبرگزاری مهر به نقل از بیزینس اینسایدر، ایلان ماسک مدیر ارشد اجرایی اسپیس ایکس در بیست و هفتمین کنفرانس سالانه انستیتو میلکن، بخش زیادی از سخنرانی خود را به مزایای هوش مصنوعی اختصاص داد. او در کنفرانس در پاسخ به نقش این فناوری در زندگی روزمره انسان ها گفت: هوش مصنوعی حقیقت یاب می تواند تمدن بشر را پرورش دهد.

اما هنگامیکه از او درباره نقش هوش مصنوعی در سرعت بخشیدن به فعالیت هایش در زمینه اکتشافات فضایی سوال شد، اشتیاق کمتری نسبت به این فناوری نشان داد. او در پاسخ به این سوال گفت: نکته عجیب اینجاست که یکی از حوزه هایی که تقریبا هیچ نوعی از هوش مصنوعی در آن استفاده نشده، اکتشافات فضایی است. بنابراین اسپیس ایکس هم از هیچ نوع هوش مصنوعی استفاده نمی کند، استارلینک هم از این فناوری استفاده نمی کند. من مخالف استفاده از آن نیستم. اما کاربردی برای آن نیافته ایم.

او در ادامه افزود: مشغول آزمایش مدل های زبانی هوش مصنوعی است و از آنها سوالاتی درباره فضا می پرسد، اما پاسخ های این سیستم ها نا امید کننده است. با ایجاد هر نسخه یا ارتقایی در هوش مصنوعی من سوالاتی درباره «پارادوکس فرمی»، طراحی موتور موشک ها، فرایندهای الکتروشیمیایی و غیره می پرسم. هوش مصنوعی در پاسخ دادن به این سوالات عملکرد وحشتناکی دارد.

پارادوکس فرمی به عدم مشاهده تمدنهای فرازمینی در کیهان اشاره دارد در حالی که طبق تخمین های دیگر پیشبینی می شود، بتوان تعداد زیادی از این تمدن هوشمند فرازمینی در کهکشان یافت.

هرچند ایلان ماسک درباره استفاده از هوش مصنوعی در اکتشافات فضایی مردد است، اما همچنان از طریق استارت آپxAI خود، سرمایه گذاری کلانی در توسعه هوش مصنوعی انجام داده است در این پروژه از هوش مصنوعی برای سرعت بخشیدن به اکتشافات علمی انسان استفاده می شود.

مدل هوش مصنوعی پزشکی گوگل موسوم به Med-Gemini یک هوش مصنوعی متخصص در پزشکی است که ادعا میشود در برخی کارها حتی از پزشکان انسانی نیز عملکرد بهتری دارد.

به گزارش ایسنا، گروه گوگل ریسرچ(Google Research) و آزمایشگاه تحقیقاتی هوش مصنوعی گوگل به نام دیپمایند(DeepMind)، مدل هوش مصنوعی مد-جمینای(Med-Gemini) که خانوادهای از مدلهای پیشرفته هوش مصنوعی متخصص در پزشکی است را شرح دادهاند. این مدل، یک پیشرفت بزرگ در تشخیص بالینی با پتانسیل عظیم در دنیای واقعی است.

پزشکان روزانه تعداد زیادی از بیماران را با نیازهای ساده تا بسیار پیچیده معاینه و درمان میکنند. آنها برای ارائه مراقبت موثر باید با پرونده پزشکی هر بیمار آشنا باشند و با جدیدترین روشها و درمانها بهروز باشند.

سپس موضوع بسیار مهم رابطه میان پزشک و بیمار وجود دارد که بر پایه همدلی، اعتماد و ارتباط بنا میشود و برای اینکه یک هوش مصنوعی به تقلید از یک پزشک در دنیای واقعی نزدیک شود، باید بتواند همه این کارها را انجام دهد.

هوش مصنوعی و پزشکی این روزها متقارن شدهاند. طی ماههای اخیر اخبار و گزارشات زیادی درباره مدلهای هوش مصنوعی گزارش شده است که به پزشکان کمتر باتجربه در شناسایی پیشسازهای سرطان، تشخیص اوتیسم دوران کودکی از روی تصاویر چشمها و پیشبینی آنی اینکه آیا جراح تمام بافتهای سرطانی را در طول جراحی سرطان سینه برداشته است یا خیر، کمک میکند.

اکنون گفته میشود که Med-Gemini چیز دیگری است و از همه مدلهای پیشین سر است.

مدلهای جمینای گوگل نسل جدیدی از مدلهای هوش مصنوعی چندوجهی هستند، به این معنی که میتوانند اطلاعات را از حالتهای مختلف، از جمله متن، تصویر، ویدئو و صدا پردازش کنند.

این مدلها در زبان و مکالمه، درک اطلاعات متنوعی که بر روی آنها آموزش دیدهاند و آنچه که «استدلال با زمینه طولانی» یا استدلال از مقادیر زیادی داده مانند ساعتها ویدیو یا دهها ساعت صوت نامیده میشود، مهارت دارند.

هوش مصنوعی Med-Gemini تمام مزایای مدلهای پایه جمینای را دارد، اما آنها را به خوبی تنظیم و متعادل کرده است. محققان این ترفندهای متمرکز بر دارو را آزمایش کردند و نتایج آنها را در مقاله گنجاندند. در این مقاله ۵۸ صفحهای مطالب زیادی وجود دارد که در این گزارش به بیان چشمگیرترین آنها میپردازیم.

قابلیتهای خودآموزی و جستجوی وب

رسیدن به یک تشخیص و تدوین یک برنامه درمانی مستلزم آن است که پزشکان دانش پزشکی خود را با مجموعهای از اطلاعات مرتبط دیگر مانند علائم بیمار، تاریخچه پزشکی، جراحی و اجتماعی، نتایج آزمایشگاهی و نتایج سایر آزمایشات تحقیقاتی و واکنش بیمار به درمانهای قبلی گردآوری کنند تا درمانهای موجود بهروزرسانی شوند و درمانهای جدیدی معرفی میشوند. همه این موارد بر استدلال بالینی پزشک تأثیر میگذارد.

به همین دلیل است که گوگل با Med-Gemini دسترسی به جستجوی مبتنی بر وب را برای فعال کردن استدلال بالینی پیشرفتهتر فراهم کرده است. این هوش مصنوعی مانند بسیاری از مدلهای زبان بزرگ(LLM) متمرکز بر پزشکی با MedQA که حاوی سؤالات چند گزینهای نماینده سؤالات آزمون مجوز پزشکی ایالات متحده(USMLE) است، آموزش دیده که برای آزمایش دانش پزشکی و استدلال در سناریوهای مختلف طراحی شده است.

با این حال، گوگل همچنین دو مجموعه داده جدید را برای مدل خود توسعه داده است. اولی MedQA-R (استدلال) است که MedQA را با توضیحات استدلالی تولید شده مصنوعی به نام «زنجیره افکار»(CoTs) گسترش میدهد. دومی MedQA-RS (استدلال و جستجو) است که دستورالعملهایی را برای استفاده از نتایج جستجوی وب به عنوان زمینه اضافی برای بهبود دقت پاسخ به مدل ارائه میدهد. بدین ترتیب اگر یک سوال پزشکی منجر به پاسخ نامطمئن شود، از مدل خواسته میشود تا یک جستجوی وب را برای به دست آوردن اطلاعات بیشتر برای رفع عدم قطعیت انجام دهد.

هوش مصنوعی Med-Gemini بر روی ۱۴ معیار پزشکی آزمایش شد و عملکرد جدیدی را روی ۱۰ معیار اجرا کرد که از مدل GPT-۴ ساخته شرکت اوپنایآی(OpenAI) پیشی گرفت. این مدل در معیار MedQA با استفاده از استراتژی جستجوی هدایتشده به دقت ۹۱.۱ درصدی دست یافت و از مدل زبان بزرگ مبتنی بر پزشکی پیشین گوگل موسوم به Med-PaLM ۲ تا ۴.۵ درصد بهتر عمل کرد.

هوش مصنوعی Med-Gemini در هفت معیار چندوجهی، از جمله چالش تصویری مجله پزشکی نیوانگلند حاوی تصاویر موارد چالش برانگیز بالینی که از یک لیست ۱۰تایی تشخیص داده میشود، به طور متوسط از ۴۴.۵ درصد بهتر از GPT-۴ عمل کرد.

محققان میگویند: در حالی که نتایج امیدوارکننده هستند، تحقیقات بیشتری مورد نیاز است. به عنوان مثال ما محدود کردن نتایج جستجو به منابع پزشکی معتبرتر، با استفاده از بازیابی جستجوی چندوجهی یا تجزیه و تحلیل انجام شده در مورد دقت و ارتباط نتایج جستجو و کیفیت استنادها را در نظر نگرفتهایم. علاوه بر این، باید دید که آیا میتوان به مدلهای زبان بزرگ کوچکتر نیز استفاده از جستجوی وب را آموزش داد؟ ما این اکتشافات را به کارهای آینده واگذار میکنیم.

بازیابی اطلاعات خاص از پروندههای الکترونیکی پزشکی طولانی

پرونده الکترونیک سلامت(EHR) ممکن است بلندبالا باشد، اما پزشکان باید از محتوای آنها آگاه باشند. آنها گاهی پیچیده هستند، چرا که معمولاً حاوی شباهتهای متنی، املای غلط، کلمات اختصاری و مترادفها هستند که میتوانند هوش مصنوعی را به چالش بکشند.

بنابراین محققان برای آزمایش توانایی Med-Gemini در درک و استدلال از اطلاعات پزشکی بلندبالا و طولانی از یک پایگاه داده بزرگ و در دسترس عموم(Medical Information Mart for Intensive Care) که به مثابه پیدا کردن سوزن در انبار کاه است، استفاده کردند. این پایگاه حاوی دادههای بیماران بستری در بخشهای مراقبتهای ویژه است.

هدف این بود که مدل بتواند یک وضعیت، علامت، یا درمان پزشکی کماستفاده و ظریف را در مجموعه بزرگی از یادداشتهای بالینی بازیابی کند.

دویست نمونه انتخاب شد و هر نمونه شامل مجموعهای از پروندههای این پایگاه از ۴۴ بیمار بستری شده در بخش مراقبتهای ویژه با سابقه پزشکی طولانی بود.

هوش مصنوعی Med-Gemini دو مرحله برای یافتن سوزن در انبار کاه پیش رو داشت. اول اینکه مجبور بود همه موارد ذکر شده در مورد مشکل پزشکی مشخص شده را از سوابق گسترده بازیابی میکرد. دوم اینکه باید ارتباط همه موارد را با هم ارزیابی میکرد، آنها را دستهبندی میکرد و نتیجه میگرفت که آیا بیمار سابقه آن مشکل را داشته است و دلیل روشنی برای تصمیم خود ارائه میکرد. در نهایت این هوش مصنوعی عملکرد خوبی داشت.

محققان میگویند: شاید برجستهترین جنبه Med-Gemini، قابلیتهای پردازش سوابق طولانی باشد، زیرا آنها مرزهای عملکردی جدیدی را باز میکنند و امکانات کاربردی جدیدی را که قبلاً غیرممکن بود برای سیستمهای هوش مصنوعی پزشکی فراهم میکنند. این وظیفه یافتن «سوزن در انبار کاه» منعکس کننده یک چالش در دنیای واقعی است که پزشکان با آن مواجه هستند و عملکرد Med-Gemini پتانسیل آن را برای کاهش قابل توجه بار شناختی و افزایش قابلیتهای پزشکان با استخراج و تجزیه و تحلیل کارآمد اطلاعات حاصل از حجم وسیعی از دادههای بیماران نشان میدهد.

گفتگو با Med-Gemini

در یک آزمایش در دنیای واقعی، یک کاربر بیمار از Med-Gemini در مورد یک توده پوستی که خارش دارد، پرسید. این مدل پس از درخواست تصویر، سؤالات مناسب بعدی را پرسید و آن ضایعه نادر را به درستی تشخیص داد و به کاربر توصیه کرد که چه کاری باید انجام دهد.

همچنین از Med-Gemini خواسته شد تا زمانی که پزشک منتظر گزارش رسمی رادیولوژیست بود، عکس رادیوگرافی قفسه سینه یک بیمار را تفسیر کند و یک نسخه انگلیسی ساده از گزارش را تنظیم کند که بتوان آن را در اختیار بیمار قرار داد.

محققان میگویند: قابلیتهای مکالمه چندوجهی Med-Gemini امیدوارکننده است و چنین قابلیتهایی امکان تعامل یکپارچه و طبیعی بین افراد، پزشکان و سیستمهای هوش مصنوعی را فراهم میکنند.

با این حال، محققان دریافتند که کار بیشتری لازم است.

آنها گفتند: این قابلیت دارای پتانسیل قابل توجهی برای کاربردهای مفید در دنیای واقعی، از جمله کمک به پزشکان و بیماران است، البته خطرات قابل توجهی نیز به دنبال دارد. در حالی که پتانسیل تحقیقات آینده در این حوزه را برجسته میکنیم، ما تواناییهای مکالمه بالینی را در این کار، همانطور که قبلاً توسط دیگران در تحقیقات اختصاصی در زمینه هوش مصنوعی تشخیصی محاورهای بررسی شده بود، به طور دقیق مورد بررسی قرار ندادهایم.

چشم اندازهای آینده

محققان اذعان میکنند که کارهای بیشتری برای انجام دادن وجود دارد، اما قابلیتهای اولیه مدل Med-Gemini امیدوارکننده است. مهمتر از همه، آنها قصد دارند اصول هوش مصنوعی مسئول، از جمله حفظ حریم خصوصی و انصاف را در سراسر فرآیند توسعه مدل بگنجانند.

محققان میگویند: ملاحظات حریم خصوصی به طور ویژه باید در سیاستها و مقررات مراقبتهای بهداشتی موجود که از اطلاعات بیمار محافظت میکنند، ریشه داشته باشد. انصاف و عدالت حوزه دیگری است که ممکن است نیاز به توجه داشته باشد، زیرا این خطر وجود دارد که سیستمهای هوش مصنوعی در مراقبتهای بهداشتی ممکن است ناخواسته سوگیریها و نابرابریهای تاریخی را منعکس یا تقویت کنند و به طور بالقوه منجر به عملکرد مدل متفاوت و نتایج مضر برای گروههایی شود.

اما در نهایت، مدل Med-Gemini به عنوان یک ابزار خوب در نظر گرفته میشود.

پژوهشگران میگویند: مدلهای زبان بزرگ چندوجهی در حال آغاز دوره جدیدی از امکانات برای سلامت و پزشکی هستند. قابلیتهای نشان داده شده توسط جمینای و Med-Gemini نشاندهنده جهش قابل توجهی در عمق و وسعت فرصتها برای تسریع اکتشافات زیستپزشکی و کمک به ارائه مراقبتهای بهداشتی و تجارب است. با این حال، بسیار مهم است که پیشرفت در قابلیتهای مدل با توجه دقیق به قابلیت اطمینان و ایمنی این سیستمها همراه باشد. با اولویتبندی هر دو جنبه میتوانیم با مسئولیتپذیری هوش مصنوعی، آیندهای را متصور شویم که در آن قابلیتهای سیستمهای هوش مصنوعی شتابدهندههای معنادار و ایمن در پیشرفت علمی و مراقبت در پزشکی باشند.

اپل ۳ اپلیکیشن را که با کمک هوش مصنوعی مولد تصاویر را به محتوای هرزنگاری تبدیل می کنند از فروشگاه خود حذف کرده است.

به گزارش خبرگزاری مهر به نقل از گیزموچاینا، چند روز پس از آنکه اعلام شد یک ویژگی هوش مصنوعی چالش برانگیز در موبایل های هواوی عکس ها را به محتوای هرزنگاری تبدیل می کند، اخبار مشابهی درباره اپل نیز منتشر شده است.

طبق گزارش ها اپل ۳ اپلیکیشنی که با عنوان «تولید کننده محتوای هنری» تبلیغ شده اند اما در اینستاگرام با عنوان سایت های هرزنگاری ترویج می شوند و مدعی هستند هرعکسی را رایگان به محتوای غیراخلاقی تبدیل می کنند، حذف کرده است.

این اپلیکیشن ها از هوش مصنوعی مولد برای ساخت تصاویر هرزنگاری جعلی افراد استفاده شده اند. ممکن است از این عکس ها برای آزار، اخاذی و از بین بردن حریم خصوصی افراد استفاده کرد.

نکته جالب آنجاست که این اپلیکیشن ها از سال ۲۰۲۲ میلادی در اپ استور فعال بوده اند. همچنین براساس گزارش مذکور این اپ ها در صورتی اجازه حضور در اپ استور را داشتند که تبلیغات سایت های هرزنگاری را حذف کنند.

با این وجود یکی از آنها تا ۲۰۲۴ میلادی و هنگامیکه گوگل آن را از پلی استور حذف کرد، همچنان چنین تبلیغاتی را نشان می داد.

اکنون اپل تصمیم گرفته تا اپلیکیشن مذکور را از اپ استور پاک کند. اقدام مذکور در زمانی حساس برای اپل انجام شده است. رویدادWWDC۲۰۲۴ اپل قرار است به زودی برگزار شود و همچنین پیش بینی می شود این شرکت از ویژگی های مهم هوش مصنوعی در iOS۱۸ و سیری رونمایی کند.

سایت شورای عالی انقلاب فرهنگی اعلام کرد که تدوین سند هوش مصنوعی تمام شده در آینده نزدیک مصوب میکنیم و موضوع کوانتوم یکی از اولویتهای ماست چراکه یک پارادایم علمی جدید است

به گزارش ایسنا، هوش مصنوعی به عنوان یکی از پرشتابترین فناوریهای در حال تکوین، پتانسیل ایجاد تحولهای انقلابی زیادی در جنبههای مختلف زندگی بشر را دارد و یکی از فناوریهای کلیدی است که در حال تکوین بوده و میتواند به پردازشهای صنعتی و حل مسائل مختلف جامعه کمک فراوانی کند.

با توجه به فراگیر شدن این فناوری کارشناسان بر این باورند تغییرات هوش مصنوعی در پنج سال آینده احتمالا سرعت مییابد و بیشترین تاثیر آن بر آموزش خواهد بود. ماهیت کلی هوش مصنوعی و کاربردهای بیشمار آن، باعث ایجاد عدم قطعیتهای متعدد برای پیشبینی آینده آن میشود اما این موضوع به توسعه این فناوری مربوط نمیشود، بلکه به توسعه محیط اقتصادی، سیاسی و اجتماعی آن نیز مربوط میشود.

همزمان با به کارگیری هوش مصنوعی در حوزه مختلف توسط سایر کشورها، ایران هم اقدامات بسیاری طی سال ها در این زمینه انجام داده است که میتوان به تدوین سند هوش مصنوعی اشاره کرد.

برای پیشبرد این هدف مهم، قرار شد شورای عالی فضای مجازی به عنوان مرجع تصمیمگیری بر روی تدوین سند هوش مصنوعی کار کند و بر اساس یکی از احکام مصوب در کمسیون تلفیق برنامه هفتم توسعه، مرکز ملی فضای مجازی و وزارت ارتباطات مکلف شدند که با همکاری سایر دستگاهها ظرف شش ماه از زمان لازمالاجرا شدن قانون، برنامۀ ملّی توسعۀ هوش مصنوعی را تهیه و به تصویب شورای عالی فضای مجازی برسانند.

البته در کنار این اقدام دو سالی است که در وزارت ارتباطات، مرکز هوش مصنوعی تأسیس شده و برای توسعه کاربردها به دستگاهها پیشنهاد میشود. در نهایت پس از اظهار نظرهای گوناگون پیش نویس سند ملی هوش مصنوعی اوایل پاییز سال گذشته از تدوین سیاست در موضوع هوش مصنوعی در شورای عالی انقلاب فرهنگی خبر داد.

در این راستا چندی پیش حجتالاسلام و المسلمین خسروپناه -دبیر شورای عالی انقلاب فرهنگی- جزئیات جدیدی در این زمینه اعلام کرد.

براساس اعلام سایت شورای عالی انقلاب فرهنگی، وی همچنین گفته است که تدوین سند هوش مصنوعی تمام شده در آینده نزدیک مصوب میکنیم و موضوع کوانتوم یکی از اولویتهای ماست چراکه یک پارادایم علمی جدید است؛ دانشگاه آزاد درباره کامپیوتر کوانتومی و دانشگاه شهید بهشتی در زمینه سلول اتمی کوانتومی کار میکنند. در یکسال بیش از ۲۰۰ دانشبنیان را از نزدیک دیدیم و در جریان مشکلاتشان قرار گرفتین و برایشان میز تشکیل دادیم.

سال گذشته پیشنویس سند ملی هوش مصنوعی با حضور نمایندگان سازمانها و دستگاههای مختلف دولتی و بخش خصوصی در دبیرخانه شورایعالی انقلاب فرهنگی ارائه و تحلیل شد.

همچنین به تازگی روح الله دهقانی فیروز آبادی در زمینه رسیدن کشور به ۱۰ کشور برتر دنیا در حوزه هوش مصنوعی، توضیح داده است سال گذشته گفتوگوهایی زیادی با رئیسجمهور و همینطور دستگاههای مختلف از جمله سازمان برنامه و بودجه برای الزام ایجاد یک مرکز ملی توسعه هوش مصنوعی و در کنارش یک شورای ملی راهبری انجام شد و در این راستا برنامهها و مدلهای کشورهای مختلف در حوزه هوش مصنوعی مورد مطالعه قرار گرفت.

البته معاون علمی، فناوری و اقتصاد دانشبنیان رئیسجمهور در صحبت هایش به ایجاد اپراتور هوش مصنوعی هم اشاره کرده و گفته برنامهریزی شده مرکز ملی هوش مصنوعی، اپراتور هوش مصنوعی را ایجاد کند که این اپراتور ٣ خدمت اصلی مزرعه پردازشی بزرگ، مرکز داده بزرگ و کتابخانههای بزرگ زبانی و تصویری را ارائه میدهد.

بر این اساس در واقع همانطور که اپراتورهای تلفن همراه خدمات اینترنتی را ارائه میدهند، اپراتور ملی هوش مصنوعی نیز خدمات پردازشی بزرگ و خدمات کتابخانههای محاسباتی را در اختیار دانشگاهها، شرکتهای دانشبنیان و سازمانها و نهادها قرار میدهد.

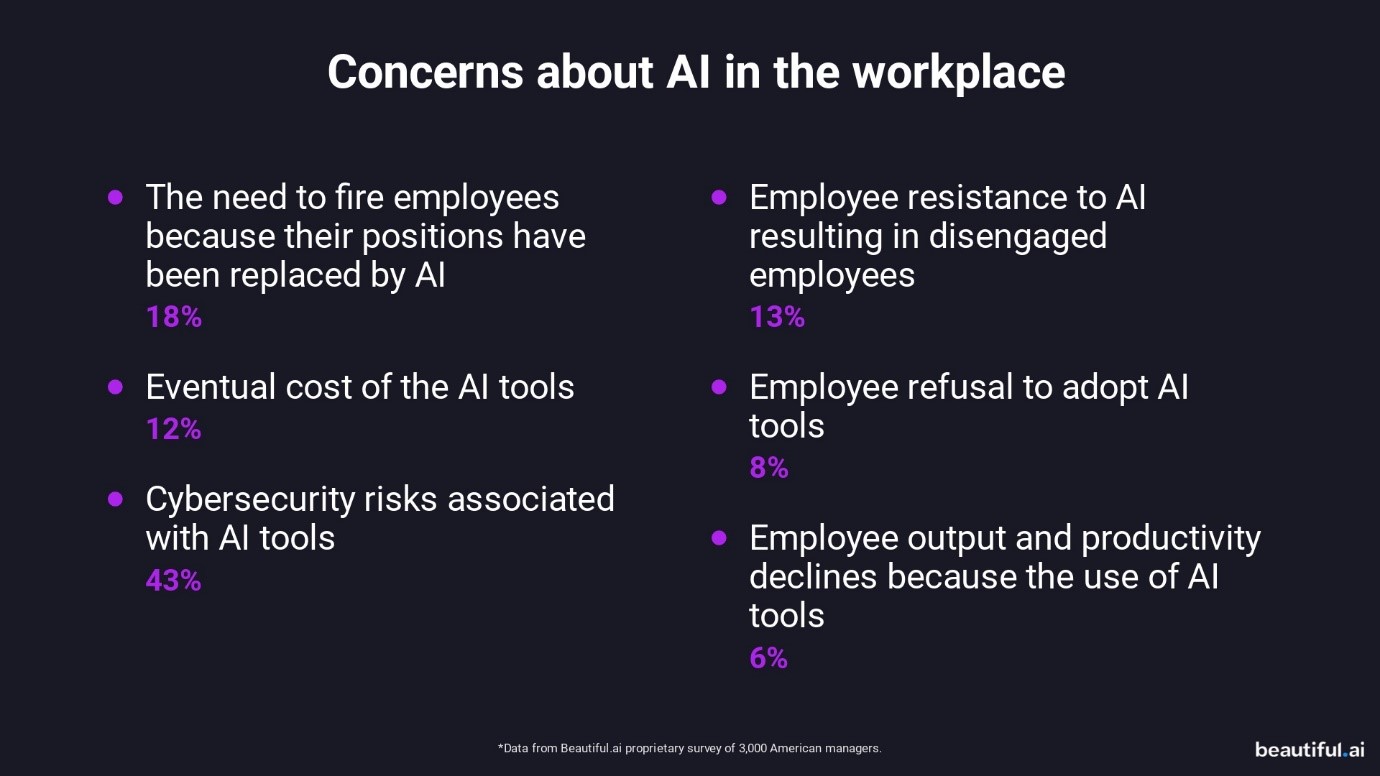

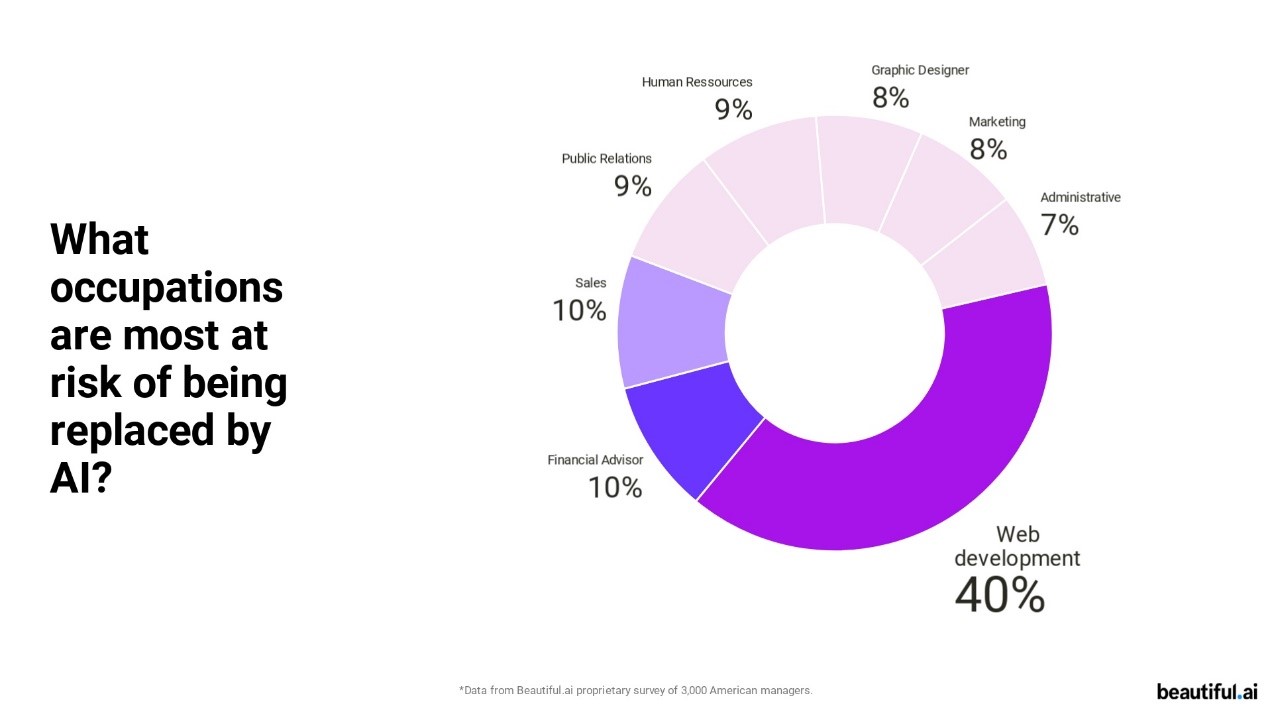

مهسا زحمتکش - هوش مصنوعی چیز جدیدی نیست، اما هوش مصنوعی مولد که توجه متخصصان در سراسر جهان را میطلبد، نحوه کار تیمها را مختل میکند.

به گزارش تبیان از beautiful.ai، برای درک بهتر اینکه چگونه هوش مصنوعی آینده کار را به چالش میکشد، از ۳۰۰۰ مدیر نظرسنجی کردیم تا بدانیم چگونه فناوری جدید را در تجارت خود پیادهسازی میکنند.

هوش مصنوعی برای همه مناسب نیست و هیچ محدودیتی وجود ندارد که صنایع بتوانند از فناوری آن بهره ببرند. شرکتها شروع به پذیرش هوش مصنوعی در جریان کاری خود برای بهبود کارایی و افزایش خروجی کردهاند. در واقع، ۹۵ درصد از مصاحبهشوندگان گفتند که تیمهای آنها قبلاً استفاده از ابزارهای هوش مصنوعی را آغاز و از محتوای تولید شده توسط هوش مصنوعی برای داراییهای مرتبط با کار استفاده کردهاند.

برای استفاده از رونق بزرگ هوش مصنوعی، مدیران اقدامات لازم را برای آمادهشدن برای نصب ابزارهای جدید انجام میدهند. از ۳۰۰۰ مدیر مورد بررسی، ۳۴٪ با آموزش کارکنان خود برای پذیرش ابزارهای هوش مصنوعی موافقت کردهاند. استفاده از هوش مصنوعی در محل کار ممکن است برای هر کسبوکاری متفاوت به نظر برسد، اما ۹۷ درصد از مدیران در حال حاضر این مکالمات را با تیمهای داخلی خود انجام میدهند.

بر کسی پوشیده نیست که تیمها شروع به کشف فرصتهای مرتبط با هوش مصنوعی کردهاند. در واقعیت، ۹۰ درصد از مدیران بر این باورند که ابزارهای مولد هوش مصنوعی در محیط کار محبوبتر خواهند شد، زیرا فناوری و سایر صنایع با اخراجهای گسترده ادامه میدهند.

ابزارهای هوش مصنوعی برای کمک به آسانتر کردن کار انسان با جذب و خودکارسازی برخی از کارهای خستهکنندهتر و تکراریتر هستند. فناوری هوشمند اغلب بهعنوان یک شریک یا دستیار مشترک برای کارمندانی که در نقش خود متخصص هستند عمل میکند. هوش مصنوعی میتواند با تسریع در فرایند طوفان فکری، به بهبود بهرهوری و عملکرد کارکنان کمک کند و به کارمندان نقطه جهشی بدهد تا بتوانند در زمان کمتری محتوای بیشتری تولید کنند. از طرفی مزایای هوش مصنوعی برای مدیران را نمیشود نادیده گرفت، در واقع، ۹۳ درصد میگویند که اگر این ابزارها به عملکرد بهتر آنها در محل کار کمک کند، کارمندان خود را به آزمایش و استفاده از ابزارهای هوش مصنوعی تشویق میکنند.

هوش مصنوعی میتواند با اجازهدادن به کارمندان برای ایجاد اولین پیشنویس پروژه در کسری از زمان، عملکرد را افزایش دهد، سپس میتوانند آن را ویرایش و سفارشیسازی کنند تا یکپارچگی و کیفیت برند حفظ شود. هوش مصنوعی اغلب اطلاعات خود را از گوشههای مختلف اینترنت میکشد و در نتیجه محتوا باید بررسی شود تا از صحت واقعی آن و همسویی با پیام کلی شرکت اطمینان حاصل شود. وقتی از مدیران پرسیده شد که آیا برای انجام بهموقع و کارآمد در بالاترین سطح به کارمندان خود بیش از ابزارهای هوش مصنوعی اعتماد دارند، ۶۹٪ گفتند که هنوز برای کار کارکنان خود ارزش قائل هستند درحالیکه ۲۰٪ بیتفاوت ماندهاند.

البته، مانند هر فناوری جدید، فرایند پذیرش با سؤالات و نگرانیهایی همراه است. طبیعی است که مدیران در مورد پیامدهای هوش مصنوعی در تجارت خود کنجکاو باشند. مواردی مانند هزینه، مقاومت کارکنان، نیاز به اخراج کارکنان به دلیل جایگزینی شغلهای هوش مصنوعی، و کاهش مشارکت و بهرهوری کارکنان، همگی نگرانیهای معتبری هستند. از میان تمام اثرات بالقوه هوش مصنوعی در محیط کار، امنیت سایبری بزرگترین نگرانی بود و تقریباً ۷۵ درصد از مدیران اذعان کردند که نگران امنیت ابزارهای هوش مصنوعی و مسائل بالقوه حریم خصوصی در محل کار هستند.

۶۵ درصد از مدیران معتقدند که جایگزینی کارمندان با ابزارهای هوش مصنوعی تا زمانی که کارشان قابلمقایسه باشد، چیز خوبی برای شرکت آنها خواهد بود، درحالیکه ۱۹ درصد مخالف بودند و ۱۶ درصد نسبت به این بیانیه احساس بیطرفی داشتند.

طبق نظرسنجی، ۴۰ درصد بر این باورند که توسعه وب و برنامهنویسی رایانه بیشترین خطر جایگزینی با هوش مصنوعی را دارند و پس از آن فروشندگان، مشاوران یا تحلیلگران مالی، منابع انسانی، روابطعمومی یا ارتباطات، نقشهای اداری، طراحان گرافیک و بازاریابی قرار دارند. از این مدیران، تقریباً ۷۰ درصد موافقاند که اگر بتوانند تعداد زیادی از کارمندان را با ابزارهای هوش مصنوعی جایگزین کنند، از نظر مالی برای تجارت آنها مفید خواهد بود.

در این نظرسنجی متوجه شدیم که هوش مصنوعی روش کار مردم را برای بهترشدن تغییر میدهد. مدیران برای تولید محتوای بیشتر، در زمان کمتر، بدون به خطر انداختن کیفیت و یکپارچگی برند، به هوش مصنوعی روی میآورند. پذیرش فناوری جدید به این معنی است که بسیاری از تیمها شروع به تخصیص بودجه بیشتری به برنامههای هوش مصنوعی کردهاند که میتواند به کارمندان خود کمک کند تا در نقشهای خود سازندهتر و کارآمدتر باشند.

ازآنجاییکه کسبوکارها به رکود اقتصادی و توقف استخدامها ادامه میدهند، اکثر مدیران بر این باورند که کسبوکارشان میتواند از انتقال منابع خود از کارمندان به هوش مصنوعی از نظر مالی منتفع شود. با انواع ابزارهای جدید هوش مصنوعی، مدیران موافق هستند که ممکن است فرصتی برای استخدام کمتر و درعینحال کاهش حقوق وجود داشته باشد تا از اخراجهای آینده جلوگیری شود.

مانند هر فناوری جدید، عدم قطعیت زیادی وجود دارد. درحالیکه مدیران خطرات امنیت سایبری مرتبط با هوش مصنوعی را زیر سؤال میبرند، کارکنان نگران امنیت شغلی و احتمال جایگزینی با نرمافزارهای هوشمند جدید هستند.

معاون علمی، فناوری و اقتصاد دانشبنیان رییسجمهوری از رتبه هفدهم ایران در زمینه هوش مصنوعی در جهان خبر داد.

به گزارش خبرنگار اجتماعی خبرگزاری تسنیم، نشست خبری سالیانه دکتر روحالله دهقانی معاون علمی، فناوری و اقتصاد دانشبنیان رییسجمهوری در محل معاونت علمی برگزار شد.

دکتر دهقانی در ابتدای این نشست خبری اظهار کرد: سال گذشته یک گفتگوها و تعاملات زیادی انجام شد تا یک مرکز ملی توسعه هوش مصنوعی و شورای راهبری هوش مصنوعی تشکیل شود. ما مدلهای مختلفی را از کشورهای دیگر بررسی کردیم و با دهها ساعت جلسه توسط متخصصان حوزه هوش مصنوعی به این نتیجه رسیدیم که مرکز ملی هوش مصنوعی داشته باشیم که شامل نظارت، تنظیمگری و... است.

وی گفت: در اسفندماه سال گذشته مرکز ملی هوش مصنوعی تأسیس شد و اعضای شورای ملی راهبری هوش مصنوعی معرفی شدند، و جلسات متعددی با سرمایهگذاران دولتی و صندوقهای بزرگ کشور انجام شد و یک صندوق توسعه هوش مصنوعی تشکیل شد و این صندوق با سرمایهگذاری 10 هزار میلیاردی برنامهریزی شد.

دهقانی ادامه داد: کارهای عملیاتی زیادی انجام شده است و یک مرکز ملی در نخستین گام یک اپراتور هوش مصنوعی بالا بیاورد که خدمات مختلفی از جمله دیتاسنتر بزرگ و کتابخانههای زبان تصویری ارایه میکند.

معاون علمی رییس جمهور گفت: ما از نظر دانش فنی و تولید مقالات علمی رتبه 17 را داریم اما در حوزه کاربردها رتبه 70 یا 80 را داریم که بهخاطر نبود زیرساختها است.

وی ادامه داد: این مرکز زیر نظر ریاستجمهوری تشکیل میشود، معاونت علمی وظیفه حمایت از توسعه فناوری را دارد. ستاد توسعه فناوریهای هوش مصنوعی وظیفه حمایت از هوش مصنوعی را دارد.

دهقانی گفت: امسال تا آخر سال به چندصد GPU دسترسی پیدا میکنیم البته بحثهای تحریمی شدیدی در این موضوع وجود دارد و ما نیز از همه دانشگاهها و اساتید دعوت میکنیم در اینجا شرکت کنند.

وی گفت: یکی از مراحل بلوغ بعضی از شرکتهای دانشبنیان که مصداق اقتصاد مردمی هستند عرضه آنها در بازار سرمایه است و ما رشد نهایی شرکتها را زمانی میدانیم که وارد بورس شوند و برای وارد شدن به بورس نیز باید صلاحیت های زیادی می مورد بررسی قرار بگیرد.

دهقانی تأکید کرد: هیچ لزومی ندارد که هر شرکتی که میخواهد دانشبنیان شود بایستی به معاونت علمی ورود کند. برای شرکتهایی که مسایل آنها با ابعاد حکمرانی ارتباط دارد مثلاً دادههای کلان دارند یک مرحله دیگری بررسی میشود که یک کارگروه در معاونت علمی است.

معاون علمی رییس جمهور با اشاره به نحوه ارزیابی شرکتهای دانشبنیان در مدل جدید گفت: در نظام جدید ارزیابی دانشبنیان علاوه بر سطح فناور، میزان گردش مالی شرکتها بررسی میشود به عنوان مثال شرکتهای نوع 1 بودند که در بازنگری به شرکتهای نوپا تبدیل شدند.

وی گفت: اولین فایده مدل جدید ارزیابی شرکتهای دانشبنیان آن است که حجم صادراتی شرکتهای دانشبنیان مشخص میشود. یک نکته دیگر آن است که 10 پارک علم و فناوری در کشور کارگذار شرکتهای نوپا شدند و این شرکتهای نوپا را پارکهای علم و فناوری ارزیابی میکنند و حتی ممکن است غیرحضوری باشد.

وی خاطرنشان کرد: معاونت علمی 4 وظیفه دارد که شامل حمایت از توسعه اندیشهورزی، حمایت از توسعه علم، حمایت از توسعه فناوری ، حمایت از توسعه اقتصاد دانشبنیان و کارآفرین است که این 4 تا ارکان معاونت علمی هستند.

دهقانی فیروزآبادی گفت: سال گذشته 8 اندیشکده دانشبنیان شدند. در فاز علم سال گذشته صندوق حمایت از پژوهشگران به بنیاد علم تبدیل شد و بسیاری از دانشگاهیان تاثیر بنیاد علم را دیدند.

وی ادامه داد: در حوزه فناوری ستادهای توسعه فناوری را ایجاد کردیم و ستادهای رو به آینده مثل هوش مصنوعی و کوانتوم و نانو به ستادهای توسعه فناوری تبدیل شدند. در حوزه اقتصاد نیز معاونت علمی ستادهای توسعه اقتصاد دانشبنیان را تشکیل دادند.

دبیر شورای عالی انقلاب فرهنگی با اشاره به اینکه موضوع کوانتوم یکی از اولویتهای ماست، گفت: سند هوش مصنوعی به زودی در این شورا تصویب میشود.

عبدالحسین خسروپناه در دیدار با دانشگاهیان استان زنجان با اشاره به سالروز تأسیس ستاد انقلاب فرهنگی، گفت: شورای عالی انقلاب فرهنگی اقدامات متعددی در حوزه علم و فناوری در کشور انجام داده است و درصد بالایی از زیرساختهای آموزش عالی کشور توسط شورای عالی انقلاب فرهنگی ایجاد شده است، تأسیس دانشگاه تربیت مدرس، تدوین آییننامه مدیریت دانشگاهها، ایجاد دانشگاه علامه طباطبایی بهعنوان مرکز علوم انسانی در کشور، تنظیم جذب ساز و کار جذب هیئت علمی، تشکیل مرکز هیئت عالی جذب، آییننامه فعالیت تشکلهای اساتید و دانشجویان، هیئت امنای دانشگاهها تنها بخشی از مصوبات شورای عالی انقلاب فرهنگی در حوزه علمی و دانشگاهی است.

استاد خسروپناه تأکید کرد: هم اکنون ۱۰۰ هزار عضو هیئت علمی در کشور داریم در حالی که اوایل انقلاب ۵ تا ۶ هزار عضو هیئت علمی داشتیم، توسعه آموزش عالی و توسعه منابع انسانی باعث شده که در شاخصهای علمی جز سرآمدان باشیم و این دستاوردها مرهون شورای عالی انقلاب فرهنگی است.

دبیر شورای عالی انقلاب فرهنگی ادامه داد: سند هوافضا در تحول و رشد اقدامات موشکی و ماهوارهای کشور بسیار مؤثر بوده است، سند فناوری نانو، سند زیست فناوری، سند علوم شناختی، سند توسعه فناوری نرم، سند گیاهان دارویی، سند سلول های بنیادین، صندوق توسعه علم و فناوری، جایزه علمی مصطفی(ع) جزء مصوبات شورای عالی انقلاب فرهنگی است، این اسناد شورا را نخبگان کشور نوشتند و شورا حکمرانی اسناد را برعهده داشته است.

وی عنوان کرد: در حال حاضر سند صنایع دستی در حال تدوین است و ۱۴۰۰ ذینفع در نوشتن آن نقش دارند، سند موسیقی که بعد ۴۰ سال با مشارکت اساتید و شخصیتهای موسیقی تدوین و ابلاغ شد. در حال به روزرسانی نقشه جامع علمی هستیم و فرهنگستان های علوم و علوم پزشکی در حال انجام آن هستند.

خسروپناه افزود: یکی از مهمترین موضوعات در حوزه علم و فناوری بحث تقویت دانشبنیانهاست، آییننامه ارتقاء ناظر به توسعه علمی، دیپلماسی علمی تا تولید علم بینالمللی را در دستور کار داریم. باید ارتباطات علمی بین المللی داشته باشیم و آنها را توسعه دهیم.

دبیر شورای عالی انقلاب فرهنگی اضافه کرد: تدوین سند هوش مصنوعی تمام شده در آینده نزدیک مصوب میکنیم، موضوع کوانتوم یکی از اولویتهای ماست چراکه یک پارادایم علمی جدید است، دانشگاه آزاد درباره کامپیوتر کوانتومی و دانشگاه شهید بهشتی در زمینه سلول اتمی کوانتومی کار میکنند. در یکسال بیش از ۲۰۰ دانشبنیان را از نزدیک دیدیم و در جریان مشکلاتشان قرار گرفتین و برایشان میز تشکیل دادیم.

وی با بیان اینکه شورای عالی انقلاب فرهنگی یک قرارگاه علم و فناوری است، گفت: در حوزه فرهنگ نیز کارهای زیادی انجام شده البته تا قبل از این ۷۰ درصد مصوبات علم و فناوری بوده و ۲۰ درصد فرهنگی و ۱۰ درصد مشترک بوده است، الان ۵۰ درصد علمی و ۵۰ درصد فرهنگی است. مصوبات شورا هم مصوباتی روی کاغذ نیست وزرا درباره مصوبات گزارش میدهند.

خسروپناه با بیان اینکه اتاق وضعیت علم و فرهنگ تشکیل دادهایم، ادامه داد: دانشگاه فرهنگیان با مشکلات زیاد روبهرو بود اما هم اکنون رونق پیدا کرده و وزارت آموزش و پرورش برای سند تحول بنیادین آموزش و پرورش که تعطیل بود، نقشه راه نوشته که به زودی مصوب میشود. قانون جهش دانش بنیان یکی از اولویتهاست، معتقدیم حلقه میانی دانشگاه و صنعت، دانشبنیانهاست. همچنین باید در هم تنیدگی علوم مورد توجه باشد، امروز دیگر رشته پزشکی فقط علوم پایه و بیمارستان نیست بلکه پیوند وثیقی با رشتههای دیگر پیدا کرده است.

دبیر شورای عالی انقلاب فرهنگی گفت: باید نسبت به مسئله تربیت دانشجویان دغدغه داشته باشیم، بسیاری از کارهای فرهنگی اراده میخواهد نه بودجه، مخالف بودجه نیستم اما الزاما با بودجه مشکل حل نمیشود. موضوع دیگر آمایش رشتهها یعنی حذف و جذب رشته مطرح است، باید رشتهها تغییر کنند برخی هم باید حذف شوند و برخی اضافه شود، ریاضیاتی که با کوانتوم ارتباط دارد کاربرد دارد.

وی با اشاره به موضوع عفاف و حجاب بیان کرد: در حجاب و عفاف به سیاست جدیدی نیاز نداریم، صداوسیما کارهای خوب انجام داده است، دستگاهها در حال تدوین برنامه هستند اما نباید این نکته را از نظر دور داشت که جریان پست مدرن و نهلیسیتی از قرن ۱۹ شروع شده است. زیست جهان پست مدرن، مانند سیل و سونامی دنیا را گرفته است، کتابهای زیادی نوشته است، اخیرا کتابی از نویسنده آلمانی به نام «چگونه غرب خدا را واقعا از دست داد؟» ترجمه شده است که نویسنده میگوید که غرب اول خانواده را از دست داد و بعدا خدا را از دست داد، کتابهایی که غربیها درباره خانواده نوشتهاند از ما بیشتر است، آنها هم دغدغه دارند، نباید فکر کنیم نیروی انتظامی میتواند موضوع حجاب را حل کند البته آنها مسئولیتی دارند اما مسئله اصلی در جایگاه تبیینی و شناختی است. حجاب در ایران قدمت دیرینه دارد.

وی گفت: در مسیر جلوگیری از مهاجرت نخبگان باید موانع قانونی را بر داریم، این قانون در حال اصلاح است چراکه علم نباید امنیتی شود.

دبیر شورای عالی انقلاب فرهنگی گفت: برای اینکه در شورا حکمرانی علم و فناوری درست باشد هیئت اندیشهورز استانها را به راه انداختیم در تدوین آیین نامه ارتقای اعضای هیئت علمی، اصول حاکم بر آن و به روزرسانی نقشه جامع علمی کشور از نظر اساتید استفاده می کنیم، بنابراین اساتید در هیئت های اندیشه ورز نظرات خود درباره مسائل ارائه دهند. وزارت علوم بهداشت فرهنگستان علوم به جد درگیر موضوعات شورا شده اند، دانشگاهها ارتباط خوبی با شورا دارد و این دقیقا حکمرانی است.

شرکت ملی انفورماتیک ایران اولین فصلنامه «هوش مصنوعی» را با عنوان هوش نما با هدف مطالعه جامع اکوسیستم هوش مصنوعی ایران منتشر کرد.

به گزارش روابط عمومی شرکت ملی انفورماتیک، فصل نامه هوشنما به همت مرکز هوش مصنوعی شرکت ملی انفوماتیک با هدف بررسی جامع اکوسیستم هوش مصنوعی کشور از ابعاد مختلف تهیه شده است.

برای تهیه این گزارش اطلاعات مورد نیاز از سازمانها، وزارتخانهها، بخشهای خصوصی، تشکّلها و فعّالان حوزه، گردآوری و دستهبندی شده است.

قطعاً در این گزارش برخی از شرکتها و فعالین حوزه هوش مصنوعی کشور از قلم افتاده که درخواست میشود موارد از طریق پست الکترونیکیai.info@nicholding.net اطلاع داده تا در شماره بعدی این گزارش درج گردند.

هوشنما اقدامی جریان ساز در حوزه هوش مصنوعی کشور به شمار میرود و امید است شاهد اثربخشی آن در سطح کشور و نظام مقدس جمهوری اسلامی ایران باشیم.

این شماره فصلنامه هوش نما به ارائه اجمالی رویدادها و فعالان حوزه هوش مصنوعی میپردازد و شامل بخش های اصلی زیر است:

رویدادهای هوش مصنوعی

هوش مصنوعی و حاکمیت

شرکتهای فعال در حوزه هوش مصنوعی

هوش مصنوعی و دانشگاهیان

ایرنا- کشورهای خاورمیانه گامهای هوشمندانهای در راستای افزایش مولفههای قدرت نرم و موازنه نرم با محوریت هوش مصنوعی برداشتهاند و حتی برخی در این زمینه دارای نقشه استراتژیک شفاف و برنامهریزی شدهای هستند. از دید فعالان و کارشناسان این حوزه، کشوری که بتواند در راستای قدرت نرم و عرصههایی چون هوش مصنوعی سرآمد باشد رهبری منطقه را در دست خواهد گرفت.

هوش مصنوعی که انقلاب صنعتی چهارم در نظر گرفته میشود، به عنوان تغییردهنده قاعده بازی قدرت به شمار میآید. در عصر کنونی کشورها با تهدیدات نوین و متکثری مواجه هستند که ضمن شناخت ابعاد گوناگون این تهدیدات، باید نسبت به آنها آگاهی یابند تا بتوانند شیوههای مقابله و دفع آنها را بشناسند.

اثرگذاری برخی از علوم و فناوریهای جدید بر حوزههای گوناگون از سیاست تا علوم انسانی همزمان با پیشرفت سریع آنها در حال افزایش است. یکی از این حوزههای جدید علمی هوش مصنوعی است. هوش مصنوعی به طور خلاصه به تولید ماشینهایی میانجامد که خود قادر به یادگیری، درک شرایط پیچیده، تفکر، استدلال و ارائه پاسخ و کسب دانش بدون نیاز به کمک و دخالت انسانها هستند. بدیهی است کشورهایی که چنین ماشینها و سیستمهایی را در اختیار داشته باشند، میتوانند توازن قوا را در نظام بینالملل به نفع خود تغییر دهند و اتحادهای جدیدی را برای مرعوب ساختن دشمنان به وجود آورند.

با توجه به این مقدمه لزوم شناخت هوش مصنوعی و وضعیت کشورهایی که از آن استفاده میکنند بیش از پیش احساس میشود. یکی از این پژوهشها مقالهای است با عنوان «هوش مصنوعی و آینده رقابتهای منطقهای خاورمیانه» [۱] و به قلم «حدیث همتی وینه»، «فرزاد رستمی» و «قدرت احمدیان». نویسندگان در این مقاله در پی آن هستند تا به این پرسش پاسخ دهند که هوش مصنوعی چه تاثیری بر آینده رقابتهای منطقهای خاورمیانه دارد؟ به بیان دیگر نظم جدید منطقه در پرتو هوش مصنوعی و تکنولوژیهای نوین به چه سمتی خواهد رفت و معیارهای قدرت در آینده چه خواهد بود؟

تاریخچه و زمینههای هوش مصنوعی

هوش مصنوعی در دهههای ۱۹۶۰-۱۹۵۰ زمانی که «آلن تورینگ» معروف به «پدر رایانهها» ایده «آزمایش تورینگ» را مطرح کرد سرچشمه گرفت؛ به این معنا که اگر ماشینی بتواند بدون شناسایی با انسان صحبت کند، آنگاه آن دستگاه هوشمند خواهد بود. در دهه ۱۹۷۰ توسعه هوش مصنوعی دست کم گرفته میشد و توسعه فناوری با تنگناهایی مانند عملکرد ناکافی رایانه، کمبود جدی دادهها و حل ضعیف پیچیدگی مشکلات مواجه بود. پس از ورود به دهه ۱۹۹۰ با توسعه فناوری شبکههای عصبی، هوش مصنوعی وارد دورهای از توسعه پایدار شد.

چندین طبقهبندی برای هوش مصنوعی وجود دارد اما میتوان دو دسته متمایز را در نظر گرفت.

طبقهبندی اول: طبقهبندی اول بر اساس هوش مصنوعی و ماشینهای مجهز به هوش مصنوعی، شباهت آنها به ذهن انسان و توانایی آنها برای «فکر کردن» و حتی «احساس» به عنوان انسان است. چهار طبقهبندی فرعی برای این سیستمهای مبتنی بر هوش مصنوعی وجود دارد: الف) ماشینهای واکنشی، ب) ماشینهای با حافظه محدود، ج) نظریه ذهن، د) هوش مصنوعی خودآگاه.

طبقهبندی دوم: دستهبندی دوم رویکرد مبتنی بر فناوری است که در آن سه زیر مجموعه فرعی وجود دارد: الف) هوش مصنوعی ANI، ب) هوش مصنوعی AGI، ج) هوش مصنوعی فوقالعاده.

وضعیت کشورهای خاورمیانه در حوزه هوش مصنوعی

عربستان: در حال حاضر عربستان به دنبال ادغام رباتیک و هوش مصنوعی به طور یکپارچه در هر جنبهای از زندگی شهروندان برای ایجاد درآمد از بخشهای کلیدی اقتصادی برای آینده است. با این حال، این گذار از یک اقتصاد مبتنی بر هیدروکربن به هوش مصنوعی بیشتر از منظر اقتصادی است. این تلاشی برای تضمین بقای خاندان آل سعود و مقابله با چالشهای فزاینده ساخت کشوری حول محور نفت است.

این کشور استراتژی هوش مصنوعی ملی ندارد اما به عنوان اولین کشوری که به رباتی به نام سوفیا شهروندی اعطا کرد در تاریخ ثبت شد. عربستان سعودی در تلاش است تا به یک رهبر جهانی در فناوری تبدیل شود و یک قطب مرکزی برای شبکههای تخصصی هوش مصنوعی جهانی باشد و هویت خود را به عنوان پیشروی فناوری در تولید، تحقیقات و طراحی فناوری پیشرفته بازسازی کند.

قطر: در قطر تنوع اقتصادی به عنوان گامی اجتنابناپذیر برای تبدیل شدن به یک جامعه دانشمحور شناخته شده است. قطر جمعیت کوچک، تحصیلکرده و با هوش فناوری اطلاعات دارد. استفاده از اتوماسیون برگرفته از هوش مصنوعی برای تقویت تواناییهای انسانی که هم ظرفیت و هم توانایی نیروی کار قطر را افزایش میدهد، در یک افق زمانی نسبتا کوتاه امکانپذیر است.

با نزدیکتر شدن افق محدود اقتصاد مبتنی بر منابع طبیعی، کشورهایی مانند قطر چارهای جز پذیرش هوش مصنوعی برای انتقال به یک اقتصاد مبتنی بر دانش و در عین محافظت و شاید ارتقای استاندارد زندگی فعلی خود ندارند.

امارات متحده عربی: امارات متحده عربی با تکیه بر درآمدهای سرشار حاصل از فروش نفت میکوشد به بلندپروازیهای خود از جمله طرح «۲۰۷۱ UAE Centennial » برای تبدیل شدن به «بهترین کشور دنیا» در صدمین سالگرد استقلال و طرح «۲۱۱۷ Mars » برای ساخت شهری ۶۰۰۰۰۰ نفری در کره مریخ تا صد سال دیگر جامه عمل بپوشاند و در زمینه هوش مصنوعی راهبردهایی مانند راهبرد شهر هوشمند دبی، راهبرد به کارگیری فناوری چاپ سه بعدی و راهبرد حمل و نقل خودکار دبی را اتخاذ کند. البته دولتمردان این کشور به خوبی میدانند که بدون بهرهگیری از علوم پیشرفته و فناوریهای روز دنیا، جذب دانشمندان و پژوهشگران برجسته، سرمایهگذاری در زمینه نوآوریهای نوین به ویژه هوش مصنوعی به عنوان صنعتی دورانساز، همچنین داشتن جامعهای آگاه از فرصتها و چالشهای این صنعت، امکان تحقق این رویاها وجود ندارد.