| تحلیل وضعیت فناوری اطلاعات در ایران |

| تحلیل وضعیت فناوری اطلاعات در ایران |

مالزی یک دفتر ملی هوش مصنوعی با هدف شکل دهی سیاست ها و رسیدگی به مسائل رگولاتوری راه اندازی کرد زیرا تصمیم دارد خود را به عنوان یک هاب منطقه ای برای توسعه هوش مصنوعی تثبیت کند.

به گزارش خبرگزاری مهر به نقل از رویترز، این کشور جنوب شرقی آسیا سال گذشته میلادی از شرکت های فناوری جهان میلیاردها دلار سرمایه جمع آوری کرد تا زیرساخت حیاتی مورد نیاز برای تقاضای روز افزون ابر رایانشی و سرویس های هوش مصنوعی را تامین کند.

انوار ابراهیم نخست وزیر این کشور در این باره گفت: این یک لحظه تاریخی در مسیر تحول دیجیتال ماست.

پیش بینی می شود این دفتر به عنوان یک آژانس متمرکز برای هوش مصنوعی، تامین برنامه ریزی استراتژیک، تحقیق و توسعه و همچنین نظارت رگولاتوری فعالیت کند. همچنین این آژانس تصمیم دارد در نخستین سال فعالیت خود ۷ اقدام را ارائه کند از جمله توسعه دستورالعمل اخلاقی، یک چارچوب رگولاتوری هوش مصنوعی و یک برنامه هوش مصنوعی ۵ ساله تا ۲۰۳۰ میلادی.

علاوه بر آن دولت مالزی از همکاری استراتژیک با ۶ شرکت از جمله آمازون، مایکروسافت و گوگل خبر داد که همه آنها در سال گذشته اعلام کرده بودند پروژه های مرکز داده ، ابررایانشی و هوش مصنوعی در مالزی اجرا می کنند.

رئیس سازمان نظام صنفی رایانهای کشور گفت: کمیسیون هوش مصنوعی سازمان با همکاری ۱۰۰ شرکت فعال، ظرفیتهای بالایی برای این تحول دیجیتال دارد.

به گزارش خبرنگار مهر ، حکیم جوادی، رئیس سازمان نظام صنفی رایانهای کشور صبح امروز در برنامه «تحول دیجیتال-افق آینده» با تاکید بر ضرورت تحول دیجیتال در حوزه اداری دولت بر نقش کلیدی بخش خصوصی در این فرآیند تاکید کرد.

جوادی به اهمیت تحول دیجیتال و نقش آن در بهبود بهرهوری و رضایت مردم اشاره کرد و گفت: تحول دیجیتال دیگر محدود به الکترونیکی کردن فرایندها نیست. امروز هدف ایجاد دگردیسی در ساختار سازمانی با استفاده از فناوری اطلاعات است، به گونهای که بهرهوری افزایش یابد و خدمات به صورت ۲۴ ساعته و غیرحضوری ارائه شود.

وی افزود: در حال حاضر، سرمایهگذاری جهانی بخش خصوصی در این حوزه به بیش از ۲.۴ تا ۲.۶ تریلیون دلار رسیده و زیرساختهای ایجاد شده در این زمینه به ارزش ۴.۶ تریلیون دلار است که بازگشت سرمایه را در بهرهوری و کاهش هزینهها به همراه داشته است.

وی با اشاره به چالشهای موجود، گفت: سازمانهای سنتی تمایل به تغییر ندارند و بیشترین مقاومت نیز از سوی افرادی صورت میگیرد که خود در جشنوارهها رتبههای برتر را کسب کردهاند. علاوه بر این، جذب، نگهداری و توسعه نیروهای متخصص (تلنتها) در بخش دولتی با مشکلات جدی مواجه است.

رئیس سازمان نظام صنفی رایانهای کشور تاکید کرد که بخش خصوصی میتواند با سرمایهگذاری و ارائه مشاوره در این زمینه نقش موثری ایفا کند.

وی همچنین خواستار برگزاری سمینارهای بیشتر برای تعامل بخش خصوصی و دولت شد و اعلام کرد: در سازمان نظام صنفی رایانهای کشور، ما با بیش از ۲۸ هزار عضو و کمیسیونهای تخصصی متعدد آمادگی داریم تا در برنامههای تحول دیجیتال دولت همکاری کنیم. برای نمونه، کمیسیون هوش مصنوعی ما با همکاری ۱۰۰ شرکت فعال، ظرفیتهای بالایی برای این تحول دارد.

جوادی ضمن اشاره به اهمیت امنیت سایبری در تحول دیجیتال از نظارت دقیق و اقدامات دولت در این حوزه تشکر و اظهار کرد که با افزایش استفاده از فناوری اطلاعات، امنیت به یک دغدغه کلیدی تبدیل شده است.

وی تاکید کرد که بخش خصوصی آماده است تا با مشارکت در برنامههای تحول دیجیتال و بازنگری فرآیندهای سازمانی، نقش موثری در ارائه خدمات نوین دولتی به مردم و بنگاههای اقتصادی ایفا کند.

امیدواریم با همکاری دولت و استفاده از ظرفیتهای عظیم بخش خصوصی، شاهد تحولی اساسی در ارائه خدمات دولتی باشیم.

معاون علمی، فناوری و اقتصاد دانش بنیان رئیس جمهور گفت: دستیار هوش مصنوعی برای رییس جمهور، معاونان و وزرا تعریف می شود.

به گزارش خبرنگار مهر، حسین افشین در نشست خبری که امروز سه شنبه ۱۳ آذرماه در معاونت علمی برگزار شد، گفت: اتفاق بزرگی در حال رخ دادن است و آن این است که اولین دیتا سنتر جی پی یو را تا اوایل ۱۴۰۴ افتتاح میکنیم.

وی افزود: یکی از دانشگاههای کشور را محور قرار دادیم که سیستم عامل ملی هوش مصنوعی را تدوین کند. نسخه آزمایشی این سیستم عامل ۶ ماه دیگر آماده میشود و تمام الگوریتمهای هوش مصنوعی روی این سیستم عامل بومی صورت میگیرد.

دستیار هوش مصنوعی برای آقای رئیس جمهور آماده میکنیم

معاون علمی رئیس جمهور ادامه داد: تیم ۷۰ نفره از اساتید به نام کشور روی این پروژه کار میکنند؛ صبوری کنید عیبها رفع شود تا این پروژه ماندگار شود.

افشین خاطرنشان کرد: قرار است دستیار هوش مصنوعی برای آقای رئیس جمهور آماده کنیم تا دادهها را به روز بگیرند ونظرات کارشناسی به ایشان ارائه شود. این پروژه در حال تعریف است.

وی افزود: همچنین برای معاونان رئیس جمهور و وزرا دستیار هوش مصنوعی در حال تعریف و آماده سازی است. هفته آینده این پروژهها را با دانشگاهها نهایی میکنیم.

پروژه مهندسی معکوس تسلا متوقف شد

معاون علمی، فناوری واقتصاد دانش بنیان رئیس جمهور در پاسخ به سوالی درباره پروژه مهندسی معکوس تسلا در ایران گفت: پروژه مهندسی معکوس خودروی تسلا در ایران در حد یک طرح باقی مانده و پیشرفت خاصی نداشته است. این پروژه متوقف شده است ولی در بخش موتور الکترونیکی کارهایی در حال انجام است.

وی ضمن بیان این مطلب که طراحی پلتفرم خودروی برقی نیازمند سرمایهگذاری سنگینی در حدود یک میلیارد دلار است، گفت: در حال حاضر در خودروهای داخلی ما طراحی پلتفرم نداریم. مردم برای خرید خودرو صفهای طولانی دارند، بنابراین خودروسازان دلیلی برای ایجاد پلتفرمهای جدید نمیبینند.

افشین اضافه کرد: خودروسازهای داخلی معمولاً از پلتفرمهای قدیمی استفاده میکنند و آن را تغییر میدهند. به طور مثال خودروی تارا بر پایه پلتفرم یک ماشین دیگر ساخته شده است.

معاون علمی رئیس جمهور تصریح کرد: دو شرکت اصلی خودروساز معمولاً از پلتفرمهای یکسان استفاده میکنند و با تغییر ظاهر خودروها مدلهای جدید خودرو را به بازار عرضه میکنند.

رونمایی از هواپیمای ۸ نفره

افشین از ساخت هواپیمای ۸ نفره توسط بخش خصوصی (یک شرکت دانش بنیان ) خبر داد و گفت: در نمایشگاه هوایی که هفته آینده در کیش برگزار میشود، هواپیمای ۸ نفره رونمایی خواهد شد.

معاون علمی رییس جمهور افزود: مذاکراتی برای تحویل این هواپیما به شرکت هواپیمایی ماهان در حال انجام است.

قانون رمز ارزها در مجلس مورد بررسی قرار می گیرد

افشین درباره برنامه های معاونت علمی برای ساماندهی رمز ارزها توضیح داد و گفت: بانک مرکزی تاکید دارد که حاکمیت پول باید حفظ شود که با این دیدگاه موافقیم ولی جلوی توسعه فناوری را نمی توان گرفت و حوزه های نوآورانه ای مانند فین تک در لبه دانش قرار دارد که لازم است در کشور توسعه یابد.

وی با اشاره به تدوین پیش نویس رمزارزها گفت: در زمینه پیش نویس قانون رمز ارزها به توافق با بانک مرکزی رسیدیم و این پیش نویس به این بانک ارسال شده است.

معاون علمی رییس جمهور از طرح پیش نویس قانون رمز ارزها طی روزهای آینده در مجلس خبر داد و گفت: ما تلاش داریم تا مشکلات شرکت های فعال در حوزه رمز رفع شود.

خرید و فروش خودرو و ملک آنلاین می شود

افشین از ایجاد سامانه یکپارچه معاملات آنلاین خودرو و خانه در همکاری با اداره ثبت، نیروی انتظامی و قوه قضائیه خبر داد و افزود: این سامانه از سوی یکی از شرکت های دانش بنیان توسعه یافته و در صورتی که فرد بخواهد خودرو خود را به فروش برساند، اطلاعات را در این سامانه بارگذاری می کند. در این سامانه اطلاعاتی درباره استعلام افراد و کالای مورد معامله، میزان خلافی، میزان استفاده از بیمه خسارت، قطعات تعویضی در خودرو و غیره نمایش داده می شود.

آخرین وضعیت کارخانه نوآوری آزادی

معاون علمی، فناوری و اقتصاد دانش بنیان رییس جمهور به تشریح آخرین آخرین وضعیت کارخانه نوآوری آزادی مستقر در پارک فناوری پردیس پرداخت و گفت: مالکیت این کارخانه دولتی نیست. مالک این ملک می خواهد یا این ملک خریداری شود و یا ساکنان از این ساختمان خارج شوند.

وی ادامه داد: برای حل این مشکل تلاش کردیم تا بتوانیم با ساختمان های دولتی تهاتر کنیم چرا که جا به جایی تجهیزات مستقر در این ساختمان سخت و دشوار است.

آیین نامه ای برای رفع چالش های توزیع آنلاین دارو تدوین شده است

افشین همچنین درباره چالش های شرکت های فعال در زمینه توزیع آنلاین دارو گفت: وزارت بهداشت نگرانی هایی از توزیع آنلاین دارو دارد و دیوان عالی اداری رای به مجاز بودن توزیع آنلاین دارو داده است. در این زمینه آیین نامه ای تدوین شده است و تا دو هفته آینده آماده و ارائه می شود. با این آیین نامه مشکلات شرکت های فعال در این حوزه برطرف شود.

ستادهای معاونت علمی ادغام می شوند

وی در پاسخ به سوالی درباره وضعیت ساختاری ستادهای معاونت علمی توضیح داد و گفت: ستادهای معاونت تضعیف شده اند و تعدادشان به ۲۳ ستاد افزایش یافته که عدد بزرگی است و مدیریت آن سخت است. برنامه معاونت در دوره جدید تجمیع این ستادها بوده و قرار است به ۷-۸ ستاد تبدیل شوند. البته یک سری ستادها مصوبه شورای عالی را دارند که با آن ها نیز هماهنگ کردیم که این ادغام صورت گیرد. به طور مثال در حال حاضر ستاد آب، انرژی و محیط زیست در هم ادغام شده اند و یک سرپرست برای آن انتخاب شده است. دلیل کوچک سازی ستادها، برقراری یک نظم ساختاری است.

معاون علمی، فناوری و اقتصاد دانش بنیان رییس جمهور ضمن تاکید بر اینکه دنبال کادرسازی و اضافه کردن نیرو در معاونت نیستیم، خاطرنشان کرد: البته از افراد توانمند در بخش خصوصی اعم از دانشگاه ها و اندیشکده ها کمک خواهیم گرفت.

تنها ۸ هزار شرکت دانش بنیان در لبه دانش فعالیت دارند

افشین با اشاره به اینکه تجمیع و کیفیت شرکتهای دانشبنیان از تعداد آنها مهمتر است، گفت: امروز به طور دقیق حدود ۱۳ هزار شرکت دانشبنیان داریم، اما تنها هشت هزار از این شرکتها در لبه دانش در حال فعالیت هستند و ممکن است در ۱۰ سال آینده برخی از آنها حذف شوند.

وی با اشاره به اهمیت پایش مداوم شرکتهای دانشبنیان، خاطرنشان کرد: تلاش میکنیم که این پایش بهطور دائمی انجام شود تا بتوانیم گامهای مؤثری برداریم. طبق قانون، هر دو سال یک بار شرکتها باید مورد ارزیابی قرار گیرند و سپس بعد سه سال تمدید مجدد انجام شود تا شرکتها مرز دانش را ادامه دهند و در وضعیت ایست قرار نگیرند.

افشین افزود: شرکتهای دانشبنیان باید پویا و در حال پیشرفت باشند؛ ریزش و رویش شرکتها امری طبیعی است و نباید نگران آن بود. نگرانی اصلی باید این باشد که آیا محصولی که پنج سال پیش دانشبنیان شناخته شده، امروز نیز به همین عنوان میتواند ادامه یابد یا خیر.

راهکارهای نوین معاونت علمی برای توسعه شرکتهای دانشبنیان

معاون علمی و فناوری رئیسجمهور به برنامه هفتم توسعه کشور اشاره و اعلام کرد: براساس این برنامه، کشور موظف است طی پنج سال آینده تعداد شرکتهای دانشبنیان را به ۳۰ هزار مورد برساند. برای تحقق این هدف، باید بر روی چشمهای که میتواند ایجاد شرکتهای دانشبنیان را تقویت کند، تمرکز داشته باشیم. این چشمه در نیروهای جوان ما و در دانشگاهها وجود دارد و ما برنامهای مفصل در این راستا داریم.

افشین بر اهمیت وجود نیروی انسانی جوان و متخصص به عنوان پارامتر اصلی در شکلگیری و رشد شرکتهای دانشبنیان تأکید کرد و گفت: ما در پی این هستیم که با شناسایی و حمایت از استعدادهای جوان، محیطی مناسب برای شکوفایی ایدهها ایجاد کنیم و به این ترتیب، خط مشی توسعهای کشور را به پیش ببریم.

وی در ادامه توضیحات خود به اهمیت تقویت دانشگاهها و پیوند آنها با صنعت و بازار تأکید کرد و گفت: پس از تقویت دانشگاهها، وظیفه ما است که با برگزاری رویدادهای هدفمند، درخواستها را با اقلام راهبردی کشور متصل کنیم. ما در این راستا تلاش کردهایم با محوریت بنیاد علم و بنیاد نخبگان، چشمههای اصلی دانشبنیانها را تقویت کنیم.

افشین با بیان اینکه کیفیت از اولویتهای اساسی است، افزود: ما به تجمیع شرکتهای دانشبنیان نگاه میکنیم، نه صرفاً افزایش تعداد آنها پس از پنج سال. مهم این است که چشمهها تنها راکد نمانند و جریانی فعال ایجاد شود که ورودی و خروجی مشخص داشته باشد.

معاون علمی، فناوری و اقتصاد دانشبنیان رییسجمهور بر پویایی اکوسیستم دانشبنیانها تأکید کرد و گفت: این اکوسیستم باید فضایی باشد که ورودی و خروجی معین داشته باشد. معاونت علمی خود تولیدکننده شرکت دانشبنیان نیست، بلکه مهمترین کار ما در این اکوسیستم ایجاد انگیزه و امید است.

افشین همچینن نقش رسانهها را حیاتی دانست و گفت: مهم است که سرمایهگذاران اعتماد کنند و بدانند که دولت و حاکمیت، کیفیت محصولاتشان را تضمین کرده و حمایتهای لازم را انجام میدهد. اعتماد به نفس و انگیزه، مهمترین رکن موفقیت در این مسیر است.

ابوالفضل مظاهری - AI Index ایرانی که قرار بود در آذرماه منتشر شود، پایان هفته گذشته منتشر شد. گزارش شاخص هوش مصنوعی ایران که نخستین نسخه آن در سال ۱۴۰۳ تلاش دارد تا خلأ نبود دادههای مدون از فعالیتهای هوش مصنوعی کشور در گزارشهای مطرح بینالمللی را جبران کرده و تصویر روشنی از جایگاه ایران در محورهای دارای اهمیت در این حوزه ارائه کند.

اپل برای عرضه مدلهای هوش مصنوعی خود در آیفونها و سایر محصولات خود در چین با یک نبرد سخت مواجه است و یکی از مقامات ارشد پکن هشدار داده است که شرکتهای خارجی برای کسب تاییدیه با یک «فرآیند دشوار و طولانی» مواجه خواهند شد، مگر اینکه با گروههای محلی همکاری کنند.

به گزارش ایسنا، تیم کوک(Tim Cook)، رئیس اپل، روز دوشنبه برای سومین بار در یک سال وارد چین شد. این شرکت در تلاش است تا فرآیند پیچیده نظارتی این کشور را پشت سر بگذارد و هوش اپل(Apple Intelligence) را به دستگاههای فروخته شده در چین برساند.

به نقل از فایننشال تایمز، در ماههای اخیر، این گروه آمریکایی، مذاکراتی را با شرکتهای فناوری چینی برای کمک به تقویت هوش اپل در این کشور انجام داده است. اپل ماه گذشته شروع به عرضه مجموعهای از قابلیتهای هوش مصنوعی در ایالات متحده بر روی آیفون و سایر دستگاههای خود کرد.

به گفته دو منبع آگاه به این موضوع، اپل همچنین در نظر دارد مدلهای زبانی بزرگ خود را در چین به اجرا بگذارد.

با این وجود یک تنظیم کننده ارشد فناوری چینی به فایننشال تایمز گفت که گروههای خارجی مانند اپل برای اجرای مدلهای خود با یک پروسه طولانی و پیچیده تاییدیه مواجه خواهند شد و شراکت با مردم محلی را بهترین گزینه برای آنها دانست.

این مقام عالی رتبه در اداره فضای سایبری چین گفت که استفاده از مدلهای زبانی بزرگ از پیش بررسی شدهی گروههای چینی به سازندگان دستگاههای خارجی یک فرآیند تاییدیه نسبتا ساده ارائه خواهد کرد.

این مقام چینی در حاشیه کنفرانس جهانی اینترنت که هفته گذشته در ووژن(Wuzhen)، غرب شانگهای برگزار شد، صحبت کرد. همه شرکتهایی که به دنبال ارائه خدمات هوش مصنوعی مولد به عموم هستند، باید یک فرآیند تأییدیه را طی کنند که معمولا شامل آزمایش رسمی مدلهای زبانی بزرگ آنها میشود. اپل از اظهار نظر در این مورد خودداری کرد.

اپل در سال جاری برای اختراع مجدد خود در زمینه هوش مصنوعی تلاش کرده است و معتقد است که مصرفکنندگان، دستگاههای خود را برای دسترسی به قابلیتهای جدیدی که در مدلهای قدیمیتر آیفون کار نمیکنند، ارتقا خواهند داد.

هفتخان اپل برای راهاندازی هوش مصنوعی در چین!

فروش اپل در چین در بحبوحه تشکیل یک کمپین از بالا به پایین برای کاهش استفاده از آیفون در میان کارمندان دولت چین کاهش یافته است.

بازگشت قهرمان ملی یعنی هوآوی، که پیشتر هوش مصنوعی مولد خود را در جدیدترین دستگاههای خود ادغام کرده است، تهدید دیگری برای اپل است.

در ایالات متحده، مدلهای اپل با استفاده از ترکیبی از پردازش روی دستگاه و سرورهای ابری اپل، ویژگیهایی مانند سیری، ابزارهای نوشتن، ویرایش عکس، و تولید ایموجیهای شخصیسازی شده را فراهم میکنند. این شرکت از مدلهای بسیار بزرگتر اُپنایآی استفاده کرده است.

اگر اپل نتواند از مدلهای خود در چین استفاده کند، آن را به مدلهای زبانی بزرگ شرکای چینی واگذار میکند تا تمام ویژگیهای هوش مصنوعی تولیدی در تلفنهای فروخته شده در چین را تامین کنند.

به گفته سه نفر از منابع آگاه، مذاکرات مرتبط با هوش مصنوعی اپل شامل گفتگو با غول جستجوی بایدو(Baidu) بوده است. یکی از افراد اضافه کرد که اپل همچنین با گروه فناوری ByteDance و Moonshot که استارت آپی است که چتبات هوش مصنوعی کیمی(Kimi) را ایجاد کرده، صحبت کرده است.

چین مهمترین بازار اپل در خارج از ایالات متحده است و در سال منتهی به سپتامبر، ۱۷ درصد از درآمد را به خود اختصاص داده است. اما فروش در این کشور نسبت به سال قبل هشت درصد کاهش داشته است.

هنگامی که کوک ماه گذشته از پکن بازدید کرد، به رسانههای محلی گفت که این شرکت به سختی روی اولین شرکت هوش اپل در چین کار میکند.

او گفت: فرآیند نظارتی بسیار خاصی پشت این موضوع وجود دارد و ما باید این فرآیند را تکمیل کنیم. ما همچنین امیدواریم که آن را در اسرع وقت برای مصرف کنندگان چینی فراهم کنیم.

اپل احتمالا یک رویکرد «انعطاف پذیر» را در پیش خواهد گرفت و شراکت با بایدو و همچنین سایر شرکتهای کوچکتر در چین را دنبال میکند. این کار، آنها را در «موقعیت بهتری برای دریافت تاییدیه» قرار میدهد.

معاون امور املاک و کاداستر سازمان ثبت اسناد و املاک کشور گفت: پروژه پژوهشی جهت بررسی تخلفات دفاتر اسنادرسمی با استفاده از هوش مصنوعی انجام شده و در حال بررسی میدانی نتایج اولیه به دست آمده هستیم تا پس از تائید صحت مدل تهیه شده، برنامه اجرایی بررسی تخلفات سردفتران با هوش مصنوعی تدوین شود.

به گزارش خبرگزاری صدا وسیما، معاون امور املاک و کاداستر سازمان ثبت اسناد و املاک کشور درباره اینکه آیا به غیر از آییننامه ماده ۳ قانون الزام به ثبت رسمی معاملات اموال غیرمنقول، آیین نامه دیگری تصویب شده است، گفت: با عنایت به اینکه چگونگی اقدام و اجرای مواد قانونی در این قانون موکول به تدوین و تصویب آیین نامههای اجرایی شده است، برابر مفاد قانون الزام به ثبت رسمی معاملات اموال غیرمنقول، اجرای آن نیازمند تدوین و ابلاغ ۱۴ آیین نامه اجرایی است.

صفدر کشاورز افزود: تعداد ۶ آیین نامه از جمله تبصره (۵) ماده (۱) قانون مذکور تهیه و به تصویب ریاست محترم قوه قضائیه خواهد رسید و تعداد ۸ آیین نامه از جمله تبصره (۱) ماده (۳) نیز توسط سازمان ثبت اسناد و املاک کشور با همکاری وزارتخانههای کشور، راه و شهرسازی، جهاد کشاورزی، صمت، اقتصادی و دارایی، بیمه مرکزی و بنیاد مسکن انقلاب اسلامی تهیه و به تصویب هیئت وزیران خواهد رسید. در این ارتباط نیز پیشنویس آیین نامه اجرایی ماده (۳) قانون (نحوه اتصال مشاورین املاک به سامانه ثبت الکترونیک اسناد و تقسیم اسناد بین دفاتر اسناد رسمی) تهیه و پس از جمع بندی نهایی در شورای راهبری اجرای قانون الزام به ثبت رسمی معاملات اموال غیرمنقول با حضور کلیه اعضاء دستگاههای مربوطه امضاء و جهت اجرا ابلاغ شده است.

کشاورز ادامه داد: پیش نویس آییننامههای ماده ۷، ماده ۱۰، تبصرههای ۱و ۲ و ۳ و ۶ ماده ۱۰ و تبصره ۳ ماده ۱۴ قانون مذکور توسط این سازمان تهیه و جهت بررسی و اظهار نظر محضر معاون اول قوه قضاییه ارسال شده است. پیش نویس آئین نامه تبصره یک ماده ۳ و تبصره ۴ ماده ۱۰ و ماده ۱۳ در حال تهیه و نهایی سازی توسط سازمان ثبت اسناد و املاک کشور و ارگانهای مرتبط است.

سخنگوی سازمان ثبت اسناد و املاک کشور گفت: همچنین پیش نویس آئین نامه تبصره ۵ ماده ۱ توسط معاونت محترم حقوقی و امورمجلس قوه قضائیه در حال تهیه است. پیش نویس آئین نامه تبصره ۸ ماده ۱۰ نیز توسط وزارت راه وشهرسازی وجهاد کشاورزی تهیه میشود.

کشاورز ادامه داد: برابر ماده (۳) و (۱۱) قانون الزام به ثبت رسمی معاملات اموال غیرمنقول، تنظیم قرارداد عادی نسبت به اسناد مالکیت حدنگاری که بعد از تاریخ (۳/ ۴/ ۱۴۰۳) صادر شده اند، از سوی مشاورین املاک و بنگاههای معاملاتی املاک ممنوع است و صرفاً ملزم به درج پیش نویس قرارداد در سامانه ثبت الکترونیک اسناد و ارسال آن به دفاتر اسنادرسمی هستند. در این راستا سازمان ثبت اسناد و املاک از تاریخ ۱۵/ ۵/ ۱۴۰۳ زیرساخت و شرایط لازم جهت اتصال کلیه مشاورین املاک و بنگاههای معاملاتی را به سامانه ثبت الکترونیک اسناد از طریق سکوی کاتب فراهم کرده است.

وی تاکید کرد: با پیگیریها و مکاتبات صورت گرفته با روسای دادگستری استانها و سازمان تعزیرات حکومتی تا کنون از مجموع ۱۴۷۳۵۴ مشاور املاک دارای پروانه کسب معتبر تعداد ۶۵۱۲۹ مشاور به سکوی کاتب متصل و تعداد ۲۰۵۵۳۵ پیش نویس تهیه و ۸۱۴۸ به سامانه الکترونیک اسناد ارسال شده است.

وی افزود: به منظور همگرایی و هماهنگی بیش از پیش دستگاههای اجرایی در راستای تکالیف ذکر شده در قانون الزام به ثبت رسمی معاملات اموال غیر منقول، جلسهای در روز شنبه مورخ ۲۶ آبان، نزد معاون اول قوه قضاییه با حضور همه دستگاههای مربوطه برگزار شد. در مجموع از حیث تدوین آئین نامهها، پیش نویس عمده آئین نامههای پیش بینی شده در قانون آماده، در حال بررسی و در شرف تائید و ابلاغ است. همچنین با برگزاری جلسات مشترک با دستگاههای اجرایی زمینه برای اجرای تکالیف مقرر در قانون فراهم میشود و انشاءالله با ابلاغ آئین نامههای لازم در اجرای قانون تسریع بیشتری به عمل خواهد آمد.

وی درباره رتبهبندی دفاتر اسناد رسمی نیز گفت: رتبه بندی دفاتر اسناد رسمی جهت تائید و امضای نهایی ریاست عالی سازمان ثبت اسناد ارسال شده است.

کشاورز درباره رسیدگی الکترونیکی به تخلفات سردفتران گفت: پروژه پژوهشی جهت بررسی تخلفات دفاتر اسنادرسمی با استفاده از هوش مصنوعی و یادگیری ماشین انجام شده است و در حال بررسی میدانی نتایج اولیه به دست آمده هستیم تا پس از تائید صحت مدل تهیه شده، برنامه اجرایی بررسی تخلفات سردفتران با هوش مصنوعی تدوین شود.

دیپفیک به عنوان یک فناوری پیشرفته هوش مصنوعی، توانسته تصاویر و ویدیوهایی جعلی، اما واقعینما تولید کند که تشخیص آنها را دشوار کرده است. با رشد حملات سایبری و کلاهبرداری دیجیتال، این فناوری به تهدیدی جدی برای امنیت اطلاعات و هویت افراد تبدیل شده است.

خبرگزاری میزان - مطمئناً در سالهای اخیر، عکسها و فیلمهای بسیاری دیدهاید که شکی نداشتید که کاملا واقعی است، اما با جستوجوی اخبار متوجه شدید که کاملا جعلی بوده؛ این جادوی فناوری دیپفیک است.

در سالهای اخیر، عکسها و فیلمهای جعلی بسیاری از افراد مشهور با استفاده از فناوری «دیپفیک» ساخته و در فضای مجازی منتشر شده است و به دنبال آن بینندگان بدون توجه به واقعی بودن آن، فیلمها و تصاویر منتشر شده را باور کرده و از طریق اشتراکگذاری، به انتشار بیشتر آن کمک کردند.

تصاویر و فیلمهایی که هیچگونه انطباقی با حقیقت ندارند، اما آنقدر واقعی است که بهسختی میتوان متوجه جعلی بودن آنها شد. بسیاری از سیاستمداران معروف همچون ترامپ و اوباما و بازیگران و سلبریتیها و مدیران مطرح دنیای فناوری مانند تیلور سوییفت و مارک زاکربرگ، همگی از افرادی بودند که در چند سال اخیر به واسطه عکسها و فیلمهای جعلی یا سخنرانیهای ساختگی، بهنوعی درگیر این فناوری دردسرساز شدهاند.

به نحوی که در فرایند برگزاری انتخابات ریاستجمهوری آمریکا، برخی شرکتهای نرمافزاری بزرگ دنیا طرحی برای انجام اقدامات جدیتری در مبارزه با اخبار جعلی و دیپفیک را در نظر گرفتند و حتی سازمان اطلاعات آمریکا (FBI) نیز طی بیانیهای درباره ویدئوهایی که با استفاده از دیپفیک ساخته شد و پیش از برگزاری انتخابات در فضای مجازی منتشر شد، هشدار داده بود.

دیپ فیک (DeepFake) یک تکنولوژی تقریبا جدید در حوزه هوش مصنوعی است. اصطلاح «دیپ فیک» یا «جعل عمیق» از ترکیب دو واژه Deep به معنای عمیق و Fake به معنای جعلی و دروغین ساخته شده است.

سال ۲۰۱۴ میلادی شخصی بهنام یان گودفلو (Ian Goodfellow)؛ یکی از پژوهشگران حوزه یادگیری ژرف و هوش مصنوعی، سیستم شبکه مولد تخاصمی (Generative Adversarial Network به اختصار GAN) شامل دو مدل مولد و متمایزگر را، به دنیای تکنولوژی معرفی کرد؛ شبکههای رقابتی مولد بهعنوان ابزاری در سیستمهای هوش مصنوعی برای تولید عکسها و ویدیوهای ساختگی (که در حال حاضر دیپفیک نامیده میشود)، به کار میروند.

این کشف جدید پس از سه سال، توسط فردی در ساخت یک ویدئو به کار گرفته شد و کاربری که این فناوری را در سال ۲۰۱۷، استفاده کرد نام آن ویدئو را «دیپفیک» گذاشت و ژانر جدیدی با نام «دیپفیک» خلق شد.

به این ترتیب، فناوری هوش مصنوعی مرزهای تکنولوژی را در حوزه «جعل» بسیار پیش برد و اگر در گذشته امکان داشت تنها یک عکس، توسط نرمافزارهای گرافیکی دستکاری شود و چیزی خلاف واقع یا به قول معروف فتوشاپی، به بیننده ارائه شود، امروزه فناوری خطرناکتری ایجاد شد که میتواند چهره و صدای افراد را بهطرز شگفتآوری جابه جا و یا تقلید کند و در قالب ویدیوهای باورپذیر منتشر کند.

فناوری دیپفیک میتواند بر مبنای هوش مصنوعی، تصاویر و ویدیوهای جعلی، اما «واقعینما» تولید کند و هر فردی را تحت تاثیر خود قرار دهد.

دیپ فیکها با بهرهگیری از یادگیری ژرف (Deep Learning) و حجم عظیمی از دادهها و شبکه عصبی مصنوعی ساخته میشوند و نتیجه محاسبات پیچیدهای هستند که میتوانند بهعنوان مثال از دو منبع تصویری مجزا، یک ویدیوی جعلی جدید بسازند، این دستکاری تنها به ویدیو خلاصه نمیشود و با استفاده از آن میتوان صدا را هم جعل کرد به نحوی که شخصی جملهای را در یک فیلم بگوید که هیچگاه در واقعیت نگفته است.

با وجود اینکه در سالهای اخیر، بر سواد رسانهای و توجه به «سند» و «واقعیت» برای پرهیز از فریب خوردن با محتواهای جعلی تاکید شده، اما با پیشرفت این فناوری، به نوعی سندها و فکتهای جعلی تولید شده است و این امر گاهی تشخیص حقیقت را غیرممکن کرده است که موضوعی بسیار خطرناک است.

از آنجا که مجرمان سایبری با پیشرفت راههای امنیتی در فضای دیجیتال، به تطبیق تکنیکها و روشهای خود برای یافتن راههای جدید ادامه میدهند و به دنبال کشف روشهای جدیدتری هستند، کلاهبرداری با کمک هوش مصنوعی در سطح جهانی بهطور فزایندهای در حال رشد است.

تحقیقات نشان میدهد، در سال ۲۰۴۴ برای اولین بار، جعل اسناد دیجیتال از جعل اسناد فیزیکی، بیشتر شده است و جعل دیجیتال ۵۷ درصد از کل تقلب در اسناد را به خود اختصاص داد.

طبق تحقیقات جهانی، در سال ۲۰۲۴ هر پنج دقیقه یک حمله دیپفیک اتفاق میافتد، و جعل اسناد دیجیتال ۲۴۴ درصد نسبت به سال قبل افزایش پیدا کرده است.

این تحقیقات نشاندهنده افزایش ۲۴۴ درصدی جعل اسناد دیجیتال در سال ۲۰۲۴ نسبت به سال ۲۰۲۳ و افزایش ۱۶۰۰ درصدی نسبت به سال ۲۰۲۱ است که در آن سال تقریباً تمام اسناد تقلبی جعلی، اسناد فیزیکی بودند.

با افزایش روشهای کلاهبرداری به کمک هوش مصنوعی، کلاهبرداران اکنون میتوانند از حملات پیچیدهتری در مورد اسناد، به ویژه کارتهای شناسایی (۴۰.۸ ٪ از حملات در سطح جهانی) استفاده کنند.

کلاهبرداران سایبری از پلتفرمهای «X as a service» (هر نوع سرویسی که بتوان در محیط اَبر و از هر جای دنیا و در لحظه ارائه کرد، مانند خدمات زیرساخت و نرم افزارها) برای فیشینگ، کلاهبرداری و باجافزار استفاده میکنند.

اشتراکگذاری دانش «best practices» (روال مطلوب: روش یا تکنیکی که منجر به نتایج بهتری نسبت به روشهای دیگر شده و بهدلیل اینکه بهطور عام توسط گروهی از افراد خبره یک رشته یا موضوع پذیرفته شده، بهعنوان یک شاخص استفاده میشود.) و استفاده از ابزارهای هوش مصنوعی مولد GenAI (نوعی از هوش مصنوعی که محتوای جدیدی مانند متن، تصاویر، فیلم و صدا تولید میکند) ایجاد حملات جعل دیجیتال و حملات تزریقی (Injection) پیچیده را تسهیل میکند.

در یک حمله از نوع تزریقی، مهاجم یک برنامه با ورودی مشکوک را تحت تأثیر قرار میدهد، به این صورت که مفسّر وب این ورودی را بهعنوان بخشی از یک دستور پردازش میکند و نحوه اجرای آن نرم افزار را تغییر میدهد.

حملات تزریقی، قدیمیترین و مضرترین حملات علیه برنامههای کاربردی وب هستند، این حملات ممکن است منجر به از دست دادن دادهها، از بین رفتن یکپارچگی دادهها، سرقت دادهها، انکار سرویس و به خطر افتادن کلی سیستم شود، معمولاً اصلیترین علت آسیبپذیری از طریق حملات تزریقی اعتبار سنجی ناکافی ورودی کاربران است.

هرچند از لحاظ تاریخی، بزرگترین تهدیدها از طریق حلقههای کلاهبرداری سازمانیافته بوده است. اما با توجه به تحقیقات انجام شده، احتمالاً با پیشرفت تکنولوژی در زمینه هوش مصنوعی، تعداد کلاهبرداران آماتور و مجرمان غیرسازمانیافته افزایش پیدا میکنند، که این افراد هم حجم حملات و هم تعداد حملاتی که از تکنیکهای پیچیده استفاده میکنند، را افزایش میدهند.

دیپفیک، به این دلیل مورد توجه سازمانهای جهانی قرار گرفته است، که ترفندهای کلاهبرداری در فضای مجازی مانند فیشینگ، که تشخیص آنها نسبتاً راحت است، بهسرعت جای خود را به دیپفیکهای بیش از حد واقعی و هویتهای مصنوعی تولید شده توسط هوش مصنوعی میدهد.

افزایش نرمافزارهای تعویض چهره و ابزارهای GenAI به کلاهبرداران این امکان را میدهد تا حملات کلاهبرداری بیومتریک (جعل هویت اشخاص) را بسیار باورپذیر انجام دهند. ظرفیت استفاده مخرب از این فناوری بسیار گسترده است و شامل افتتاح حسابهای تقلبی، تصاحب حساب، کلاهبرداریهای فیشینگ و کمپینهای اطلاعات نادرست میشود.

سه هدف اصلی مجرمان در سطح جهان (سال ۲۰۲۴) همگی مربوط به خدمات مالی در سه حوزه رمزارزی، بانکی و بانکهای سنتی بود، بهطوری که تلاش برای کلاهبرداری در حوزه ارزهای دیجیتال تقریباً دو برابر تعداد تلاشها در مقایسه با سایر حوزهها بود.

پلتفرمهای کریپتو (رمزارزی) بالاترین آمار در زمینه تلاش برای کلاهبرداری را به خود اختصاص دادهاند که نسبت به سال گذشته ۵۰ درصد افزایش یافته و از ۶.۴ درصد در سال ۲۰۲۳ به ۹.۵ درصد در سال ۲۰۲۴ رسیده است. این موضوع میتواند به دلیل رسیدن رمزارزها به بالاترین قیمت خود در سال ۲۰۲۴ باشد و این موضوع، فعالیت در زمینه رمزارزها را برای کلاهبرداران بسیار جذاب کرده است.

بنابراین، تغییرات بسیاری که در چشمانداز کلاهبرداری جهانی، از طریق افزایش قابل توجه حملات پیشرفته و مبتنی بر هوش مصنوعی ایجاد شده است، هشداری است که همه مدیران کسبوکارها و کاربران باید آن را جدی بگیرند.

آخرین اطلاعات و دادهها نیز بر این روند هشداردهنده تأکید میکند و نشان میدهد که کلاهبرداران چگونه به سرعت در حال تکمیل و بهبود روشها و تکنیکهای خود هستند. از آنجا که این تهدیدهای فراگیر، دولت و افراد را به طور یکسان تحت تأثیر قرار میدهند، تیمهای امنیتی برای پیش افتادن از کلاهبرداران، باید استراتژیهای خود را دائما به روزرسانی کنند و با روشهای جدید تطبیق دهند، و نظارت بر این تهدیدها را در اولویت قرار دهند و سازمانهای خود را برای رویارویی با این واقعیت جدید آماده کنند. این موضوع امری اجتنابناپذیر است که راه فراری از آن وجود ندارد.

هرچند توجه رسانهها و کاربران اینترنتی به پدیده «دیپفیک» کمرنگ شده است اما، تکنیک دیپفیک همچنان در فهرست تکنولوژیهای شگفتآور قرار دارد و پژوهشگران بسیاری در حال بهبود روشهای آن هستند.

برای کشف و جلوگیری از گسترش دیپفیک نیز باید از هوش مصنوعی کمک گرفت. در حال حاضر، راههایی وجود دارد تا یک عکس یا ویدیوی جعلی را تشخیص داد. دقت در نشانههای زیر میتواند به تشخیص یک تصویر یا ویدئوی جعلی کمک میکند:

معاون برنامهریزی وزارت ارتباطات و فناوری اطلاعات با اشاره به برخی چالشهای قانونی در حوزه هوش مصنوعی گفت: کشور در حال حاضر در حوزه هوش مصنوعی برنامه دارد و باید برنامه تقسیم کار ملی نیز تدوین شود که ما با همکاری سازمان ملی هوش مصنوعی و معاونت علمی در حال تهیه آن هستیم.

به گزارش ایسنا، علی اصغر انصاری در پنجمین نشست تخصصی هوش مصنوعی و اقتصاد که در سالن جلسات معاونت صدا و از سوی رادیو اقتصاد برگزار شد با اشاره به رتبهبندی کشورها در شاخص پذیرش هوش مصنوعی گفت: یکی از شاخصهای این رتبهبندی دارای چند زیر شاخص است که یکی از این شاخصها شامل برنامههای راهبردی و ساختاری این حوزه است.

وی افزود : چند سالی درگیر ایجاد ساختار هوش مصنوعی بودیم و در دولت سیزدهم از سوی شورای عالی انقلاب فرهنگی سند راهبردی هوش مصنوعی نهایی و به دنبال آن سازمان ملی هوش مصنوعی ذیل نهاد ریاست جمهوری راه اندازی شد.

انصاری یکی از چالشهای این حوزه را نیروی انسانی عنوان کرد و یادآور شد: کشور در زمینه تولید دانش و علم در رتبههای خوبی قرار دارد ولی در زمینه کاربرد و استفاده و بهرهبرداری از این علم و دانش در صنعت جایگاه مناسبی نداریم به گونهای که در سالهای اخیر تنزل رتبه نیز داشتهایم.

معاون برنامهریزی وزارت ارتباطات و فناوری اطلاعات با ابراز تأسف از اینکه در حوزه نیروی انسانی و استفاده از دانش هوش مصنوعی وضعیت مناسبی نداریم، خاطرنشان کرد: علم سنجی های انجام شده نشان میدهد که تحقیقات دانشگاهی انجام شده نیاز صنایع را مرتفع نمیکند و در این زمینه تامین زیر ساختها مسأله مهمی است. همچنین در بخش پردازشی این حوزه نیازمندیهای زیادی داریم که نیاز به تامین مالی داریم.

وی با بیان اینکه برای پذیرش هوش مصنوعی در صنایع نیاز به بهسازی صنایع داریم تاکید کرد که در این زمینه باید کار جدی صورت گیرد.

انصاری با اشاره به تصویب سند راهبردی هوش مصنوعی در شورای عالی انقلاب فرهنگی، افزود: در برنامه بند ب ماده ۶۵ قانون برنامه هفتم توسعه دولت مکلف شده است که برنامه اجرایی و برنامه ملی اکتساب هوش مصنوعی را تهیه کند و به اجرا بگذارد. در این سند قرار است تقسیم کار ملی در این حوزه ایجاد شود و نهادهایی که مکلف در اجرای این برنامه هستند، برنامه کاری آنها مشخص خواهد شد.

وی یکی از محورهای راهبردی این سند را موضوع حکمرانی نظام داده عنوان کرد و یادآور شد: از چالشهای موجود در دنیا در این حوزه میتوان به ابعاد حقوقی دسترسی به دادهها، حریم خصوصی، امنیت دادههای جمع آوری شده و پردازش شده اشاره کرد و اینها نکاتی است که دنیا در حوزه حکمرانی دادهها با آنها مواجه است.

وی با بیان اینکه ما در کشور در این حوزه اقداماتی را اجرایی کردهایم، گفت: در این زمینه یک سری لوایح وجود دارد که باید در مجلس و دولت مصوب شود تا بتوانیم این چالشها را از پیش رو برداریم.

انصاری با اشاره به برخی از قوانین حکمرانی داده در کشور، قانون دوام را یکی از قوانین در حوزه حکمرانی داده دانست که در زمینه تبادل داده و در اختیار قرار دادن داده به بهره برداران است و افزود: در زمینه استفاده از دادههای بخش خصوصی که بخشی از پلتفرمهایی که فعال شده، دادههای مردم جمعآوری شده است و در این زمینه ما دچار خلا قانونی هستیم و اگر لایحه در دولت و مجلس مصوب شود، برخی از موانع و چالشهای این حوزه مرتفع میشود.

معاون برنامهریزی وزارت ارتباطات و فناوری اطلاعات امنیت داده را یکی دیگر از چالشهای حوزه هوش مصنوعی ذکر کرد و گفت: ما باید به رشد اقتصادی ۸ درصد برسیم و همانطور که می دانیم اقتصاد ما یک اقتصاد نفتی است و شرکتهای برتر ما در اقتصاد در رتبه اول نفتی هستند و بعد از آن شرکتهای معدنی و صنایع فلزی قرار دارند در صورتی که در دنیا شرکتهای برتر شرکتهای IT محور هستند.

وی اظهار کرد: یکی از راهکارهایی که در برنامه هفتم مقرر شده است که به رشد ۸ درصدی برسیم، هوشمندسازی است ضمن آنکه صنایع باید برنامه تحول خود را تهیه و به اجرا بگذارند. از این رو یکی از راهکارهای برنامه هفتم برای رسیدن به رشد ۸ درصدی بحث بهرهبرداری و استفاده از راهکارهای هوشمند سازی است. این امر در انقلاب صنعتی چهارم نیز تمرکز بر هوشمند سازی و استفاده از هوش مصنوعی است.

انصاری اضافه کرد: ما در برنامه هفتم باید نظام اقتصاد دیجیتال را تهیه کنیم و کلیه بنگاههای اقتصادی و دستگاههای دولتی باید برنامه تحول دیجیتال را تهیه و به تصویب برسانند. همچنین برنامه ملی مهارتهای رقومی دیجیتالی نیز باید تهیه شود و دورههای مهارتی AI از دورههای قالب این مهارتها به شمار میرود.

وی با بیان اینکه موضوع نظام سنجش اقتصاد دیجیتال از دیگر برنامههای دولت است که اجرای آن بر عهده مرکز آمار واگذار شده است، افزود: در اجرای این برنامه وزارت ارتباطات همکاری دارد و موضوع هوش مصنوعی در بطن این برنامهها گنجانده شده است. کشور در حال حاضر در حوزه هوش مصنوعی برنامه دارد و باید برنامه تقسیم کار ملی نیز تدوین شود که ما با همکاری سازمان ملی هوش مصنوعی و معاونت علمی در حال تهیه آن هستیم.

معاون برنامه ریزی وزارت ارتباطات و فناوری اطلاعات افزود: یکی از تکالیفی که در سند راهبردی آمده و در برنامه هفتم نیز تکلیف شده موضوع نظام حکمرانی دادهها است که تدوین استانداردها، لوایح قانونی و موضوع در اختیار قرار دادن دادهها برای کسب و کارها تکلیف شده و در صورت تصویب تا حد زیادی راه در این حوزه هموار میشود.

آسیه فروردین - هوش مصنوعی (AI) در حال دگرگون ساختن عملکرد صنایع است و بهرهوری، دقت و ارائه خدمات را بهبود میبخشد. سایت thinkdigitalpartners در گزارشی نوشت: با توجه به اینکه ادغام هوش مصنوعی با فعالیتها، دیگر یک انتخاب نیست و به یک ضرورت تبدیل شده، سازمانهای خصوصی و دولتی، هردو، به دنبال راههایی برای ادغام هوش مصنوعی در چارچوبهای عملیاتی خود هستند.

رئیس مرکز آمار و فناوری اطلاعات قوه قضائیه گفت: با استفاده از هوش مصنوعی، زمان شناسایی اموال در پروندههای قضائی از ۴۰۰ روز به ۴ دقیقه کاهش یافته است.

به گزارش خبرگزاری مهر، محمد کاظمیفرد رئیس مرکز آمار و فناوری اطلاعات قوه قضائیه در جلسه شورای عالی قوه قضائیه با اشاره به تأکیدات مقام معظم رهبری در حوزه هوشمندسازی فرآیندها و بهرهگیری از فناوریهای نوین، اظهار کرد: ما تاکنون با استفاده از جدیدترین روشهای هوش مصنوعی و کمک گرفتن از شرکتهای دانشبنیان، توانستهایم ۱۰۵ میلیون تصمیم قضائی مشتمل بر ۱۰ میلیارد کلمه را با هدف آموزش و ایجاد دستیارِ هوشمندِ قضائی برای قضات و مردم، گمنامسازی کنیم.

وی با بیان اینکه در حال حاضر ۵۰ درصد فرآیند انتخاب کارشناس در مراجع قضائی سراسر کشور بر اساس معیارهایی همچون «شهر» و «صلاحیت» و به صورت هوشمند انجام میشود، گفت: هماکنون با استفاده از سامانه هوشمند استعلامات مالی، تمامی اموال اشخاص در فرآیندهای اجرای احکام و پروندههای اعسار، به صورت هوشمند و الکترونیکی شناسایی میشوند؛ تا به امروز در حدود یک میلیون و ۲۰۰ هزار پرونده، اموال اشخاص از این مسیر شناسایی شده است؛ ما با استفاده از این روش، موفق شدهایم فرآیند شناسایی اموال اشخاص برای قضات را از ۴۰۰ روز به ۴ دقیقه برسانیم.

رئیس مرکز آمار و فناوری اطلاعات قوه قضائیه عنوان کرد: پس از راهاندازی سامانه اطلاعات مؤثر افراد در سال ۱۴۰۱ و اطلاعرسانی آن، میزان افرادی که به کرَات تحت عنوان شاهد در مراجع قضائی حاضر میشدند، از ۸ هزار نفر به پنج هزار نفر کاهش یافته است؛ این سامانه به قضات کمک میکند افرادی را که برای دفعات متعدد تحت عنوان شاهد در دادگاهها و مراجع و محاکم قضائی حاضر میشوند را شناسایی کنند.

معیار جدید شرکت اوپن ای آی حاکی از آن است که مدل های هوش مصنوعی این شرکت و همچنین دیگر همتایان آن از پاسخگویی درست به سوالات ناتوان هستند و همه آنها توهم دارند.

به گزارش خبرگزاری مهر به نقل از فیوچریسم، شرکت اوپن ای آی یک معیار جدید به نام «پرسش و پاسخ ساده» (SimpleQA) ارائه کرده که هدف آن اندازه گیری دقت خروجی مدل های هوش مصنوعی خود و شرکت های دیگر است.

این شرکت هوش مصنوعی با انجام چنین اقدامی نشان داد مدل های جدید فناوری مذکور در فراهم کردن پاسخ درست به سوالات عملکرد بدی دارند. نسخه هوش مصنوعی o۱-preview این شرکت که ماه گذشته ارائه شد در آزمون جدید به نرخ موفقیت ۴۲.۷ درصد دست یافت.

به بیان دیگر حتی برترین مدل های بزرگ زبانی که به تازگی معرفی شده اند احتمال زیادی دارد به جای پاسخ درست، جوابی اشتباه به کاربر بدهند. با توجه به آنکه این فناوری در بسیاری از وجوه مختلف زندگی انسان ها نفوذ کرده، چنین امری نگران کننده است.

مدل های هوش مصنوعی رقیب مانند محصول شرکت «آنتروپیک» در آزمون SimpleQA امتیاز پایین تری کسب کردند، به طوریکه مدل تازه منتشر شده Claude-۳.۵-sonnet این شرکت فقط به ۲۸.۹ درصد سوالات پاسخ درست داد. با این وجود مدل مذکور بیشتر تمایل داشت عدم قطعیت خود را نشان دهد و از پاسخ دادن خودداری کند، که این امر با توجه به نتایج ناامید کننده احتمالا گزینه بهتری است.

در این میان اوپن ای آی متوجه شد مدل های هوش مصنوعی خود این شرکت توانمندی هایشان را فراتر از حد معمول تخمین می زنند. این ویژگی احتمالا سبب می شود تا مدل ها نسبت به پاسخ های اشتباهی که می سازند، اطمینان بیشتری داشته باشند.

مدل های زبانی بزرگ از مدت ها قبل با اشتباهات یا «توهمات» دست وپنجه نرم می کنند. این اصطلاحی است که شرکت های هوش مصنوعی برای تمایل محصولاتشان به تولید پاسخ های بی ربط به کارمی برند.

جدیدترین یافته های اوپن ای آی یک نشانه نگران کننده مهم در خود دارد و حاکی از آن است که مدل های زبانی بزرگ نمی توانند حقیقت را بیان کنند.

شرکت اوپن ای آی یک موتور جستجو در چت بات هوش مصنوعی «چت جی پی تی» را ادغام کرده که به کاربران اجازه می دهد اطلاعات به روز درباره اخبار، ورزش و آب وهوا دریافت کنند.

به گزارش خبرگزاری مهر به نقل از ایندپندنت، پس از آنکه اوپن ای ای در ماه می چنین محصولی را اعلام کرد، این نخستین باری است که شرکت به طور مستقیم سلطه موتور جستجوی گوگل را به چالش می کشد. ویژگی جدید برای کاربرانی که حق عضویت پرداخت می کنند، مهیا خواهد بود اما اوپن ای آی اعلام کرده در آینده برای دیگر کاربران به طور رایگان عرضه خواهد شد.

نسخه اولیه چت جی پی تی که در سال ۲۰۲۲ میلادی ارائه شد، با انبوهی از متون آنلاین آموزش دیده بود اما قادر نبود به سوالات درباره رویدادهای به روزی پاسخ دهد که داده های آن را هنگام آموزش دریافت نکرده بود.

از سوی دیگر گوگل در ماه می موتورجستجوی خود را مجهز به خلاصه های تولید شده با هوش مصنوعی کرد که به طور معمول بالای نتایج جستجو ظاهر می شوند. این خلاصه محتوا با هدف پاسخ سریع به جستجوی کاربر ارائه شده تا لازم نباشد آنها روی لینکی خاص کلیک یا برای دریافت اطلاعات از وب سایتی بازدید کنند. این ویژگی پس از یک سال آزمایش روی گروه کوچکی از کاربران ارائه شد اما هنوز هم استفاده از آن به اشتباهاتی منجر شد که خطر واگذاری جستجوی اطلاعات به رباتهای چت هوش مصنوعی مستعد ایجاد خطاها را نشان میداد.

در همین راستا اوپن ای آی برای فراهم کردن اطلاعات به روز با چند سازمان خبری و داده ای همکاری می کند که محتوای آنها در نتایج با پیوندهایی به منبع اصلی ظاهر میشود. این روند تقلیدی از موتورجستجوهای سنتی به حساب می آید.

سازمان های خبری مختلف از جمله آسوشیتدپرس، کندو نسته، فایننشال تایمز، هرست، لوموند، نیوز کورپوریشن و رویترز در این زمینه با اوپن ای آی همکاری می کنند.

سومین جلسه از سلسله جلسات هوش مصنوعی و حقوق اساسی با محوریت هوش مصنوعی و قانونگذاری در پژوهشکده شورای نگهبان برگزار شد. در این نشست به قابلیتها، چالشها و زیرساختهای بایسته استفاده از هوش مصنوعی در فرایند قانونگذاری و چشمانداز آن پرداخته شد.

به گزارش ایسنا، سومین جلسه از سلسله جلسات هوش مصنوعی و حقوق اساسی با محوریت هوش مصنوعی و قانونگذاری در پژوهشکده شورای نگهبان برگزار شد. در این نشست که با حضور مهرنوش ابوذری عضو هیئتعلمی دانشگاه تهران، زهرا تخشید استادیار دانشگاه دنور و عضو مؤسسه برکمنکلاین دانشگاه هاروارد برای اینترنت و جامعه و ایمان اکبری پژوهشگر دفتر مطالعات حکمرانی مرکز پژوهشهای مجلس برگزار شد، به قابلیتها، چالشها و زیرساختهای بایسته استفاده از هوش مصنوعی در فرایند قانونگذاری و چشمانداز آن پرداخته شد.

قابلیتها و چالشهای استفاده از هوش مصنوعی در فرایند قانونگذاری

زهرا تخشید استادیار دانشگاه دنور اولین سخنران این نشست، در مقدمه بحث خود به مفهوم هوش مصنوعی و ابعاد پیچیده آن اشاره کرد و اینکه باتوجه به تغییر مفهوم هوش مصنوعی در طول زمان بهتر است کمتر به تعریف هوش مصنوعی پرداخته و بیشتر به کاربردهای آن بپردازیم. بهزعم وی از همین روست که اسناد حقوقی که در این زمینه تدوین میشوند کمتر به تعریف هوش مصنوعی میپردازند؛ هر چند در برخی از اسناد نیز تعریف هوش مصنوعی طرح شده است.

وی همچنین افزود که در تعریف هوش مصنوعی میتوان به مفهوم خودکارسازی و اتوماسیون توسل جست و ابزارهایی که چنین کارکردی را ارائه میدهند واجد وصف هوشمندی دانست. از نگاه ایشان اما توسل به این مفهوم در دوران ظهور هوش مصنوعی مولد دیگر کافی نیست، چرا که با ظهور این نسل از هوش مصنوعی، قابلیت خلاقیت نیز خلاف نسلهای قبلی به مجموع قابلیتهای هوش مصنوعی افزوده شده است.

استادیار دانشگاه دنور در بیان زیرساختهای هوش مصنوعی به مفهوم پردازش زبان طبیعی (NLP) اشاره کرد و اینکه این حوزه موضوعی ذیل رشته هوش مصنوعی امکان تعامل انسان و ماشین از طریق زبان انسانی را فراهم کرده است. تا پیش از این تعامل انسان و ماشین از طریق زبانهای خاصی همچون پایتون و C+ برقرار میشد و به تعبیری زبان انسانی ملاک تعاملات انسان و ماشین نبود. در زمینه تعامل انسان و ماشین از طریق زبان انسانی، مدلهای زبانی بزرگ (LLM) نیز مورد استفاده قرار میگیرند که میتوان آنها را محصول پردازش زبان طبیعی دانست. ChatGPT بهعنوان یکی از پرکاربردترین سامانههای هوش مصنوعی از جمله مصادیق مدلهای زبانی بزرگ هستند. حرف «T» در عنوان این سامانه اشاره به مفهوم «Transformer» دارد که برای نخستین بار توسط شرکت Google Brain طراحی و معرفی شد. این مفهوم و فناوری امکانهای مختلفی را فراروی کاربران میگذاشت، از جمله اینکه براساس این فناوری، ماشین میتوانست گزارهها را در سیاق و زمینه خاص درک کند.

عضو مؤسسه برکمنکلاین دانشگاه هاروارد برای اینترنت و جامعه در زمینه چرایی اینکه صرفاً برخی کشورها توانستهاند به این مدلهای زبانی دست پیدا کنند، آن را ناشی از فقدان زیرساختهای پردازشی بزرگ دانست که هزینه دسترسی به آنها بسیار بالا بوده و عملاً این شرکتهای بزرگ هستند که میتوانند این زیرساختها را فراهم آورند و با توجه به اهمیت و ضرورت این زیرساختها و همچنین سرعت بالای تحولات در این حوزه میبایست تدابیر مناسبی در این زمینه اندیشیده شود تا فاصله زیرساختهای موجود در کشور با کشورهای پیشرفتهتر در این زمینه ثابت باقی بماند.

تخشید درباره قابلیتهای هوش مصنوعی در حوزه قانونگذاری به قابلیتهایی همچون تحقیقات مقدماتی برای تهیه پیشنویسهای قانون اشاره کرد و اینکه استفاده از این سامانهها تا حد زیادی میتواند موجب صرفهجویی در هزینههای مالی و زمانی شود. البته استفاده از این سامانهها چالشهایی دارد که از جمله آنها ناقص بودن این سامانههاست که موجب ارائه اطلاعات یا محتواهای غلط یا توهم آلود میشود. چالش دیگر نقض حریم خصوصی است که خصوصاً در مورد استفاده از هوش مصنوعی برای افکارسنجی یا تعامل با مردم مصداق دارد.

در ادامه جلسه مهرنوش ابوذری عضو هیئتعلمی دانشگاه تهران با اشاره به اینکه هوش مصنوعی میتواند در مراحل مختلف اعمال کارکرد تقنین، از جمله مرحله نیازسنجی و تهیه و تصویب قوانین، تنقیح قوانین مصوب و همچنین نظارت بر اجرای این قوانین یاریرسان باشد افزود: یکی از چالشهای نظام حقوقی ایران قوانین متروک است و این مهم، ضرورت نیازسنجی را بیشازپیش برجسته میکند.

وی افزود: در باب نیازسنجی، یکی از نکات ضروری، در اختیار داشتن منابع داده و قدرت پردازش بالاست که این مهم از حدود توانایی عامل انسانی خارج بوده و در این زمینه هوش مصنوعی میتواند نقشآفرینی مؤثر داشته باشد. هوش مصنوعی در این زمینه میتواند با تجمیع و تحلیل دادههای مختلف راجع به نظرات و ایدههای مطرح شده در سطح جامعه، انتظارات عمومی را استخراج کرده و جاذبه و دافعه مصوبات را با توجه به این دادهها ارزیابی و پیشبینی کند.

قابلیتها و چالشهای استفاده از هوش مصنوعی در فرایند قانونگذاری

عضو هیئتعلمی دانشگاه تهران در ادامه به کاربرد هوش مصنوعی در مورد همانندجویی و تنقیح قوانین اشاره کرد که انجام آن توسط عامل انسانی - خصوصاً در نظامهای حقوقی که درگیر چالش تورم قوانین هستند - بسیار دشوار است. از همین منظر هوش مصنوعی میتواند علاوه بر شناسایی شبکه قوانین و نسبت آنها با یکدیگر، به حل چالش تورم قوانین نیز کمک کند؛ به این ترتیب که در مرحله تصویب قانون جدید، نسبت آن با قوانین سابق - از حیث تعیین ناسخ و منسوخ، تخصیص زننده یا تخصیص شده و یا قوانین متعارض - بررسی شده و وضعیت قانون سابق در صورت تصویب قانون جدید تعیین تکلیف شود.

ابوذری در ادامه به تعامل نظام حکمرانی با مقوله هوش مصنوعی پرداخت و اینکه بسیاری از کشورهایی که در حال حاضر از قابلیتهای این فناوری استفاده میکنند بیمحابا تحتتأثیر قابلیتهای شگفتانگیز این فناوری هستند و کمتر راجع به چالشها و پیامدهای منفی آن توجه داشته یا چارهاندیشی کردهاند.

وی در ادامه به تعبیری اشاره کرد مبنی بر اینکه هوش مصنوعی خدمتگزاری وفادار و اربابی خطرناک است و شاید در حال حاضر از قابلیتهای آن بهره کافی برده میشود، اما با توجه به سرعت بالای تحولات این حوزه و ابعاد چالشبرانگیز آن، باید احتیاط اندیشی و آمادگی کافی در نظر گرفته شود.

ایمان اکبری پژوهشگر دفتر مطالعات حکمرانی مرکز پژوهشهای مجلس سخنران بعدی این نشست بود که به ابعاد مختلف استفاده از هوش مصنوعی در فرایند قانونگذاری پرداخت. وی ابتدا به فرایند قانونگذاری اشاره کرد؛ فرایندی که متشکل از مراحل مختلف از جمله مسئلهیابی و تدوین طرح یا لایحه، بررسی شکلی در معاونت قوانین، بررسی و اصلاحات تخصصی در کمیسیون اصلی و فرعی، بررسی و اصلاح در صحن علنی مجلس و نظارت شورای نگهبان بر مصوبات یا در موارد نادر ارجاع به مجمع تشخیص مصلحت نظام که نهایتاً به قانونی شدن مصوبه مجلس خواهد انجامید.

قابلیتها و چالشهای استفاده از هوش مصنوعی در فرایند قانونگذاری

از نگاه این پژوهشگر دفتر مطالعات حکمرانی مرکز پژوهشهای مجلس، هوش مصنوعی در هر یک از مراحل فوق میتواند نقشآفرینی جدی داشته و برای مثال با رصد فضای عمومی از طریق کلاندادهها و مجموعه قوانین موضوعه، خلأهای تقنینی را شناسایی کرده یا همچنین در مرحله دیگر میتواند ایرادات شکلی که طرح یا لایحه دارند ارزیابی کند. در این زمینه بازیگران مختلف، از عموم نمایندگان مجلس تا معاونت قوانین و مرکز پژوهشهای مجلس میتوانند از امکانهایی که هوش مصنوعی فراهم میکند استفاده کنند.

وی افزود: در حال حاضر آزمایشگاه حکمرانی مرکز پژوهشهای مجلس طرحهایی را در زمینه استفاده از هوش مصنوعی در فرایندهای قانونگذاری دنبال میکند.

پژوهشگر دفتر مطالعات حکمرانی مرکز پژوهشهای مجلس سخنان خود را با بیان الزامات زیرساختی استفاده از هوش مصنوعی در قانونگذاری ادامه داد. از منظر وی، داده، از جمله الزامات اولی و مقدماتی برای هر هوش مصنوعی است چرا که یادگیری الگوریتمهای هوش مصنوعی و ارائه پیشنهادها یا پیشبینیها توسط آن براساس این دادهها انجام میشود و در بحث استفاده از هوش مصنوعی در قانونگذاری، دادههای یادشده خصوصاً قوانین و سیاستهای بالادستی است که باید بهصورت ماشینخوان تبدیل شود. همچنین برای نیازسنجی باید کلاندادهها استخراج شوند و این مهم از طرق مختلف انجام میشود، مثلا نهادهای فعال در فرایند قانونگذاری، از جمله دولت و مجلس، میتوانند با برگزاری رویدادهای ایدهپردازی از ظرفیتهای خلاقانه فعالان عرصه هوش مصنوعی جهت تمهید زیرساختهای کلانداده استفاده کنند. فارغ از این، در مجموع نیاز به سرمایهگذاری کلان در این حوزه خصوصاً در بحث نگهداشت نیروی انسانی متخصص بسیار حائز اهمیت است.

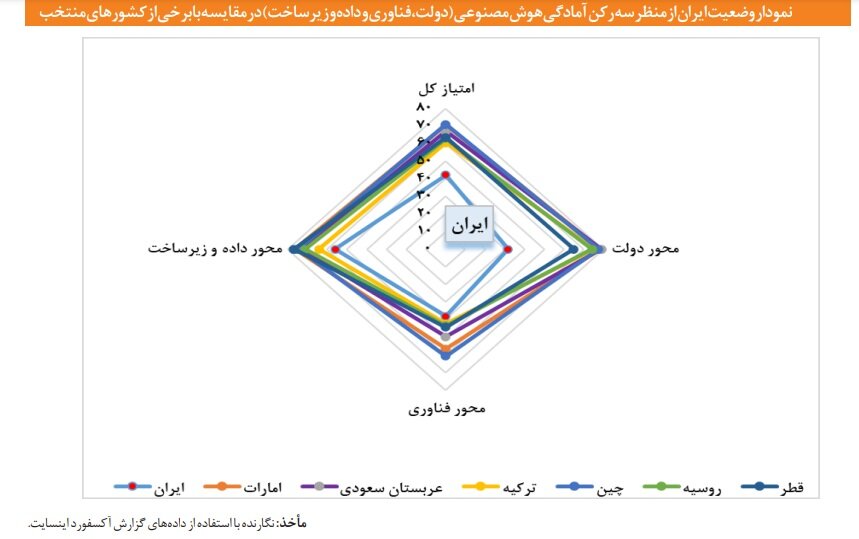

با وجود اینکه ایران در چاپ مقالات علمی شاخههای مختلف هوش مصنوعی تقریباً جزء ۲۰ کشور برتر دنیا است، در شاخص آمادگی هوش مصنوعی دولت رتبه ۹۳ را دارد.

به گزارش خبرنگار مهر، هدفگذاری سیاستگذاران کشور این است که ایران در عرصه هوش مصنوعی در زمره ۱۰ کشور برتر دنیا قرار گیرد. بر همین اساس برنامهریزیها برای توسعه، تنظیمگری و کاریست این فناوری سرعت بیشتری به خود گرفته است.

یکی از ابزارهای ارزیابی میزان توسعه و یا تنظیمگری در این حوزه، شناسایی شاخصهای مرتبط با هوش مصنوعی و تعیین جایگاه کشور در سطح جهانی است. یکی از این شاخصها، شاخص آمادگی هوش مصنوعی مؤسسه «آکسفورد اینسایت» است که به طور سالیانه کشورها را رتبهبندی میکند. این شاخص به دلیل تمرکز بر موضوع آمادگی دولتها و همچنین قدمت چند ساله آن، بیشتر مورد توجه کشورهاست.

مرکز پژوهشهای مجلس شورای اسلامی در گزارشی با عنوان «توسعه و تنظیمگری هوش مصنوعی (۲): شاخص آمادگی هوش مصنوعی دولت» به بررسی جایگاه ایران در شاخص آمادگی هوش مصنوعی مؤسسه آکسفورد اینسایت پرداخته است.

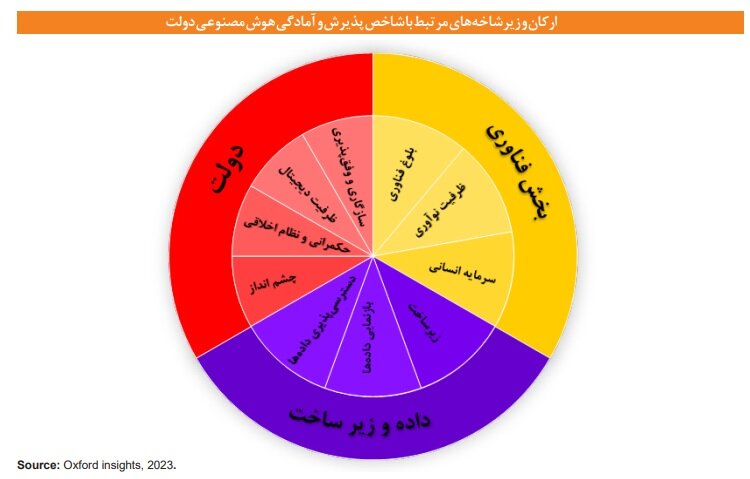

شاخص آمادگی هوش مصنوعی دولت که توسط مؤسسه آکسفورد اینسایت تدوین شده است، کشورها را در پذیرش هوش مصنوعی بر اساس سه رکن «دولت»، «بخش فناوری» و «داده و زیرساخت» بررسی و رتبهبندی میکند. این مؤسسه دادههای خود را از پایگاههای بانک جهانی و سازمان ملل استخراج کرده و با طبقهبندی کشورها به ۹ ناحیه، رتبه ۱۹۳ کشور را از منظر آمادگی دولتها برای پیادهسازی و ادغام هوش مصنوعی در بخش خدمات عمومی ارزیابی میکند.

در آخرین گزارش مؤسسه آکسفورد اینسایت که در سال ۲۰۲۳ منتشر شده است، ۱۹۳ کشور رتبهبندی شدند.

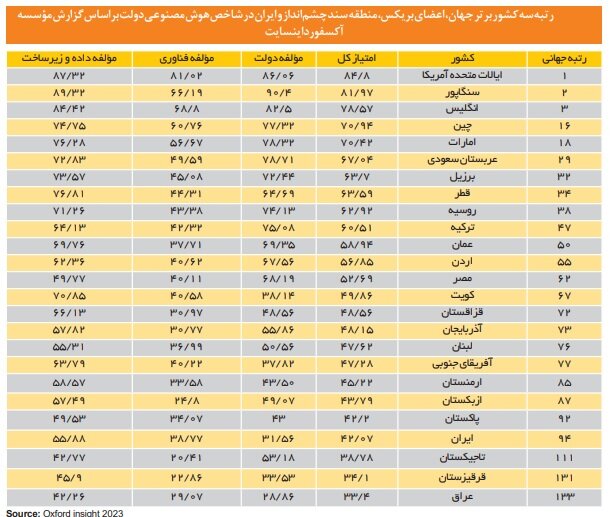

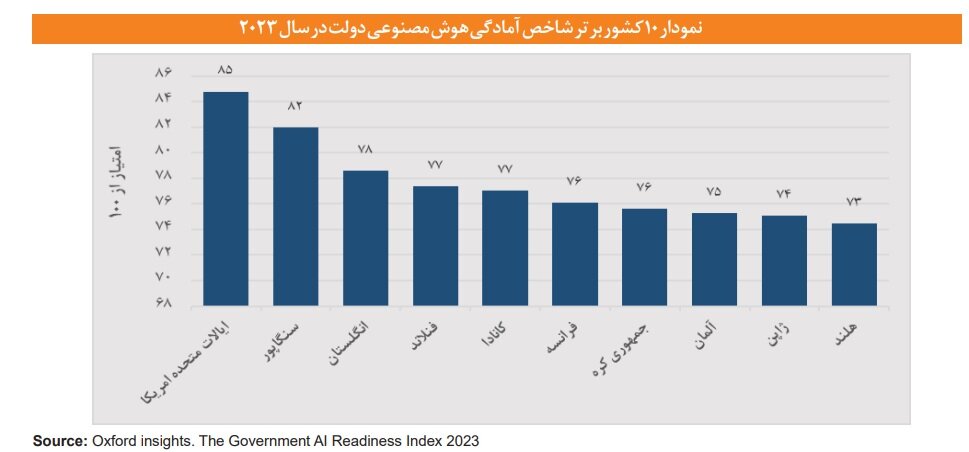

در جدول زیر، رتبه سه کشور پیشروی جهان در عرصه هوش مصنوعی، کشورهای عضو بریکس، کشورهای منطقه سند چشمانداز ایران قابل مشاهده است. بر اساس این رتبهبندی؛ کشورهای آمریکا، سنگاپور و انگلیس به ترتیب از نظر شاخص آمادگی دولتها، نسبت به سایر کشورها پیشرو هستند. چین در این رتبهبندی جایگاه شانزدهم را دارد.

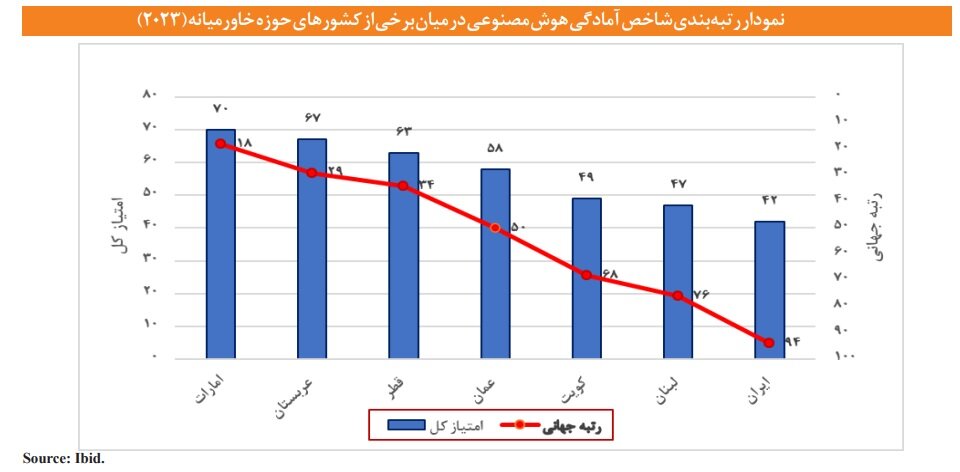

در بیشتر کشورها، رکن فناوری با ابعادی همچون سرمایه انسانی، ظرفیت نوآوری و بلوغ و تکامل فناوری کمترین امتیاز را دارد. در این میان کشورهای عربی منطقه خاورمیانه با توجه به سرمایهگذاری در تقویت زیرساختها و تدوین اسناد و راهبردهای مرتبط با استقرار هوش مصنوعی توانستهاند در ایجاد آمادگی هوش مصنوعی و دریافت امتیازاتی که آنها را در زمره ۵۰ کشور برتر جهانی در این شاخص قرار میدهد، پیشرفت محسوسی داشته باشند.

وضعیت ایران در مؤلفههای شاخص آمادگی هوش مصنوعی

رتبه جهانی ایران در سال ۲۰۲۳ در این شاخص ۹۴ است. در شکل زیر امتیازات ایران و کشورهای عربی همجوار به انضمام چین و روسیه در هر یک از ارکان این شاخص نشان داده شده است.

کشورهای عربی همسایه ایران از جمله امارات، عربستان سعودی، قطر و سایر کشورهای مهم از قبیل چین، روسیه و ترکیه در گام اول با تدوین و تصویب راهبردهای هوش مصنوعی و تقویت زیرساختهای داده و اطلاعات به دنبال بهبود آمادگی سازمانی ساختارهای خود در هوش مصنوعی هستند. توسعه و انتقال فناوری در کنار افزایش میزان سرمایهگذاری هوش مصنوعی در چین، امارات و همچنین عربستان، افزایش ظرفیتهای نوآوری و بلوغ فناوری را در پی داشته است. کشور ترکیه اگرچه در بحث ایجاد ظرفیتهای فناورانه و تقویت زیرساختهای داده نسبت به سایر کشورهای منتخب ذکر شده عقبتر است، اما به مراتب وضعیت مطلوبتری در مقایسه با ایران دارد.

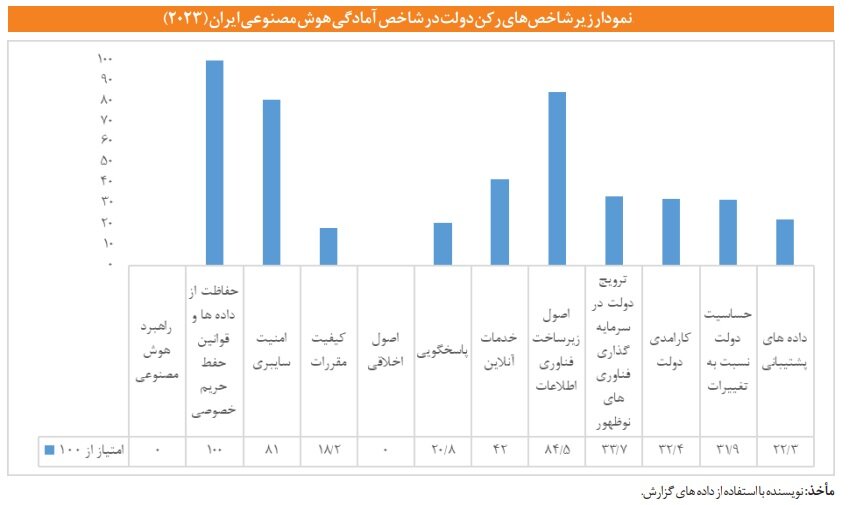

رکن «دولت»؛ ضعیفترین بخش ایران در شاخص آمادگی هوش مصنوعی

ضعیفترین رتبه ایران در شاخص هوش مصنوعی آکسفورد مربوط به رکن «دولت» است که امتیاز آن ۳۱.۵۶ ثبت شده است. یکی از دلایل رتبه پایین ایران در شاخص آمادگی هوش مصنوعی میتواند کم بودن امتیاز ایران در رکن دولت و نبود سند ملی متقن و مصوب هوش مصنوعی حاوی چارچوبهای مشخص از اولویتهای هوش مصنوعی و کارآمدی بخشهای مختلف در پذیرش و انطباق با این فناوری در سال تدوین گزارش توسط آکسفورد باشد؛ اما به نظر میرسد با تصویب سند ملی هوش مصنوعی در تیرماه ۱۴۰۳ به احتمال قوی امتیاز ایران در زیرشاخصهای محور دولت در گزارش آتی این مؤسسه لحاظ شده و شاهد بهبود رتبه کشور در سال آتی باشیم.

در بعد حکمرانی و اخلاق ذیل رکن دولت ۵ عامل مورد بررسی قرار میگیرند که عبارتند از وجود قانون مربوط به «حفاظت دادهها و حفظ حریم خصوصی»، «امنیت سایبری»، «کیفیت مقررات»، «اصول اخلاقی» و «مسئولیت پذیری».

ایران در بعد اخلاق و حکمرانی نیز امتیازات خوبی نداشته است. برای محاسبه امتیازات لازم در اخلاق هوش مصنوعی که مؤسسه آکسفورد تعریف کرده است، از شاخصهای کیفیت مقررات از مجموعه شاخصهای حکمرانی جهانی بانک جهانی مورد استفاده قرار گرفته است. هرچند توجه ایران به موضوع مدیریت داده در قالب قانون «مدیریت دادهها و اطلاعات ملی» مصوب سال ۱۴۰۱ و نیز حفاظت از داده در قالب قوانینی همچون «قانون تجارت الکترونیکی» مصوب سال ۱۳۸۲ و همچنین لایحه «حفاظت از دادهها» که در حال طی مراحل تصویب در دولت جهت ارائه به مجلس است، امتیازات مثبتی از نظر منظر وجود قوانین تلقی شدهاند؛ اما در نهایت در بعد حکمرانی و اخلاق امتیاز منفی ۱.۵۹ کسب کرده که در سطوح پایین رتبهبندی آکسفورد قرار دارد. به ویژه آنکه ایران از جمله کشورهایی بوده که در سال بررسی و تدوین گزارش آکسفورد رهنمود اخلاق هوش مصنوعی را تدوین نکرده و لذا امتیاز این بخش را از دست داده است.

زیر شاخصهای مربوط به ظرفیت دیجیتال ذیل رکن دولت شامل «خدمات بر خط دولت»، «اصول زیرساختهای فناوری و اطلاعات» و «حمایت دولت از سرمایهگذاری در فناوریهای نوظهور» است.

در محور تطبیق پذیری نیز آمدی دولت حساسیت دولت به تغییرات و دادههای پشتیبانی اندازهگیری میشود. امتیاز ایران ر تمامی زیر شاخصهای مربوط به رکن دولت در شاخص آمادگی هوش مصنوعی در قالب شکل زیر نشان داده شده است.

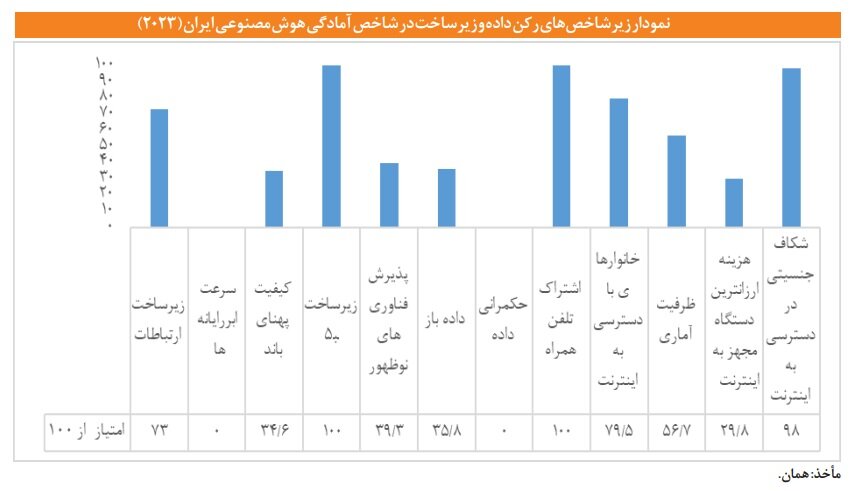

وضعیت به نسبت بهتر «رکن زیرساخت و داده»

امتیاز ایران در رکن زیرساخت و داده نسبت به سایر ارکان بهتر است؛ هرچند که نسبت به سایر کشورهای مورد مطالعه عقبتر هستیم.

این رکن دارای سه دسته اصلی «زیرساخت»، «دسترسی دادهها» و «بازنمایی دادهها» است. در دسته زیرساختها، زیرساختهای مخابراتی، ابر رایانهها، کیفیت پهنای باند، زیرساخت 5G و پذیرش فناوریهای نوظهور جهت محاسبه امتیاز کشورها مورد ارزیابی قرار گرفته است. در دسترسی به دادهها نیز موضوع دادههای باز، حکمرانی دادهها، اشتراک تلفن همراه، خانوارهای با دسترسی به اینترنت و ظرفیت آماری مد نظر بوده است.

کشور ایران در طی سالهای ۲۰۲۲ تا ۲۰۲۳ روندی صعودی در بهبود زیرساختها و اشتراک تلفن همراه طی کرده؛ اما از منظر کمرانی دادهها و ظرفیت آماری عملکرد ضعیفی داشته است.

امتیاز حکمرانی داده از طریق امتیاز بلوغ محیط تنظیمگری فناورانه دادههای بانک جهانی محاسبه شده است که در آن جنبههای کلیدی رویکرد کل دولت، از جمله ابر دولتی، چهارچوب قابلیت همکاری با سایر سکوها، بلوغ پرتالهای خدمات عمومی برخط با تمرکز بر طراحی شهروند محور و دسترسی جهانی و نیز ابعاد سکوهای مشارکت عمومی، مکانیسم بازخورد شهروندان، دادههای باز و پورتالهای دولتی باز مورد بررسی قرار گرفته است. امتیاز ایران در محور حکمرانی دادهها صفر گزارش شده است.

زیر شاخه بازنمایی دادهها؛ شامل «هزینههای ارزانترین دستگاه مجهز به اینترنت» و «شکاف جنسیتی در دسترسی به اینترنت است» که امتیاز محاسبه شده برای ایران در این دسته نیز مطلوب نبوده و نسبت به سالهای گذشته روندی نزولی طی کرده است. امتیاز کشور در تمامی زیر شاخصهای مربوط به رکن داده و زیرساخت در شاخص آمادگی هوش مصنوعی در شکل زیر نشان داده شده است.

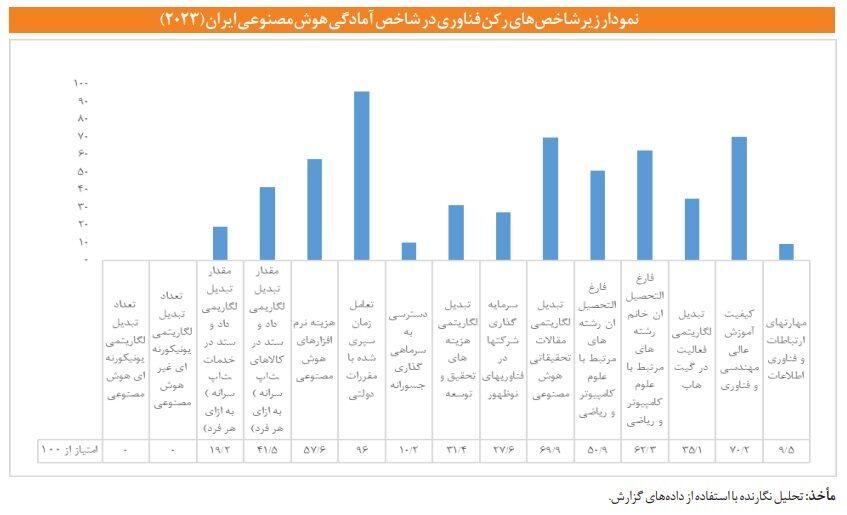

جایگاه ایران در رکن «فناوری»؛ متوسط رو به پایین

در رکن فناوری زیر شاخصهایی از قبیل «سرمایه انسانی»، «ظرفیت نوآوری» و «بلوغ فناوری» مورد توجه قرار میگیرد. در این رکن نیز امتیاز کشور متوسط رو به پایین ارزیابی شده است و ایران باز هم نسبت به سایر کشورها عقبتر است.

در بخش بلوغ فناوری به تعداد «یونیکورنهای هوش مصنوعی و غیر هوش مصنوعی»، «ارزش تجارت خدمات فناوری اطلاعات و ارتباطات»، «مقدار تبدیل لگاریتمی داد و ستد در کالاهای فناوری اطلاعات و ارتباطات» و «هزینههای نرمافزاری کامپیوتری» میپردازد تا بررسی کند که آیا کشور مد نظر دارای بخش فناوری توانمندی است که بتواند فناوریهای هوش مصنوعی را به دولتها عرضه کند یا خیر؟

در زیر شاخصهای بلوغ فناوری، «مقدار لگاریتمی داد و ستد در خدمات فناوری اطلاعات و ارتباطات» با امتیاز ۱۹ کمترین مقدار را دارد. به علت اینکه برخی زیر شاخصها مانند ارتباطات راه دور، خدمات کامپیوتر، مجموعه خدمات مخابراتی و کامپیوتری و نسبت این خدمات به کل خدمات برای کشور در تعیین امتیاز نهایی بلوغ فناوری لحاظ نشده، در نهایت امتیاز کم و جایگاه پایینی برای کشور ثبت شده است.

در تعیین هزینه نرمافزارهای هوش مصنوعی امتیازهایی مانند وضعیت اقتصاد کشور، ناحیهای که کشور وجود دارد (مانند اروپا و آسیای مرکزی، خاورمیانه و شمال آفریقا و غیره) و سطح درآمد کشور (مانند متوسط درآمد، حد بالای درآمد، حد پایین درآمد) دخیل بودند که بر اساس آن ایران توانسته در سطح متوسطی قرار گیرد.

از نظر ظرفیت نوآوری در هوش مصنوعی وضعیت کشور در این سالها (از سال ۲۰۲۰ تا سال ۲۰۲۳) روندی رو به بهبود داشته است. این دسته به «زمان صرف شده برای رسیدگی به مقررات دولتی»، «در دسترس بودن میزان سرمایهگذاری جسورانه»، «هزینه تحقیق و توسعه»، «سرمایهگذاری شرکتها در فناوریهای نوظهور» و «مقالات تحقیقاتی منتشر شده در هوش مصنوعی» میپردازد و در نهایت بررسی میکند که آیا بخش فناوری شرایط مناسبی برای حمایت از نوآوری دارد یا خیر؟

علاوه بر این در محور سرمایه انسانی نیز به بررسی «تعداد فارغ التحصیلان رشته کامپیوتر» و «فعالیتهای گیتهاب» و «مهارتهای فناوری اطلاعات و ارتباطات» پرداخته شده و در نهایت بیان میکند که آیا مهارتهای مناسبی در جمعیت برای حمایت از بخش فناوری وجود دارد یا خیر؟ به نقل از سایت گیتهاب؛ افزایش گسترده تعداد توسعه دهندگانی که در حوزه هوش مصنوعی مولد کار میکنند، بر کسب و کارها تأثیر خواهد گذاشت. همانطور که بیشتر توسعه دهندگان با ساخت برنامههای کاربردی مبتنی بر هوش مصنوعی آشنا میشوند، انتظار میرود که یک مجموعه افراد مستعدی ایجاد شود که به دنبال تقویت مشاغلی برای توسعه محصولات و خدمات مبتنی بر هوش مصنوعی خود هستند.

امتیاز مرتبط با مهارتهای ارتباطات و اطلاعات از سایت اتحادیه بین المللی مخابرات (ITU) به دست میآید. از آنجا که کشورهای بسیار کمی اطلاعات همه مهارتها که عبارتند از مهارتهای مرتبط با سواد اطلاعاتی، توانایی حل مسئله، ایمنی و ایجاد محتوا را ارائه کردهاند، لذا مقدار امتیاز این محور نمیتواند دقیق باشد. از طرفی تجزیه و تحلیل این دادهها از طریق دامنههای مهارتهای گزارش شده در کشورهای مختلف است. به طوری که میانگین درصد مهارت ذکر شده بین کشورهای مختلف بین حداقل ۲۵ تا حداکثر ۷۵ درصد است. این شکاف بین افرادی که از اینترنت استفاده میکنند و افرادی که دارای مهارتهای دیجیتال هستند، بیانگر این است که بسیاری ممکن است از اینترنت استفاده کنند، بدون اینکه بتواند به طور کامل از آن بهره ببرند یا از خطرات آن اجتناب کنند. امتیاز کشور در تمامی زیر شاخصهای مربوط به رکن فناوری در شاخص آمادگی هوش مصنوعی در شکل زیر نشان داده شده است.

به نظر میرسد با نبود سند و برنامه توسعه هوش مصنوعی در کشور تا به امروز، برنامههای حمایت از نوآوری و کمک به بلوغ فناوری یا ظرفیت تربیت نیروی انسانی در هوش مصنوعی و آموزش به نیروی کار در قالب مهارت نیز تا به امروز به صورت هدفمند و شفاف دنبال نشده است.

سد فیلترینگ بر سر راه توسعهدهندگان عرصه هوش مصنوعی

رویکرد کشور در حال حاضر در سرمایهگذاری و مشارکتهای بینالمللی از طریق سکوهای توسعه دهنده وب، شفاف و مشخص و نظاممند نیست.

با بررسیهای انجام شده، سایت گیتهاب به دلیل محدودیتهای موجود در ایران اعم از سرعت پایین اینترنت، عدم دسترسی به پردازندههای گرافیکی پرسرعت و فیلترینگ در ایران با محدودیتهای جدی مواجه است. زیرا کاربران به دلیل کمبود امکانات و فیلترینگ (در برهههای حساس زمانی)، و عدم دسترسی به برخی بخشهای سایت کگل و گیت هاب که ارائه کننده پروژهها و مجموعه دادههای بسیار بزرگ و به روز هستند، امکان انجام پروژههای بسیار قوی را در این حوزه ندارند و گاهی کاربران مجبور به استفاده از فیلترشکن میشوند که این امر سبب میشود آی پی سیستم کاربران ایرانی تغییر کرده و به آی پی کشور دیگری تبدیل شود و آیپی کشور ایران به درستی تشخیص داده نشود و پروژه و مجموعه داده بر اساس کشور اختصاص داده شده توسط فیلترشکن برای کشورهای دیگر در نظر گرفته میشود. در صورت رفع این محدودیتها کشور ایران نیز میتواند در این شاخص دارای جایگاه و امتیاز بهتری باشد. در صورت رفع این محدودیتها کشور ایران نیز میتواند در این شاخص جایگاه و امتیاز بهتری کسب کند. جایگاه و امتیاز ایران در شاخص آمادگی هوش مصنوعی برای استفاده از سایت گیت هاب به عنوان مخازن پروژههای هوش مصنوعی به دلایل بالا با مشکلات و محدودیتهای جدی روبروست که این امر نیاز به بازنگری مجدد دارد.

سوگیری سیاسی در امتیازدهی زیرشاخصهای پاسخگویی و شفافیت

در این گزارش عنوان شده که برخی زیر شاخصهای امتیازدهی ذیل ارکان آمادگی هوش مصنوعی دولت از جمله پاسخگویی و شفافیت به لحاظ سیاسی بودن و سوگیری منفی یا مثبت فاقد دلیل آشکار نسبت به برخی کشورها (مثلاً امتیازات منفی برای ایران و امتیازات مثبت برای کشورهای عربی) قابل تأمل و حائز اعتبار مخدوش است. علاوه بر این برخی زیر شاخصها نیز به علت عدم ارائه داده و اطلاعات کافی فاقد امتیاز محسوب شده و در نتیجه امتیاز کلی شاخص را پایین آورده است. لذا شاید نتوان جمع نهایی امتیاز و رتبه این شاخص را دقیق و نهایی تلقی کرد. اما در ارائه تصویری اجمالی از وضعیت هوش مصنوعی در کشور و در مقایسه با سایرین، از منظر دولت و حکمرانی، زیرساختهای داده و اطلاعات و ظرفیتهای نوآوری و فناوری مهم است. یکی از مشخصههای آمادگی دولتها در هوش مصنوعی، در هم تنیدگی سه رکن یاد شده و مؤلفههای ذیل آن است. به نحوی که هرگونه ضعف در یکی بقیه عوامل را نیز متأثر میسازد. این موضوع نشان میدهد که توسعه متوازن هوش مصنوعی از همه ابعاد آن لازم و اجتناب ناپذیر است.

توسعه هوش مصنوعی نمیتواند تنها معطوف به تولید دانش باشد

در این گزارش عنوان شده است که با وجود اینکه ایران در تولید دانش و چاپ مقالات علمی در شاخههای مختلف هوش مصنوعی تقریباً جز ۲۰ کشور برتر دنیاست، با وجود این، قرارگرفتن در زمره ۱۰ کشور برتر هوش مصنوعی در دنیا به عنوان یکی از چشماندازهای توسعه این فناوری و بهکارگیری آن نمیتواند فقط معطوف به تولید دانش در این حوزه باشد.

یکی از مشخصههای آمادگی دولتها در هوش مصنوعی، در هم تنیدگی سه رکن دولت، زیرساخت، فناوری و مؤلفههای ذیل آن است. این در حالی است که تدوین و تصویب برنامههای عملیاتی توسعه هوش مصنوعی در کشور که بر این سه رکن تأثیر دارند، به صورت بخشی و عمدتاً به کندی پیش میرود و این امر ممکن است از انسجام و یکپارچگی آنها نیز بکاهد. لذا به نظر میرسد بهبود جایگاه کشور در شاخص آمادگی دولت در پذیرش هوش مصنوعی میتواند از ابعاد زیر مورد توجه قرار گیرد:

- ایجاد چابکی و پویایی در ساختار حکمرانی هوش مصنوعی در کشور با شفاف شدن نقشها و تعیین دامنه وظایف نهادهای سیاستگذار نسبت به یکدیگر؛

- تدوین و تصویب هرچه سریعتر برنامههای شفاف و عملیاتی توسط دستگاههای متولی، یکپارچهسازی و نهاییسازی آنها، تسلط سازمان ملی هوش مصنوعی و نظارت بر اجرای آنها؛

- توجه به ملاحظات اخلاقی و اجتماعی هوش مصنوعی در قالب تدوین سندها یا توصیهنامهها؛

- سرمایهگذاری و مشارکتهای بینالمللی از طریق سکوهای توسعهدهنده وب و با تمرکز بر پروژههای هوش مصنوعی با در نظر گرفتن منافع و مصالح کشور؛

- استمرار و اهتمام به توسعه زیرساختهای ارتباطات و اطلاعات و بازبینی و ارائه اطلاعات دقیقتر از وضعیت خدمات برخط برای مشارکت فعالتر در ارزیابی توسط این شاخص و بهبود جایگاه نقش آفرینی کشور در عرصه هوش مصنوعی از نگاه بینالمللی.

سخنگوی دولت گفت: اساسنامه سازمان ملی هوش مصنوعی در معاونت علمی در حال تدوین است و در شورای عالی انقلاب فرهنگی به تصویب میرسد. همچنین، ریاست شورای راهبردی این سازمان با دستور رئیس جمهور به دکتر عارف؛ معاون اول رئیس جمهور تفویض شده است.

به گزارش تسنیم، فاطمه مهاجرانی؛ سخنگوی دولت در حاشیه آیین اختتامیه المپیک فناوری در جمع خبرنگاران اظهار کرد: طبق اعلام دکتر افشین؛ معاون علمی ریاست جمهوری، اساسنامه سازمان ملی هوش مصنوعی در حال تدوین است.

وی در پاسخ به این سوال که آیا این اساسنامه در معاونت علمی تدوین می شود یا در شورای عالی انقلاب فرهنگی گفت: تصویب این سند قاعدتاً اساسنامه باید در شورای عالی انقلاب فرهنگی به تصویب برسد و تدوین آن در سازمان متولی که در اینجا معاونت علمی است صورت بگیرد.

مهاجرانی درباره سازمان متولی هوش مصنوعی بیان کرد: زمانی که نهادی تازه تأسیس بوده و ساختار آن در حال شکلگیری است، معمولاً نهادی مرتبط با حوزه فعالیت آن، به طور موقت مسئولیت آغازین را بر عهده میگیرد تا زیرساختهای اولیه فراهم شود.

سخنگوی دولت افزود: اساسنامه این سازمان در معاونت علمی در حال تدوین است و در شورای عالی انقلاب فرهنگی به تصویب میرسد. همچنین، ریاست شورای راهبردی این سازمان با دستور رئیس جمهور به دکتر عارف، معاون اول رئیس جمهور تفویض شده است.

وی با بیان اینکه به طور دقیق نمیدانم این اساسنامه تا چه زمانی نهایی و تصویب می شود یادآور شد: اینکه به معاون اول اختیارات تفویض شده به این معنا است که اختیاراتی که بنا بوده شخص رییسجمهور داشته باشد به معاون اول تفویض شده است.

سخنگوی دولت، سایر سوالات خبرنگاران را موکول به کسب اطلاعات بیشتر درباره اساسنامه سند هوش مصنوعی اعلام کرد.

عضو شورای عالی انقلاب فرهنگی گفت: برای تدوین سند ملی هوش مصنوعی جمهوری اسلامی ایران اسناد ۳۰ کشور در این رابطه مطالعه شد. گروههای مطالعاتی کار پژوهشی کردند و صدها نفر در فرایند تدوین این سند با نظرات و ایدههایشان مشارکت داشتند.

محمدحسین ساعی، عضو شورای عالی انقلاب فرهنگی و رئیس دانشگاه سوره در گفتوگو با ایرنا، درباره روند تدوین سند ملی هوش مصنوعی جمهوری اسلامی گفت: از سال ۱۳۹۷ در شورای عالی انقلاب فرهنگی و شورای عالی فضای مجازی بحث هوش مصنوعی مطرح شد. بحث این که ما باید چه کار کنیم و استراتژی کشور چه باشد. گروه های مطالعاتی کار پژوهشی کردند و در کنار دانشگاهها و بخش خصوصی صدها نفر با نظرهایشان مشارکت داشتند. سال ۱۴۰۱ این مباحث خدمت شهید رئیسی، رئیس جمهور وقت مطرح شد.

وی افزود: نکته این بود که چه کسی این سند را نهایی کند. رئیس جمهور شهید به این نتیجه رسیدند که شورای عالی انقلاب فرهنگی محور باشد و شورای عالی فضای مجازی هم کمک کند. شورای عالی امنیت ملی هم به ما کمک کرد و دانشگاههای مختلف و معاونت علمی ریاست جمهوری همه درگیر شدند. در حال حاضر شورای عالی انقلاب فرهنگی وظیفه سیاستگذاری، هماهنگی و نظارت کلان بر اجرای این سند را بر عهده دارد.

ساعی در پاسخ به پرسشی درباره بازخوردها به سند نهایی توضیح داد: یک سند که تصویب می شود قطعا همه را راضی نمی کند. همه ممکن است اشکالاتی به سند داشته باشند. سعی شد که نظر مجموعه همه ذینفعان و ذیربطان هوش مصنوعی گرفته شود.

عضو شورای عالی انقلاب فرهنگی با تاکید بر این که اولویتهای ملی بهکارگیری هوش مصنوعی مشخص شده است اظهار داشت: این سند نقطه شروع است. هوش مصنوعی یک حوزه متحول شونده است. ممکن است دو سال دیگر وضعیت خیلی متفاوت باشد. شاید دو سال دیگر ما خودمان این سند را بازنگری کنیم. ولی الان یک سند ملی است که وظیفه دستگاهها و اولویتهای کشور را مشخص کرده است. ممکن است در یک رفت و برگشت نیاز به اصلاحاتی داشته باشد. این سند به تقویت بنیانهای علمی و پژوهشی کشور کمک خواهد کرد.

وی در پاسخ به این سوال که آیا هوش مصنوعی را تهدید یا فرصت میدانید بیان کرد: اگر فعالانه وارد بحث هوش مصنوعی شویم فرصت است و اگر فعالانه وارد نشویم حتما تهدید است. باید روی هوش مصنوعی سرمایه گذاری صورت بگیرد و همه بخشهای کشور مثل رسانهها، آموزش و پرورش، حمل و نقل، دانشگاهها و ... نسبت خودشان را با هوش مصنوعی تعیین کنند.

ساعی افزود: رقبای منطقهای ما با کمک کشورهای غربی خیلی روی هوش مصنوعی تمرکز کردهاند. اگر دولت کمک کند امیدواریم در ۵ سال آینده کشور برتر در منطقه خودمان در حوزه هوش مصنوعی باشیم. چون ظرفیت انسانی قابل توجهی داریم.

به گزارش ایرنا، سند ملی هوش مصنوعی جمهوری اسلامی ایران که در جلسه ۹۰۱ تاریخ ۲۹ خردادماه ۱۴۰۳ شورای عالی انقلاب فرهنگی به تصویب رسید، خطاب به نهاد ریاست جمهوری، هیات وزیران، ستاد کل نیروهای مسلح، معاونت علمی، فناوری و اقتصاد دانشبنیان رئیس جمهور، وزارت ارتباطات و فناوری اطلاعات، وزارت علوم، تحقیقات و فناوری، وزارت بهداشت، درمان و آموزش پزشکی، وزارت صنعت، معدن و تجارت، وزارت تعاون، کار و رفاه اجتماعی، وزارت دفاع و پشتیبانی نیروهای مسلح، وزارت اطلاعات، وزارت فرهنگ و ارشاد اسلامی، مرکز مدیریت حوزههای علمیه، سازمان اداری و استخدامی کشور، سازمان ملی هوش مصنوعی، مرکز ملی فضای مجازی و ستاد علم، فناوری و نوآوری دبیرخانه شورای عالی انقلاب فرهنگی برای اجرا، ابلاغ شد.

علم داده توانایی آن را دارد که در میان انبوهی از دادهها، الگوها و روابط پنهان را شناسایی کند و این الگوها همان بینشی است که میتوان از دادهها استخراج کرد. این بینش بسته به نوع داده در حوزههای مختلف کاربرد دارد از دادههای هواشناسی گرفته تا تحلیل بازارهای مالی و بورس. بدون شک یکی از علومی که در آینده نیاز شدیدی به آن در بازار کار احساس خواهد شد علم داده است

علم داده ترکیبی از دانشهای متنوع شامل آمار، یادگیری ماشین، برنامهنویسی و تخصصهای حوزههای کاربردی است و به گفته متخصصان، ارزشمندترین داراییهای یک سازمان پس از نیروی انسانی، دادهها هستند. همچنین دادهها به عنوان «سوخت اصلی» سیستمهای هوش مصنوعی و یادگیری ماشین عمل میکنند، چراکه با استفاده از تحلیلهای علم داده، مدلهای یادگیری ماشین و توانایی پیشبینی و تصمیمگیری این مدلها ارتقا مییابد.

توسعه هوش مصنوعی، بدون اتکا بر داده باکیفیت ممکن نیست. کشورهای پیشرو در زمینه هوش مصنوعی، دادههای متقن و باکیفیتی را تولید کرده و بر پایه آن هوش مصنوعی خود را توسعه دادهاند.

رامین عابدیاصل، تحلیگر و کارشناس هوش مصنوعی دادهها را منبع گرانبهایی دانست که شرکتها و سازمانها برای حفظ مزیت رقابتی و اتخاذ تصمیمهای هوشمندانه خود نیاز به تحلیل و استفاده بهینه از دادهها دارند، او گفت: علم داده به عنوان یکی از برجستهترین رشتههای چندمنظوره، ابزارهای قدرتمندی در اختیار ما قرار میدهد تا از دریای وسیع دادهها، دانش و بینش استخراج کنیم و با پیشرفتهای چشمگیر در حوزه هوش مصنوعی و یادگیری ماشین، علم داده به پلی میان فناوری و تصمیمگیریهای استراتژیک تبدیل شده است.

وی علم داده را ترکیبی از دانشهای متنوع شامل آمار، یادگیری ماشین، برنامهنویسی و تخصصهای حوزههای کاربردی دانست که به تحلیل دادههای ساختاریافته و غیرساختاریافته کمک میکند و ادامه داد: در حالی که تحلیل داده بیشتر بر استفاده از روشهای آماری برای بررسی دادههای گذشته متمرکز است، علم داده با رویکرد پیشبینی و مدلسازی پیشرفته به کشف الگوهای پنهان و ایجاد سیستمهای هوشمند میپردازد. تفاوت اصلی علم داده با آمار در این است که علم داده از ترکیبی گستردهتر از ابزارها و الگوریتمها از جمله یادگیری ماشین و شبکههای عصبی برای تحلیل حجم وسیعی از دادههای متنوع استفاده میکند.

عابدیاصل تأکید کرد: علم داده توانایی آن را دارد که در میان انبوهی از دادهها، الگوها و روابط پنهان را شناسایی کند و این الگوها همان بینشی است که میتوان از دادهها استخراج کرد. این بینش بسته به نوع داده در حوزههای مختلف کاربرد دارد؛ از دادههای هواشناسی گرفته تا تحلیل بازارهای مالی و بورس. بدون شک، یکی از علومی که در آینده نیاز شدیدی به آن در بازار کار احساس خواهد شد، علم داده است. به عنوان مشاور حوزه فناوری اطلاعات در چند سال گذشته تعداد زیادی از دانشجویان را به این رشته هدایت کردهام. میتوانم بگویم که این حوزه هم در داخل ایران و هم در خارج از کشور بازار کار بسیار خوبی دارد، همچنین این رشته میتواند ایدههای بسیاری برای کسبوکارهای استارتآپی ایجاد کند.

این تحلیلگر حوزه هوش مصنوعی با طرح این سؤال که چگونه علم داده به تصمیمگیری هوشمند در سازمانها کمک میکند، خاطر نشان کرد: به اعتقاد من، ارزشمندترین داراییهای یک سازمان، پس از نیروی انسانی، دادههای آن سازمان هستند و منظور من از دادهها تنها محتوای قابل ذخیره در بانکهای اطلاعاتی نیست، بلکه تمام ارزشها و موجودیتهای سازمان، از رفتار مشتریان گرفته تا نحوه تعامل کارمندان میتواند به عنوان داده سازمان دستهبندی شود. در این میان، علم داده به سازمانها کمک میکند از این دادهها برای تصمیمگیری استفاده کنند؛ تصمیماتی که دقیقتر و قابلاعتمادتر از روشهای سنتی هستند.

وی ادامه داد: برای مثال، با استفاده از مدلهای پیشبینی و تحلیل دادههای بزرگ، سازمانها قادرند رفتار مشتریان را پیشبینی کنند، بازاریابی هدفمندتری انجام دهند و حتی هزینههای عملیاتی خود را بهینهسازی کنند. علم داده با ارائه تحلیلهای عمیق و شناسایی الگوهای پنهان، به سازمانها این امکان را میدهد که آینده را با دقت بیشتری پیشبینی و استراتژیهای مؤثرتری پیادهسازی کنند.

ابزارها و تکنیکهای مورد نیاز در علم داده

عابدیاصل انتخاب ابزار برای انواع مختلف پردازشها را بسته به نوع و ساختار دادهها متفاوت دانست و گفت: به طور کلی ابزارها و تکنیکهای متنوعی در علم داده به کار میروند که شامل زبانهای برنامهنویسی مانند Python و R، کتابخانههای یادگیری ماشین همچون TensorFlow و Scikit- learn و پلتفرمهای کلانداده مانند Hadoop و Spark است. این ابزارها به متخصصان علم داده کمک میکنند دادههای خام را پردازش کنند، مدلهای پیچیده بسازند و نتایج قابل تفسیر ارائه دهند، همچنین ابزارهایی مانند Jupyter Notebook محیط مناسبی برای آزمایش و توسعه مدلهای علم داده فراهم میکنند، به طوری که امکان ترکیب تحلیلهای مختلف و تصویریسازی دادهها را بهبود میبخشند.

وی تأکید دارد: تمام چالشهای این فناوری از ذخیرهسازی و مدیریت دادهها تا پردازش آنها حول محور داده میچرخند. یکی از بزرگترین چالشها، حجم عظیم دادههاست که نیاز به ذخیرهسازی و پردازش کارآمد دارد. علاوه بر حجم، تنوع دادهها از منابع مختلف مانند دادههای ساختاریافته و غیرساختاریافته و همچنین سرعت تولید داده نیز چالشهای دیگری را به وجود میآورند و مدیریت این دادهها نیازمند زیرساختهای پیشرفته و مقیاسپذیر است. به عنوان مثال، استفاده از سیستمهای توزیعشده و ذخیرهسازی ابری میتواند به سازمانها کمک کند به طور مؤثرتری به این چالشها پاسخ دهند.

این کارشناس حوزه داده اضافه کرد: امنیت و حفظ حریم خصوصی دادهها به دلیل حساسیت اطلاعات در بسیاری از حوزهها، چالش مهم دیگری است که سازمانها باید با آن مواجه شوند. اطمینان از اینکه دادهها به طور ایمن ذخیره و منتقل میشوند و در عین حال حریم خصوصی افراد حفظ میشود، از الزامات کلیدی در عصر دیجیتال است.

آینده علم داده چگونه خواهد بود؟

عابدیاصل به ایسنا گفت: شاید این تعریف که «دانش از داده به دست میآید» برای اکثر افرادی که در رشتههای کامپیوتر تحصیل کردهاند، آشنا باشد. بله، دانش از داده به دست میآید، بنابراین داده و علمی که مسئولیت پردازش داده را دارد، میتواند بسیار مهم باشد، از این رو با توجه به رشد سریع حوزههای مرتبط با علم داده، آینده این رشته بسیار روشن به نظر میرسد و پیشبینی میشود نقش آن در تحولات فناوری افزایش یابد. همچنین با رشد هوش مصنوعی، اینترنت اشیا و پردازشهای ابری، علم داده به یک بخش جداییناپذیر از تحول دیجیتال تبدیل خواهد شد.

به گفته وی کاربردهای علم داده در حوزههای پیشرفتهتری مانند پزشکی شخصیسازیشده، خودروهای خودران و شهرهای هوشمند به طور گستردهتری به کار گرفته خواهند شد. علاوه بر این، علم داده با ایجاد مدلهای پیشبینی دقیقتر و سیستمهای خودمختار، به تغییر فرایندهای کسبوکار و بهینهسازی تصمیمگیریها کمک شایانی خواهد کرد.

چه مهارتها و تخصصهایی برای ورود به حوزه علم داده لازم است؟

این تحلیلگر حوزه هوش مصنوعی اضافه کرد: افرادی که توانایی تحلیل بالایی دارند، میتوانند در علم داده به افراد نخبه این رشته تبدیل شوند، چراکه خوراک اصلی این رشته تحلیل و تحلیلگربودن است. در کل برای ورود به علم داده، تسلط به زبانهای برنامهنویسی مانند Python و R، آشنایی با الگوریتمهای یادگیری ماشین و درک عمیق از ریاضیات و آمار ضروری است، همچنین مهارتهای پردازش دادههای بزرگ و کار با پایگاههای داده، به همراه توانایی تصویریسازی دادهها از مهارتهای کلیدی محسوب میشوند.

وی ادامه داد: علاوه بر مهارتهای فنی، توانایی تجزیه و تحلیل کسبوکار و درک نیازهای مشتری نیز بسیار مهم است. بهروزبودن با ابزارهای جدید و یادگیری مداوم نیز از ویژگیهای ضروری متخصصان این حوزه است.

علم داده چه نقشی در هوش مصنوعی و یادگیری ماشین دارد؟

عابدی با تأکید بر اینکه علم داده و هوش مصنوعی به طور نزدیکی باهم در ارتباط هستند، اظهار کرد: دادهها به عنوان «سوخت اصلی» سیستمهای هوش مصنوعی و یادگیری ماشین عمل میکنند. با استفاده از تحلیلهای علم داده، مدلهای یادگیری ماشین بهبود مییابند و توانایی پیشبینی و تصمیمگیری این مدلها ارتقا پیدا میکند. علم داده با استفاده از الگوریتمهای یادگیری ماشین به تحلیل دادههای پیچیده و بزرگ کمک میکند و هوش مصنوعی با استفاده از این مدلها به تصمیمگیریهای خودکار میپردازد.

وی افزود: برای اینکه یک مدل هوش مصنوعی توسعه یابد، باید از سوی دادهها آموزش داده شود و دادههایی که برای آموزش این مدل نیاز هستند، باید از سوی متخصصان علم داده جمعآوری و پالایش شوند. همچنین بهترین الگوریتم برای اجرای مدل باید انتخاب شود. در نهایت، یک سیستم مبتنی بر هوش مصنوعی با استفاده از این دادهها و الگوریتم به نتیجه و پاسخ خواهد رسید، از این رو مراحل علم داده به این شرح است:

جمعآوری داده: دادهها از منابع مختلف جمعآوری میشوند و شامل دادههای ساختاریافته و غیرساختاریافته هستند.

پالایش و پیشپردازش داده: دادههای جمعآوریشده باید پاکسازی و پردازش شوند تا کیفیت و دقت آنها افزایش یابد. این مرحله شامل حذف دادههای نادرست، پرکردن دادههای مفقود و تبدیل فرمتهای داده است.

تحلیل اکتشافی داده (EDA): در این مرحله، دادهها بررسی و تحلیل میشوند تا الگوها و روابط موجود در آنها شناسایی شوند.

انتخاب ویژگی: انتخاب ویژگیهای مهم و تأثیرگذار روی مدل به بهبود دقت و کارایی آن کمک میکند.

ساخت و آموزش مدل: الگوریتمهای یادگیری ماشین، انتخاب و مدل ساخته میشود، سپس مدل با استفاده از دادههای آموزشی آموزش داده میشود.

ارزیابی مدل: مدل آموزش دیده با استفاده از دادههای آزمون ارزیابی میشود تا دقت و قابلیت پیشبینی آن مشخص شود.

استقرار مدل: مدل نهایی در محیط عملیاتی مستقر میشود و آماده استفاده در فرایندهای تصمیمگیری است.

نظارت و بهروزرسانی: مدل به طور مداوم نظارت و بهروزرسانی میشود تا عملکرد آن حفظ شود و با تغییرات دادهها سازگار باشد.

وی یادآور شد: تقریباً میتوان گفت علم داده در تمام صنایع قابل استفاده است، از جمله در حوزههای مالی، بهداشت و درمان، تجارت الکترونیک و حملونقل. در صنعت مالی، علم داده به تحلیل ریسک، پیشبینی بازار و کشف تقلب کمک میکند. در حوزه بهداشت، از دادهها برای پیشبینی بیماریها، تحلیل نتایج درمان و بهینهسازی عملیات بیمارستانی استفاده میشود. تجارت الکترونیک نیز از علم داده برای تحلیل رفتار مشتری، سفارشیسازی پیشنهادات و بهبود تجربه کاربر بهره میبرد. صنعت حملونقل از دادههای بزرگ برای بهینهسازی مسیرها و مدیریت ترافیک استفاده میکند و البته هر روز بر دامنه این صنایع و کاربردهای آن افزوده میشود.

مدیریت مسائل اخلاقی مرتبط با علم داده

این تحلیلگر حوزه هوش مصنوعی، حفظ حریم خصوصی و عدالت الگوریتمها را دو چالش مهم در علم داده عنوان کرد و گفت: به دلیل حجم عظیم دادههای شخصی که از سوی شرکتها جمعآوری میشود، حفظ حریم خصوصی افراد بسیار مهم است، همچنین عدالت در الگوریتمها به این معناست که مدلهای یادگیری ماشین باید از تبعیض جلوگیری کنند و بر اساس دادههای مغرضانه تصمیم نگیرند. برای مدیریت این چالشها، لازم است قوانین و مقررات سختگیرانهتری وضع شود و شفافیت در فرایندهای علم داده افزایش یابد و البته نکته بسیار مهمی که وجود دارد، این است که کشورها و شرکتهای پیشرو در زمینه علم داده و پردازشها و آنهایی که دادههای عظیم در اختیار دارند، نقش مهمی در آینده این علم و مسیری که میتواند طی کند، خواهند داشت.

به گفته وی، چالشهای اصلی توسعه علم داده در ایران را میتوان در چندین حوزه کلیدی دستهبندی کرد که شامل زیرساختهای تکنولوژیک، منابع انسانی، فرهنگ سازمانی و چالشهای قانونی و اخلاقی میشود، اما در کنار این چالشها، فرصتهای بسیار بزرگی نیز وجود دارد که در صورت مدیریت صحیح، میتوانند به تحول دیجیتال و بهبود تصمیمگیری هوشمند در سازمانهای ایرانی منجر شوند. از دیگر چالشهای علم داده در کشور میتوان به این موارد اشاره کرد:

۱. کمبود زیرساختهای تکنولوژیک

یکی از چالشهای مهم در مسیر توسعه علم داده در ایران، ضعف زیرساختهای فناوری اطلاعات و ارتباطات (ICT) است. برای پردازش و مدیریت حجم عظیمی از دادهها، نیاز به زیرساختهای پیشرفتهای همچون سرورها، سیستمهای ابری و پلتفرمهای ذخیرهسازی داده بزرگ (Big Data) وجود دارد. در ایران، محدودیتهای موجود در این زمینه، بهویژه در استفاده از خدمات ابری جهانی و محدودیتهای پهنای باند، میتواند سرعت پیشرفت این حوزه را کند کند.

۲. کمبود نیروی انسانی متخصص

علم داده به عنوان یک رشته چندمنظوره نیازمند نیروی انسانی با تخصصهای مختلف از جمله برنامهنویسی، آمار، یادگیری ماشین و تحلیل کسبوکار است. در ایران، کمبود نیروی متخصص و نبود دورههای آموزشی پیشرفته و کاربردی یکی از موانع اصلی است. بسیاری از دانشگاهها هنوز برنامههای آموزشی مناسبی برای تربیت متخصصان علم داده ندارند و تنها به جنبههای تئوریک میپردازند.

۳. فرهنگ سازمانی و مقاومت در برابر تغییر

یکی دیگر از چالشهای بزرگ، عدمتمایل برخی سازمانها به پذیرش فرهنگ دادهمحور است. بسیاری از سازمانهای کشور هنوز تصمیمگیریهای خود را بر اساس تجربیات گذشته و روشهای سنتی انجام میدهند و به جای استفاده از دادهها و مدلهای پیشبینی به عوامل دیگری اعتماد میکنند.

۴. مسائل قانونی و اخلاقی

یکی از موضوعات حساس در علم داده، حفظ حریم خصوصی و امنیت دادههاست. با توجه به اینکه بسیاری از دادهها در ایران به صورت غیرساختاریافته و بدون نظارت دقیق جمعآوری میشوند، نگرانیهای زیادی در مورد سوءاستفاده از دادهها و نقض حریم خصوصی افراد وجود دارد.

عابدیاصل خاطر نشان کرد: در کل اگر بخواهیم جمعبندی داشته باشیم، علم داده به عنوان یکی از مهمترین حوزههای فناوری در دنیای امروز، نقشی کلیدی در پیشرفتهای فناوری و تصمیمگیریهای هوشمند دارد. این حوزه با ترکیب تحلیلهای پیچیده داده و ابزارهای پیشرفته، به سازمانها کمک میکند از دادههای خود بهترین بهره را ببرند. آینده علم داده با توجه به پیشرفتهای هوش مصنوعی و یادگیری ماشین بسیار روشن است و انتظار میرود تأثیر آن بر صنایع و زندگی روزمره ما بیشتر از گذشته شود.

منبع: روزنامه جوان

رئیسجمهور و رئیس شورای عالی انقلاب ماده واحده «تکمیل ترکیب شورای ملی راهبری هوش مصنوعی» مصوب شورای عالی انقلاب فرهنگی، را برای اجرا ابلاغ کرد.

به گزارش شورای عالی انقلاب فرهنگی ماده واحده «تکمیل ترکیب شورای ملی راهبری هوش مصنوعی» در جلسه ۹۰۵ به تاریح ۱۷ مهرماه امسال شورای عالی انقلاب فرهنگی و بنا به پیشنهاد قوه قضائیه و سازمان صدا و سیما، به تصویب رسیده است که این ماده واحد از سوی مسعودپزشکیان به نهاد ریاست جمهوری، قوه قضائیه، سازمان صدا و سیما، معاونت علمی، فناوری و اقتصاد دانشبنیان ریاست جمهوری و سازمان ملی هوش مصنوعی برای اجرا ابلاغ شد.

«ماده واحده - ترکیب شورای ملی راهبری هوش مصنوعی موضوع ماده واحده «تشکیل شورای ملی راهبری و تأسیس سازمان ملی هوش مصنوعی» و بند ۳ ماده ۷ «سند ملی هوش مصنوعی جمهوری اسلامی ایران» (مصوب جلسه ۹۰۱ مورخ ۲۹/۰۳/۱۴۰۳ شورای عالی انقلاب فرهنگی) در بندهای ۱۸- رئیس مرکز آمار و فناوری اطلاعات قوه قضائیه و ۱۹- رئیس سازمان صدا و سیما یا نماینده تام الاختیار» تکمیل شد.

پیش از این ماده واحده «تشکیل شورای ملی راهبری و تأسیس سازمان ملی هوش مصنوعی» ۱۲ تیرماه امسال توسط محمد مخبر معاول اول دولت سیزدهم و مدیر قوه مجریه در جلسه ۹۰۱ و مصوبه شورای عالی انقلاب فرهنگی در۲۹ خرداد امسال ابلاغ شده بود.

بر این اساس «شورای ملی راهبری هوش مصنوعی» با ترکیب، ۱- رئیس جمهور به عنوان رئیس شورا، ۲- معاون علمی، فناوری و اقتصاد دانشبنیان ریاست جمهوری به عنوان نایب رئیس شورا، ۳- دبیر شورای عالی انقلاب فرهنگی یا معاون ذیربط، ۴- دبیر شورای عالی فضای مجازی یا معاون ذیربط؛، ۵-وزیر ارتباطات و فناوری اطلاعات یا معاون ذیربط، ۶- وزیر علوم، تحقیقات و فناوری یا معاون ذیربط، ۷- وزیر بهداشت، درمان و آموزش پزشکی یا معاون ذیربط، ۸- وزیر صنعت، معدن و تجارت یا معاون ذیربط، ۹- وزیر تعاون، کار و رفاه اجتماعی یا معاون ذیربط، ۱۰- رئیس ستاد کل نیروهای مسلح یا معاون ذیربط، ۱۱- وزیر دفاع و پشتیبانی نیروهای مسلح یا معاون ذیربط، ۱۲-وزیر اطلاعات یا معاون ذیربط، ۱۳- رئیس سازمان اداری و استخدامی یا معاون ذیربط، ۱۴- وزیر فرهنگ و ارشاد اسلامی یا معاون ذیربط، ۱۵- رئیس مرکز مدیریت حوزههای علمیه یا معاون ذیربط، ۱۶ و ۱۷- دو نفر عضو حقیقی به پیشنهاد دبیر شورا و با حکم رئیس شورا و رئیس سازمان ملی هوش مصنوعی به عنوان دبیر شورا تشکیل می شود.

حال با اضافه شدن رئیس مرکز آمار و فناوری اطلاعات قوه قضائیه و رئیس سازمان صدا و سیما یا نماینده تام الاختیار ترکیب شورا ۲۰ نفر شد.

ابزار هوش مصنوعی اوپن ای آی برای تبدیل صوت به متن، جملاتی می سازد و به متن می افزاید که باعث ایجاد چالش جدیدی شده است.

به گزارش خبرگزاری مهر به نقل از آسوشیتدپرس، شرکت «اوپن ای آی» ابزار رونویسی مبتنی بر هوش مصنوعی خود به نام «ویسپر» (Wisper) را با ادعای آنکه دقت و قدرتی معادل یک کاربر انسانی دارد، عرضه کرده است.

اما ویسپر یک چالش اساسی دارد. به گفته مهندسان نرم افزار، توسعه دهندگان و محققان آکادمیک ممکن است این ابزار بخشی از متن یا حتی جملاتی کامل را خودش بنویسد. این کارشناسان معتقدند برخی از متن های اختراعی این ابزار ممکن است حاوی اظهارات نژادی، خشونت آمیز یا حتی درمان های پزشکی خیالی باشد.

به گفته آنها چنین جملاتی مشکل ساز هستند زیرا از این ابزار در چند صنعت در سراسر جهان برای تبدیل مصاحبه ها، تولید متن در زمینه فناوری های مصرفی محبوب و ساخت زیرنویس برای ویدئوها استفاده می شود.

نکته نگران کننده تر، عجله مراکز پزشکی برای استفاده از ابزارهای مبتنی بر ویسپر برای رونویسی مشاوره های بیماران با پزشکان است. حال آنکه اوپن ای آی قبلا هشدار داده از این ابزار نباید در حوزه هایی با ریسک زیاد استفاده شود.

گستره کامل این مشکل را به سختی می توان تعیین کرد اما محققان و مهندسان اعلام کرده اند در فعالیت هایشان اغلب با توهمات ابداعی ویسپر روبرو شده اند. به عنوان مثال یک محقق دانشگاه میشیگان مشغول انجام تحقیقی از جلسات عمومی بود و در هر ۱۰ رونویسی کلیپ صوتی که او بررسی کرده بود ۸ مورد حاوی توهمات ویسپر بودند. پس از آن وی تلاش خود برای ارتقای این مدل هوش مصنوعی را آغاز کرد.

یک مهندس یادگیری ماشینی نیز می گوید او بیش از ۱۰۰ ساعت نمونه رونویسی که ویسپر انجام داده بود را تحلیل و در حدود نیمی از آنها توهمات این هوش مصنوعی را مشاهده کرده است. محقق سومی نیز مدعی شده هنگام بررسی ۲۶ هزار متنی که با کمک ویسپر ابداع شده، تقریبا در هر یک از رونویسی ها توهمات این ابزار را مشاهده کرده است.

این چالش حتی در رونویسی از نمونه های کوتاه و با کیفیت صوتی نیز وجود دارد.

رئیس سازمان پدافند غیرعامل کشور گفت: الگوهای تهدید و حملات مبتنی بر هوش مصنوعی در حال افزایش هستند. از همین رو شناسایی و رفع آسیبپذیریها در سامانهها و اپلیکیشنها بسیار مهم است.

به گزارش پایگاه اطلاع رسانی پایداری ملی، همزمان با آغاز ایام نکوداشت پدافند غیرعامل، نخستین نشست تخصصی هم افزایی پدافند و امنیت سایبری با حضور سردار غلامرضا جلالی؛ رئیس سازمان پدافند غیرعامل کشور، سردار فرجی پور جانشین قرارگاه پدافند سایبری کشور و جمعی کارشناسان و نخبگان حوزه امنیت سایبری در تالار شهید آبشناسان سازمان پدافند غیرعامل کشور برگزار شد.

سردار جلالی در این نشست با اشاره به ماهیت دوگانه تهدیدات سایبری-فیزیکی در عصر هوش مصنوعی، اظهار داشت: تهدیدات سایبری-فیزیکی، ماهیت فیزیکی و سایبری توامان دارند. طبیعتاً در مواجهه با این مقوله فناوری که ماهیت سیال و پویا دارد، باید دفاعی هوشمند و روزآمد به کار گرفته شود.

تغییر ماهیت تهدیدات و ظهور راهبردهای نوین

رئیس سازمان پدافند غیرعامل کشور با بیان اینکه فناوریها علاوه بر تسهیل زندگی بشر به منظور کنترل، اشراف و جمعآوری داده در جهان مورد استفاده قرار میگیرند، تصریح کرد: این امر منجر به تسلیم ناخواسته افراد به اشراف اطلاعاتی میشود. با توجه به اینکه این فناوریها توسط اشخاصی با اراده و برنامه خاص توسعه داده میشوند، باید به انگیزههای پشت پرده آنها توجه کرد.

تبیین نقشه راه پدافند غیرعامل در استفاده از هوش مصنوعی